multi task cs lm

1.0.0

使用语法意识多任务学习(语言代码转换中的计算方法中的第三个研讨会,ACL 2018)的论文实施代码转换语言建模。该代码使用Pytorch用Python编写。

可以在此处找到补充材料(包括火车,开发和测试的分布)。

如果您使用此工具包中包含的任何源代码或数据集,请引用以下论文。 Bibtex在下面列出:

@inproceedings {W18-3207,

作者=“ Winata,Genta Indra

和Madotto,Andrea

和吴,奇恩

和芬格,帕斯卡尔”,

title =使用语法意识多任务学习的“代码转换语言建模”,

BookTitle =“关于语言代码转换计算方法的第三次研讨会论文集”,

年=“ 2018”,

发布者=“计算语言学协会”,

页=“ 62---67”,

位置=“澳大利亚墨尔本”,

url =“ http://aclweb.org/anthology/w18-3207”

}

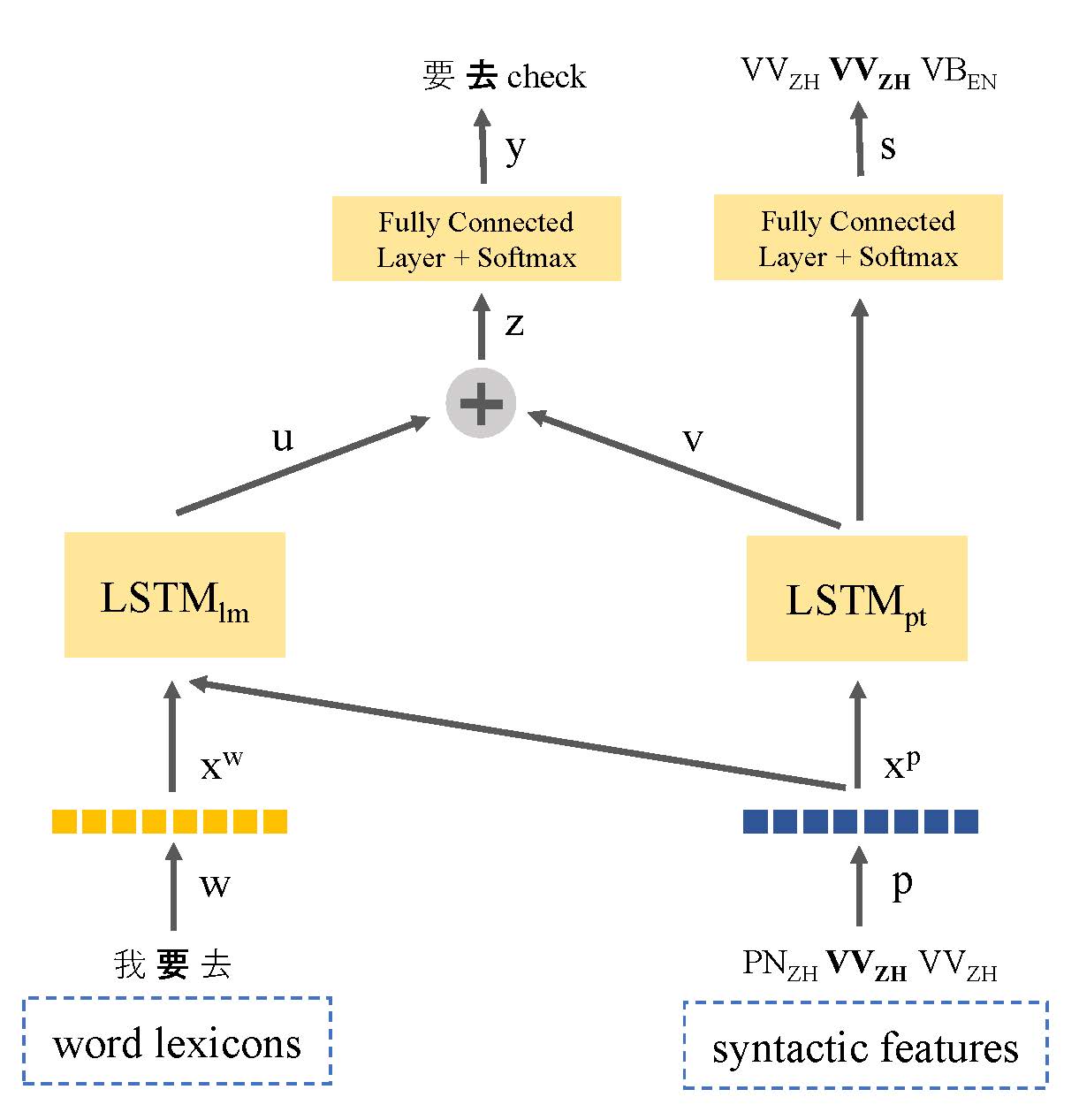

缺乏文本数据一直是代码转换语言建模的主要问题。在本文中,我们介绍了基于多任务学习的语言模型,该模型共享语言的语法表示,以利用语言信息并解决低资源数据问题。我们的模型共同学习了语言建模和言论的一部分标记,这是在代码切换的话语上。通过这种方式,该模型能够识别代码转换点的位置,并改善下一个单词的预测。我们的方法表现优于基于标准LSTM的语言模型,在接缝I期和II期数据集上的困惑分别提高了9.7%和7.4%。

LDC的Seame语料库:东南亚的普通话 - 英语密码开关

多任务

❱❱❱ python main_multi_task.py --tied --clip=0.25 --dropout=0.4 --postagdropout=0.4 --p=0.25 --nhid=500 --postagnhid=500 --emsize=500 --postagemsize=500 --cuda --data=../data/seame_phase2