QnA With RAG

1.0.0

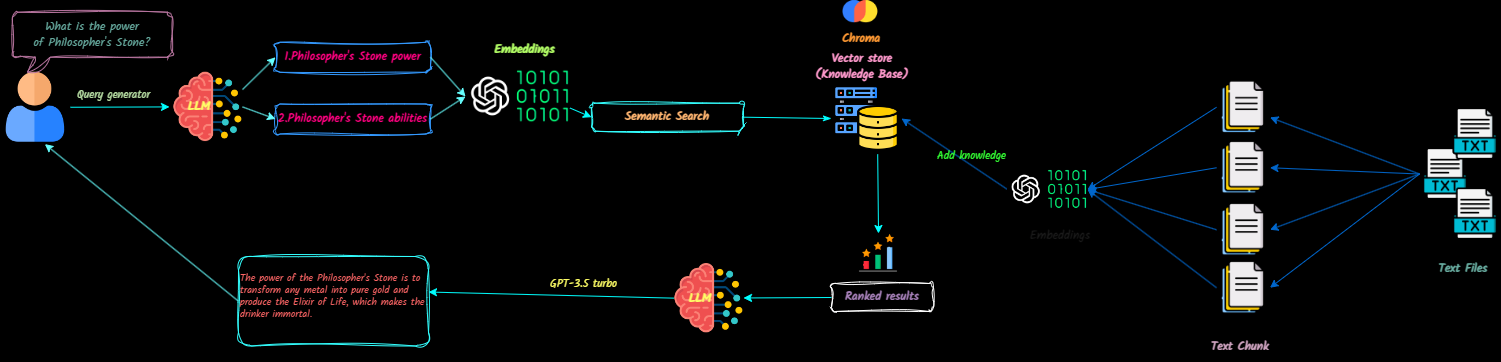

QNA-With-rag是一个全堆栈应用程序,它将文本文档转换为大型语言模型(LLMS)的上下文,以参考聊天期间。您可以轻松添加,删除文档并创建多个知识库。

该项目旨在使用OpenAI API创建一个可以生产的聊天机器人。它结合了VectordB和Langsmith以增强其功能。

在此处观看应用程序的演示。

未来更新将包括:

克隆存储库

git clone [email protected]:Ja-yy/QnA-With-RAG.git设置环境变量

创建一个带有以下内容的.env文件:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

构建并运行应用程序

执行以下命令:

docker-compose up -d --build访问应用程序

打开您的Web浏览器,然后转到Localhost开始使用该应用程序。

NGINX配置

nginx目录中正确设置您的NGINX配置文件,以获得最佳性能。 如果我遇到问题,该怎么办?

docker-compose logs检查日志是否有故障排除。我该如何贡献?

喜欢使用该应用! :)