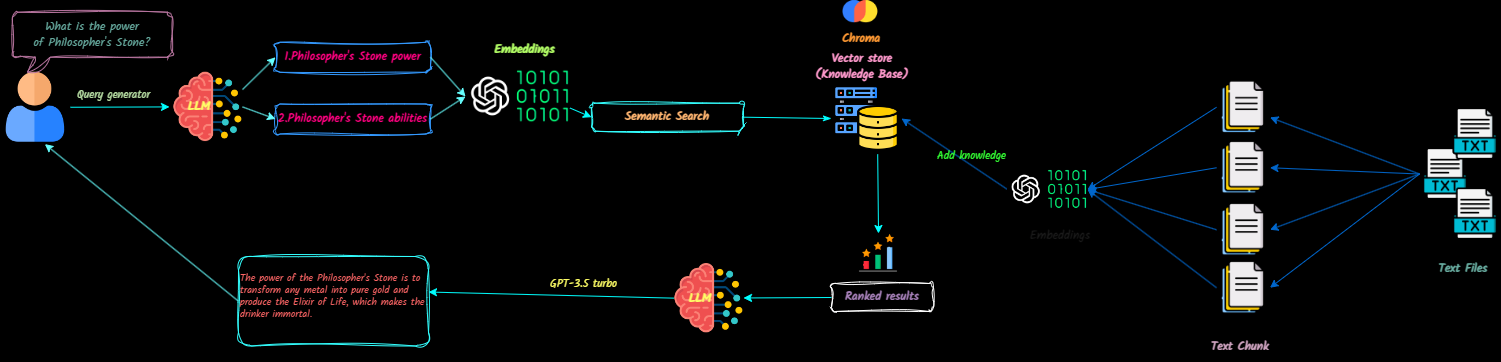

QNA-With-Rag est une application complète qui transforme les documents texte en contexte pour les modèles de grande langue (LLM) pour référence pendant les chats. Vous pouvez facilement ajouter, supprimer des documents et créer plusieurs bases de connaissances.

Ce projet vise à créer un chatbot prêt pour la production à l'aide de l'API OpenAI. Il intègre VectordB et Langsmith pour améliorer sa fonctionnalité.

Regardez une démo de l'application ici.

Les futures mises à jour comprendront:

Cloner le référentiel

git clone [email protected]:Ja-yy/QnA-With-RAG.gitConfigurer des variables d'environnement

Créez un fichier .env avec le contenu suivant:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

Construire et exécuter l'application

Exécutez la commande suivante:

docker-compose up -d --buildAccéder à la demande

Ouvrez votre navigateur Web et allez sur LocalHost pour commencer à utiliser l'application.

Configuration Nginx

nginx pour des performances optimales. Que dois-je faire si je rencontre des problèmes?

docker-compose logs pour le dépannage.Comment puis-je contribuer?

Profitez d'utiliser l'application! :)