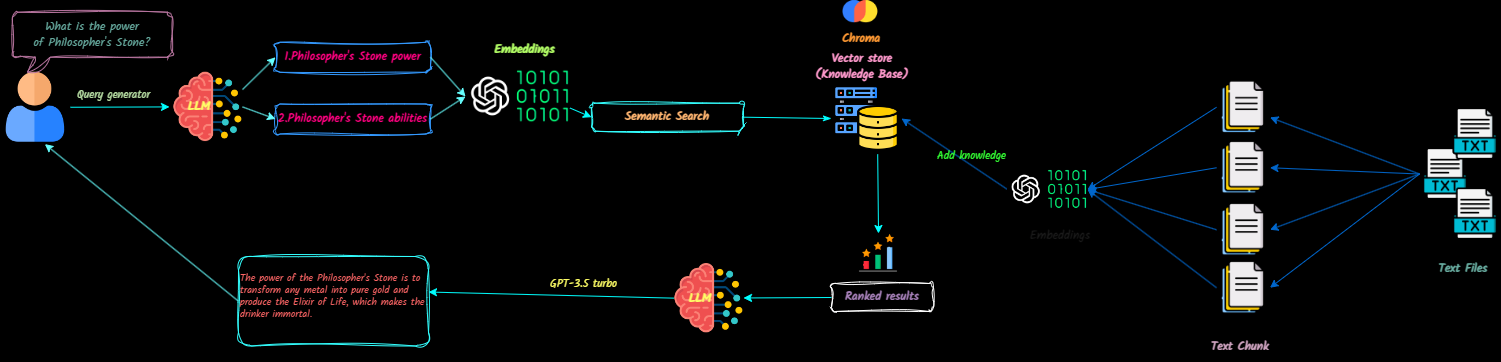

O QNA-WITH-RAG é um aplicativo de pilha completa que transforma documentos de texto em contexto de grandes modelos de idiomas (LLMS) para referência durante os bate-papos. Você pode adicionar facilmente, excluir documentos e criar várias bases de conhecimento.

Este projeto tem como objetivo criar um chatbot pronto para produção usando a API OpenAI. Ele incorpora o VectordB e o Langsmith para melhorar sua funcionalidade.

Assista a uma demonstração do aplicativo aqui.

As atualizações futuras incluirão:

Clone o repositório

git clone [email protected]:Ja-yy/QnA-With-RAG.gitConfigurar variáveis de ambiente

Crie um arquivo .env com o seguinte conteúdo:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

Construa e execute o aplicativo

Execute o seguinte comando:

docker-compose up -d --buildAcesse o aplicativo

Abra seu navegador da web e vá ao localhost para começar a usar o aplicativo.

Configuração Nginx

nginx para obter o melhor desempenho. O que devo fazer se encontrar problemas?

docker-compose logs para solucionar problemas.Como posso contribuir?

Aproveite o uso do aplicativo! :)