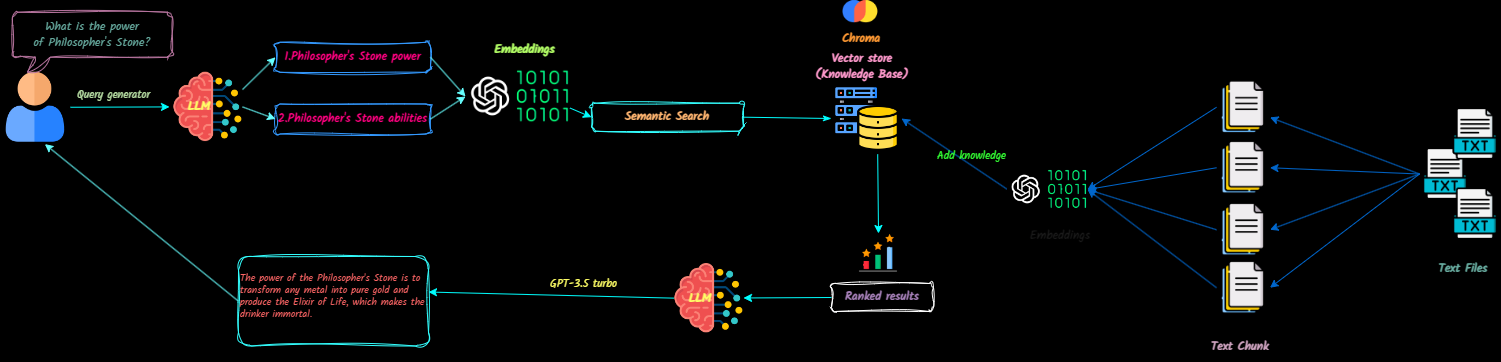

QNA-With-RAG-это приложение с полным стеком, которое преобразует текстовые документы в контекст для больших языковых моделей (LLMS) для ссылки во время чатов. Вы можете легко добавить, удалять документы и создать несколько баз знаний.

Этот проект направлен на создание готового производства чат-бота с использованием API OpenAI. Он включает в себя Vectordb и Langsmith для повышения его функциональности.

Посмотрите демонстрацию приложения здесь.

Будущие обновления будут включать в себя:

Клонировать репозиторий

git clone [email protected]:Ja-yy/QnA-With-RAG.gitНастройка переменных среды

Создайте файл .env с помощью следующего контента:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

Создать и запустить приложение

Выполнить следующую команду:

docker-compose up -d --buildПолучить доступ к приложению

Откройте свой веб -браузер и перейдите в Localhost, чтобы начать использовать приложение.

Конфигурация NGINX

nginx для оптимальной производительности. Что мне делать, если я столкнусь с проблемами?

docker-compose logs для устранения неполадок.Как я могу внести свой вклад?

Наслаждайтесь использованием приложения! :)