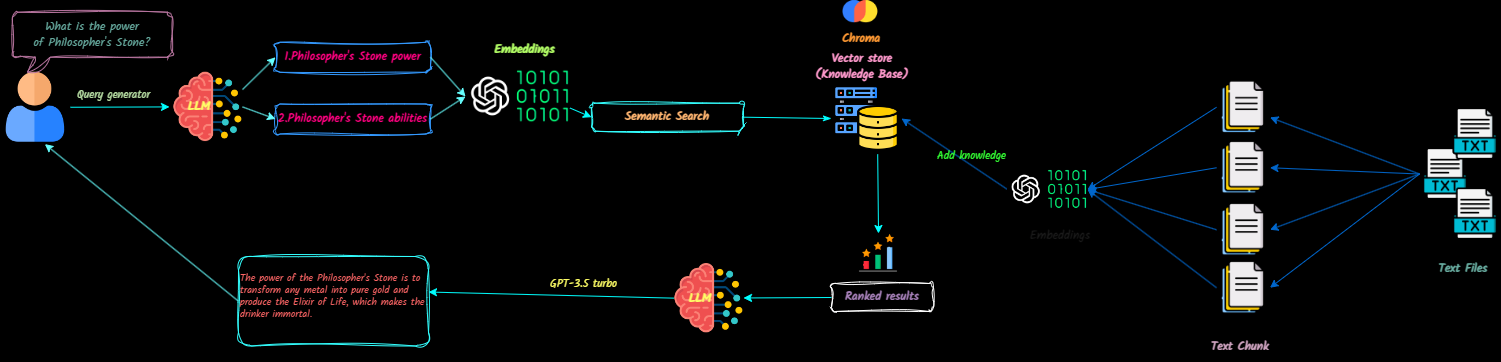

QNA-With-Rag es una aplicación de pila completa que transforma los documentos de texto en contexto para modelos de idiomas grandes (LLM) para hacer referencia durante los chats. Puede agregar fácilmente, eliminar documentos y crear múltiples bases de conocimiento.

Este proyecto tiene como objetivo crear un chatbot listo para la producción utilizando la API de OpenAI. Incorpora VectordB y Langsmith para mejorar su funcionalidad.

Mire una demostración de la aplicación aquí.

Las actualizaciones futuras incluirán:

Clonar el repositorio

git clone [email protected]:Ja-yy/QnA-With-RAG.gitConfigurar variables de entorno

Cree un archivo .env con el siguiente contenido:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

Construir y ejecutar la aplicación

Ejecutar el siguiente comando:

docker-compose up -d --buildAcceder a la aplicación

Abra su navegador web y vaya a localhost para comenzar a usar la aplicación.

Configuración de Nginx

nginx para un rendimiento óptimo. ¿Qué debo hacer si encuentro problemas?

docker-compose logs para la resolución de problemas.¿Cómo puedo contribuir?

¡Disfruta usando la aplicación! :)