QnA With RAG

1.0.0

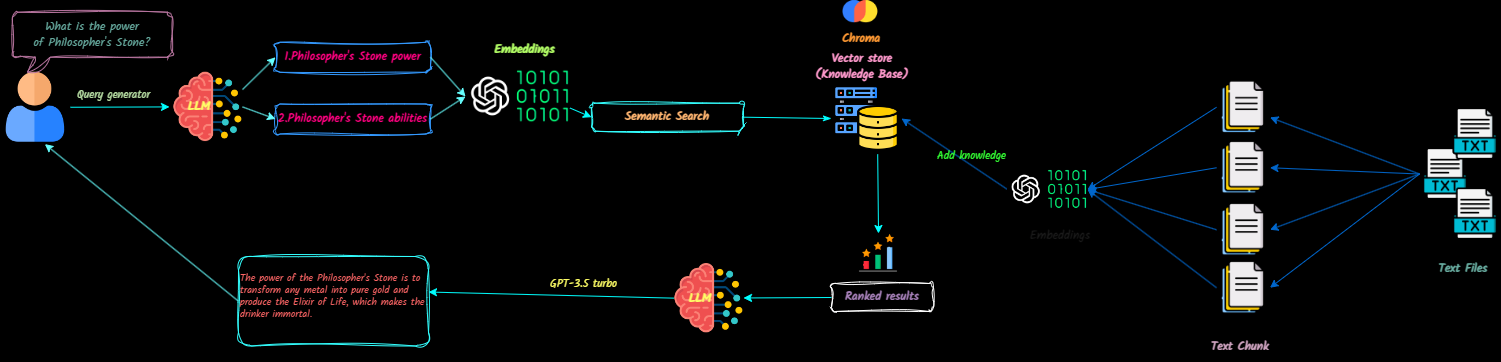

Qna-with-ragは、チャット中に参照するために、テキストドキュメントを大規模な言語モデル(LLM)のコンテキストに変換するフルスタックアプリケーションです。ドキュメントを簡単に追加、削除し、複数の知識ベースを作成できます。

このプロジェクトは、OpenAI APIを使用して制作可能なチャットボットを作成することを目的としています。 VectordbとLangsmithが機能して機能を強化します。

ここでアプリケーションのデモをご覧ください。

将来の更新には次のものが含まれます。

リポジトリをクローンします

git clone [email protected]:Ja-yy/QnA-With-RAG.git環境変数を設定します

次のコンテンツで.envファイルを作成します。

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

アプリケーションを構築して実行します

次のコマンドを実行します。

docker-compose up -d --buildアプリケーションにアクセスします

Webブラウザを開き、LocalHostに移動してアプリの使用を開始します。

nginx構成

nginxディレクトリに正しく設定されていることを確認して、最適なパフォーマンスを提供します。 問題が発生した場合はどうすればよいですか?

docker-compose logsを使用してログを確認してください。どうすれば貢献できますか?

アプリを使用して楽しんでください! :)