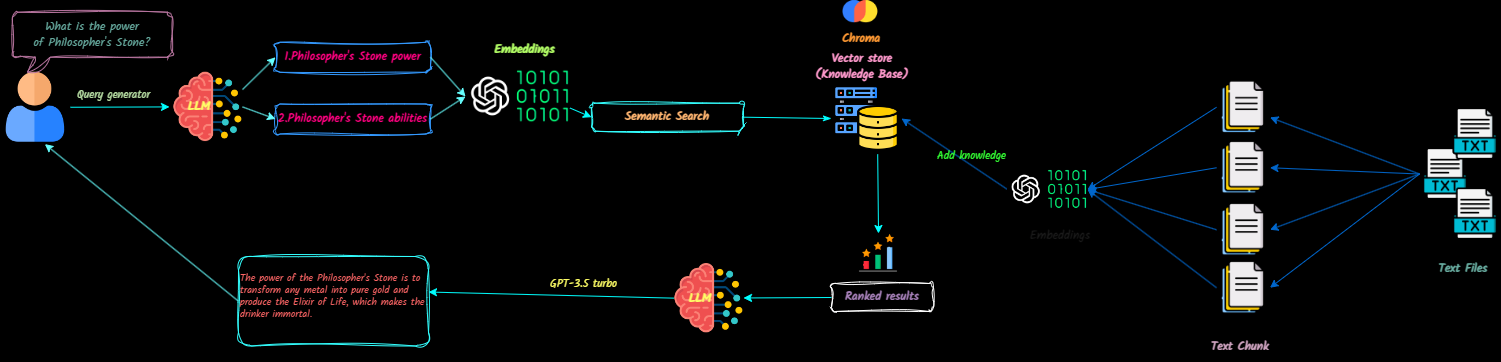

QNA-with-Rag ist eine Vollstapelanwendung, die Textdokumente für große Sprachmodelle (LLMs) in den Chats in den Kontext verwandelt. Sie können Dokumente einfach hinzufügen, löschen und mehrere Wissensbasis erstellen.

Dieses Projekt zielt darauf ab, einen produktionsbereiten Chatbot mithilfe der OpenAI-API zu erstellen. Es enthält Vectordb und Langsmith, um seine Funktionalität zu verbessern.

Sehen Sie sich hier eine Demo der Anwendung an.

Zukünftige Updates umfassen:

Klonen Sie das Repository

git clone [email protected]:Ja-yy/QnA-With-RAG.gitUmgebungsvariablen einrichten

Erstellen Sie eine .env -Datei mit dem folgenden Inhalt:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

Erstellen und führen Sie die Anwendung aus

Führen Sie den folgenden Befehl aus:

docker-compose up -d --buildZugriff auf die Anwendung

Öffnen Sie Ihren Webbrowser und gehen Sie zu Localhost, um mit der App zu beginnen.

Nginx -Konfiguration

nginx -Verzeichnis eingerichtet sind. Was soll ich tun, wenn ich auf Probleme stoße?

docker-compose logs zur Fehlerbehebung.Wie kann ich dazu beitragen?

Genießen Sie es mit der App! :)