QnA With RAG

1.0.0

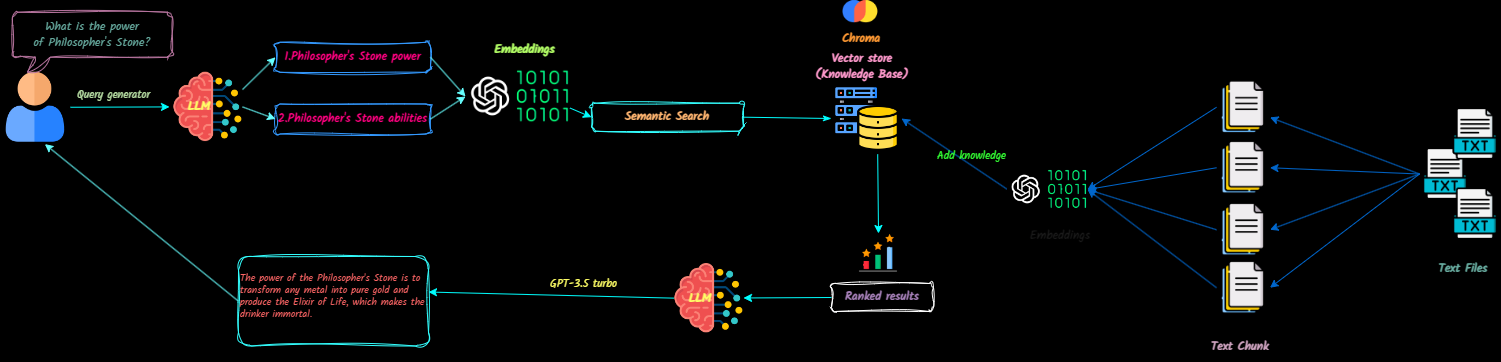

QNA-with-rag เป็นแอปพลิเคชั่นเต็มรูปแบบที่แปลงเอกสารข้อความเป็นบริบทสำหรับโมเดลภาษาขนาดใหญ่ (LLMs) เพื่ออ้างอิงในระหว่างการแชท คุณสามารถเพิ่มลบเอกสารและสร้างฐานความรู้หลายอย่างได้อย่างง่ายดาย

โครงการนี้มีจุดมุ่งหมายเพื่อสร้างแชทบ็อตพร้อมผลิตโดยใช้ OpenAI API มันรวม Vectordb และ Langsmith เพื่อปรับปรุงการทำงานของมัน

ดูตัวอย่างของแอปพลิเคชันที่นี่

การอัปเดตในอนาคตจะรวมถึง:

โคลนที่เก็บ

git clone [email protected]:Ja-yy/QnA-With-RAG.gitตั้งค่าตัวแปรสภาพแวดล้อม

สร้างไฟล์ .env ด้วยเนื้อหาต่อไปนี้:

OPENAI_API_KEY='<your_open_ai_key>'

EMBEDDING_MODEL='text-embedding-ada-002'

CHAT_MODEL='gpt-3.5-turbo'

TEMPERATURE=0

MAX_RETRIES=2

REQUEST_TIMEOUT=15

CHROMADB_HOST="chromadb"

CHROMADB_PORT="8000"

CHROMA_SERVER_AUTH_CREDENTIALS="<test-token>"

CHROMA_SERVER_AUTH_CREDENTIALS_PROVIDER="chromadb.auth.token.TokenConfigServerAuthCredentialsProvider"

CHROMA_SERVER_AUTH_PROVIDER="chromadb.auth.token.TokenAuthServerProvider"

CHROMA_SERVER_AUTH_TOKEN_TRANSPORT_HEADER="AUTHORIZATION"

สร้างและเรียกใช้แอปพลิเคชัน

ดำเนินการคำสั่งต่อไปนี้:

docker-compose up -d --buildเข้าถึงแอปพลิเคชัน

เปิดเว็บเบราว์เซอร์ของคุณและไปที่ LocalHost เพื่อเริ่มใช้แอพ

การกำหนดค่า nginx

nginx เพื่อประสิทธิภาพที่ดีที่สุด ฉันควรทำอย่างไรถ้าฉันพบปัญหา?

docker-compose logs สำหรับการแก้ไขปัญหาฉันจะมีส่วนร่วมได้อย่างไร?

สนุกกับการใช้แอพ! -