ในสาขาปัญญาประดิษฐ์ทีมห้องปฏิบัติการอาลีบาบา Tongyi เพิ่งประกาศแหล่งที่มาของแบบจำลองหลายรูปแบบล่าสุด - R1 -OMNI โมเดลนี้รวมการเรียนรู้การเสริมแรงเข้ากับวิธีการที่ผ่านการตรวจสอบแล้ว (RLVR) แสดงให้เห็นถึงความสามารถที่โดดเด่นในการประมวลผลข้อมูลเสียงและวิดีโอ ไฮไลต์ของ R1-OMNI คือความโปร่งใสทำให้เราเข้าใจบทบาทของรังสีต่าง ๆ ในกระบวนการตัดสินใจโดยเฉพาะอย่างยิ่งในงานต่าง ๆ เช่นการรับรู้อารมณ์

ด้วยการเปิดตัว Deepseek R1 ศักยภาพการใช้งานของการเรียนรู้การเสริมแรงในแบบจำลองขนาดใหญ่ได้รับการสำรวจอย่างต่อเนื่อง วิธี RLVR นำแนวคิดการเพิ่มประสิทธิภาพใหม่ไปยังงานหลายรูปแบบซึ่งสามารถจัดการงานที่ซับซ้อนได้อย่างมีประสิทธิภาพเช่นการอนุมานทางเรขาคณิตและการนับภาพ แม้ว่าการวิจัยในปัจจุบันมุ่งเน้นไปที่การรวมกันของรูปภาพและข้อความการสำรวจล่าสุดของห้องปฏิบัติการ Tongyi ได้ขยายสาขานี้รวม RLVR เข้ากับโมเดลวิดีโอเต็มรูปแบบแสดงให้เห็นถึงโอกาสในการใช้งานที่หลากหลายของเทคโนโลยี

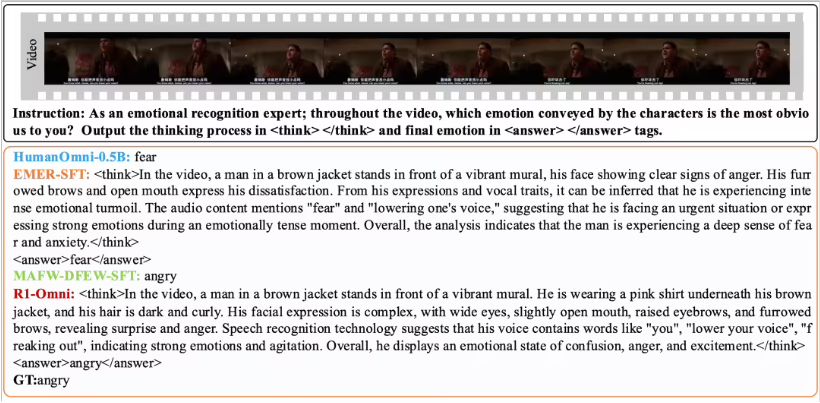

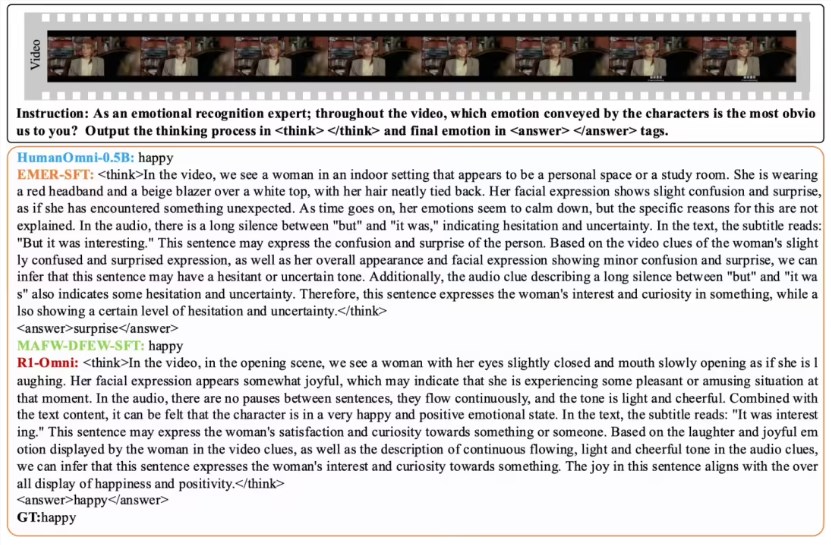

R1-OMNI ทำให้เกิดอิทธิพลของข้อมูลเสียงและวิดีโอที่ใช้งานง่ายมากขึ้นผ่านวิธี RLVR ตัวอย่างเช่นในภารกิจการจดจำอารมณ์แบบจำลองสามารถแสดงสัญญาณเสียงและวิดีโอที่มีบทบาทสำคัญในการตัดสินทางอารมณ์อย่างชัดเจน ความโปร่งใสนี้ไม่เพียง แต่ปรับปรุงความน่าเชื่อถือของแบบจำลองเท่านั้น แต่ยังช่วยให้นักวิจัยและนักพัฒนามีความเข้าใจที่ดีขึ้น

ในแง่ของการตรวจสอบประสิทธิภาพทีมห้องปฏิบัติการ Tongyi ได้ทำการทดลองเปรียบเทียบเกี่ยวกับ R1-OMNI กับแบบจำลอง Humanomni-0.5B ดั้งเดิม ผลการวิจัยพบว่าประสิทธิภาพของ R1-OMNI ในชุดข้อมูล DFEW และ MAFW ได้รับการปรับปรุงอย่างมีนัยสำคัญโดยมีการเพิ่มขึ้นโดยเฉลี่ยมากกว่า 35% นอกจากนี้เมื่อเปรียบเทียบกับโมเดลการปรับแต่งแบบดั้งเดิม (SFT) แบบดั้งเดิม R1-OMNI ยังดีขึ้นกว่า 10% ในการเรียนรู้ที่ไม่ได้รับการดูแล (UAR) R1-OMNI แสดงให้เห็นถึงความสามารถในการวางนัยทั่วไปที่ยอดเยี่ยมในชุดทดสอบแบบกระจายที่แตกต่างกัน (เช่น Ravdess) โดยมีทั้งการปรับปรุงสงครามและ UAR มากกว่า 13% ความสำเร็จเหล่านี้ไม่เพียง แต่พิสูจน์ข้อดีของ RLVR ในการปรับปรุงความสามารถในการใช้เหตุผล แต่ยังให้แนวคิดและทิศทางใหม่สำหรับการวิจัยแบบจำลองหลายรูปแบบในอนาคต

โอเพ่นซอร์สของ R1-OMNI จะอำนวยความสะดวกให้กับนักวิจัยและนักพัฒนามากขึ้นและเราหวังว่าจะได้รุ่นนี้นำนวัตกรรมและความก้าวหน้าในแอพพลิเคชั่นในอนาคต