人工知能の分野で、Alibaba Tongyi Laboratory Teamは最近、最新のマルチモーダルモデルであるR1 -Omniのオープンソースを発表しました。このモデルは、補強学習と検証済みの報酬(RLVR)アプローチを組み合わせて、オーディオ情報とビデオ情報の処理において優れた能力を示しています。 R1-OMNIのハイライトはその透明性であり、意思決定プロセス、特に感情認識などのタスクにおけるさまざまなモダリティの役割を理解することができます。

DeepSeek R1の発売により、大規模なモデルでの補強学習の応用の可能性が継続的に調査されています。 RLVRメソッドは、新しい最適化のアイデアをマルチモーダルタスクにもたらし、幾何学的推論や視覚カウントなどの複雑なタスクを効果的に処理できます。現在の研究は画像とテキストの組み合わせに焦点を当てていますが、Tongyi研究所の最新の探索はこの分野を拡大し、RLVRとビデオフルモーダルモデルを組み合わせて、技術の幅広いアプリケーションの見通しを完全に実証しています。

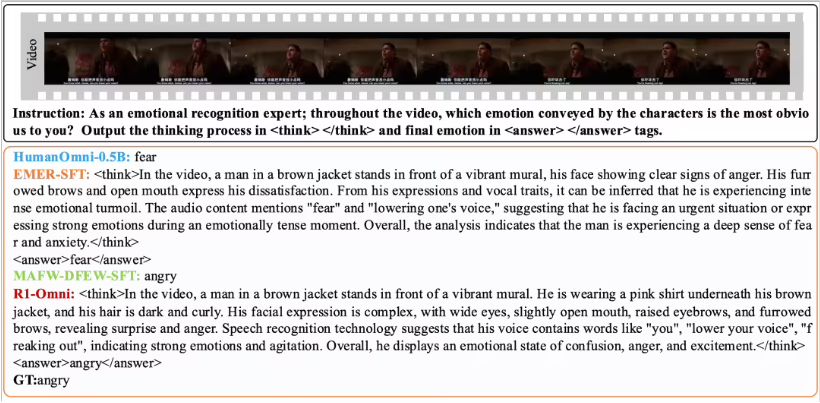

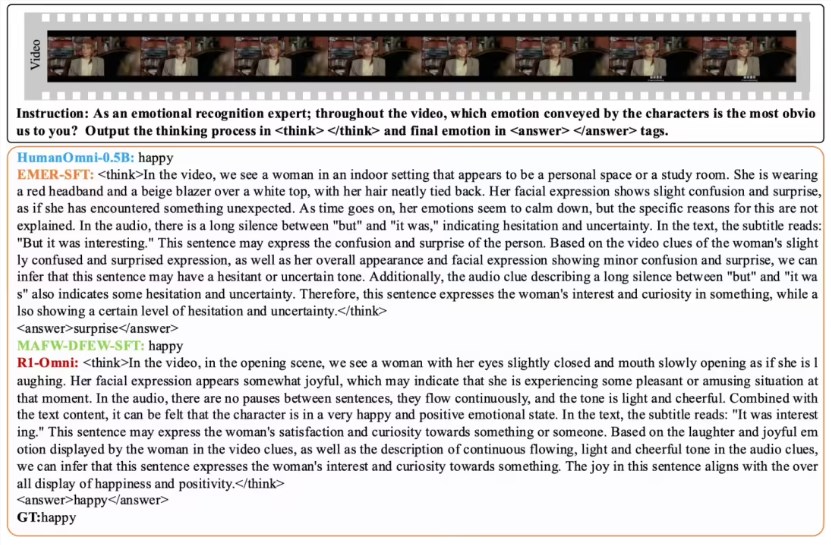

R1-OMNIは、RLVRメソッドを通じて、オーディオ情報とビデオ情報の影響をより直感的にします。たとえば、感情認識タスクでは、モデルはどのオーディオとビデオ信号が感情的判断に重要な役割を果たすかを明確に示すことができます。この透明性は、モデルの信頼性を向上させるだけでなく、研究者と開発者により良い洞察を提供します。

パフォーマンスの検証に関しては、Tongyi研究所チームは、元のCynomni-0.5BモデルとR1-OMNIの比較実験を実施しました。結果は、DFEWデータセットとMAFWデータセットの両方でのR1-OMNIのパフォーマンスが大幅に改善され、平均35%以上増加していることを示しています。さらに、従来の監視されている微調整(SFT)モデルと比較して、R1-OMNIは、監視されていない学習(UAR)で10%以上改善します。 R1-OMNIは、さまざまな分散テストセット(Ravdessなど)で優れた一般化機能を実証し、戦争とUARの両方の改善は13%以上です。これらの成果は、推論能力の向上におけるRLVRの利点を証明するだけでなく、将来のマルチモーダルモデル研究の新しいアイデアと方向性を提供します。

R1-OMNIのオープンソースは、より多くの研究者と開発者を促進し、このモデルが将来のアプリケーションでより多くの革新とブレークスルーをもたらすことを楽しみにしています。