No campo da inteligência artificial, a equipe de laboratório do Alibaba Tongyi anunciou recentemente o código aberto de seu mais recente modelo multimodal - R1 -omni. Este modelo combina o aprendizado de reforço com uma abordagem de recompensa validada (RLVR), demonstrando habilidades excelentes no processamento de informações de áudio e vídeo. O destaque do R1-omni é sua transparência, permitindo-nos entender o papel de várias modalidades no processo de tomada de decisão, especialmente em tarefas como o reconhecimento de emoções.

Com o lançamento do Deepseek R1, o potencial de aplicação do aprendizado de reforço em grandes modelos foi explorado continuamente. O método RLVR traz novas idéias de otimização para tarefas multimodais, que podem lidar efetivamente a tarefas complexas, como inferência geométrica e contagem visual. Embora a pesquisa atual se concentre na combinação de imagens e texto, a mais recente exploração do laboratório de Tongyi expandiu esse campo, combinando o RLVR com o modelo de vídeo em vídeo, demonstrando totalmente as amplas perspectivas de tecnologia de tecnologia.

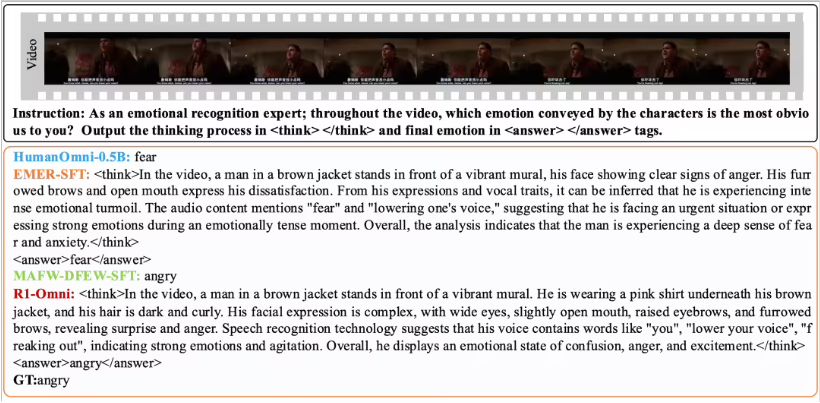

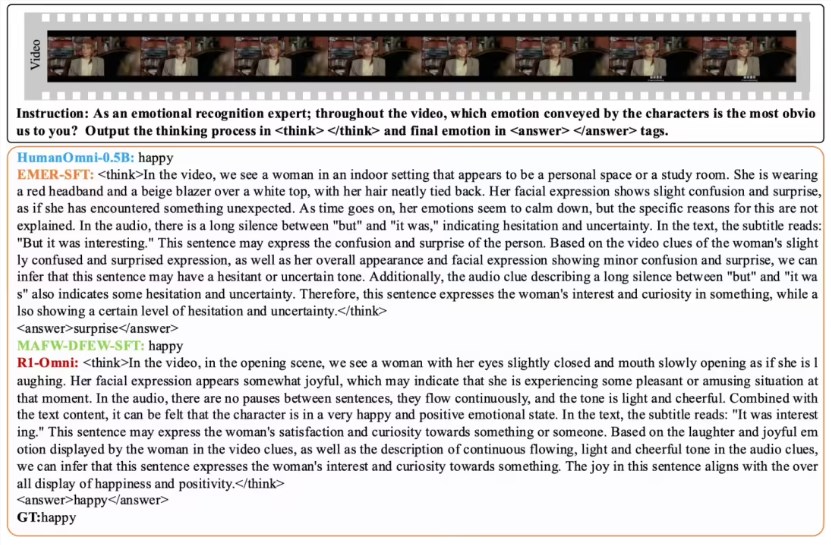

O R1-OMNI torna a influência das informações de áudio e vídeo mais intuitivas através do método RLVR. Por exemplo, na tarefa de reconhecimento de emoções, o modelo pode mostrar claramente quais sinais de áudio e vídeo desempenham um papel fundamental no julgamento emocional. Essa transparência não apenas melhora a confiabilidade do modelo, mas também fornece a pesquisadores e desenvolvedores melhores insights.

Em termos de verificação de desempenho, a equipe de laboratório de Tongyi conduziu um experimento comparativo em R1-omni com o modelo Humanomni-0.5b original. Os resultados mostram que o desempenho do R1-OMNI nos conjuntos de dados DFEW e MAFW melhorou significativamente, com um aumento médio de mais de 35%. Além disso, em comparação com o modelo tradicional de ajuste fino supervisionado (SFT), o R1-OMNI também melhora em mais de 10% na aprendizagem não supervisionada (UAR). O R1-OMNI demonstra excelentes capacidades de generalização em diferentes conjuntos de testes distribuídos (como Ravdess), com melhorias de guerra e UAR de mais de 13%. Essas realizações não apenas provam as vantagens do RLVR na melhoria dos recursos de raciocínio, mas também fornecem novas idéias e instruções para futuras pesquisas multimodais.

O código aberto do R1-OMNI facilitará mais pesquisadores e desenvolvedores, e esperamos esse modelo trazer mais inovações e avanços em aplicativos futuros.