في مجال الذكاء الاصطناعي ، أعلن فريق مختبر Alibaba Tongyi مؤخرًا عن المصدر المفتوح لأحدث طرازه متعدد الوسائط - R1 -OMNI. يجمع هذا النموذج بين التعلم التعزيز مع نهج المكافآت (RLVR) التحقق من صحة ، مما يدل على القدرات المعلقة في معالجة معلومات الصوت والفيديو. إن تسليط الضوء على R1-OMNI هو شفافيةها ، مما يسمح لنا بفهم دور الطرائق المختلفة في عملية صنع القرار ، وخاصة في مهام مثل التعرف على العاطفة.

مع إطلاق Deepseek R1 ، تم استكشاف إمكانات تطبيق التعلم التعزيز في نماذج كبيرة بشكل مستمر. تجلب طريقة RLVR أفكار تحسين جديدة إلى مهام متعددة الوسائط ، والتي يمكن أن تتعامل بشكل فعال مع المهام المعقدة مثل الاستدلال الهندسي والعد البصري. على الرغم من أن البحث الحالي يركز على مزيج من الصور والنص ، إلا أن أحدث استكشاف لمختبر Tongyi قد وسع هذا المجال ، حيث يجمع بين RLVR مع نموذج الفيديو الكامل للفيديو ، مما يدل بالكامل على آفاق التطبيق الواسعة للتكنولوجيا.

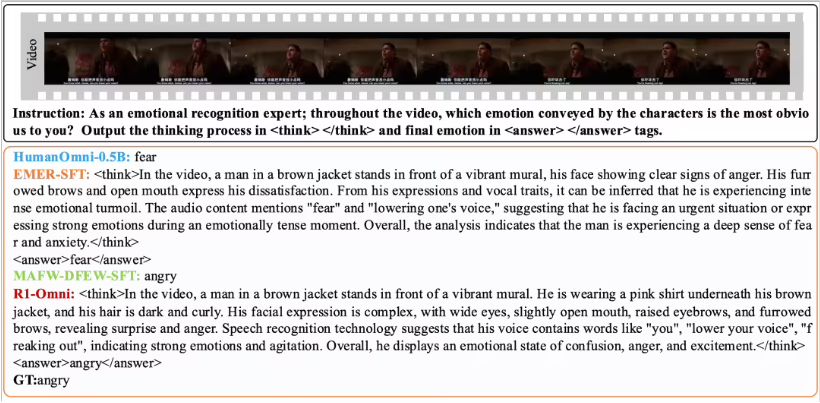

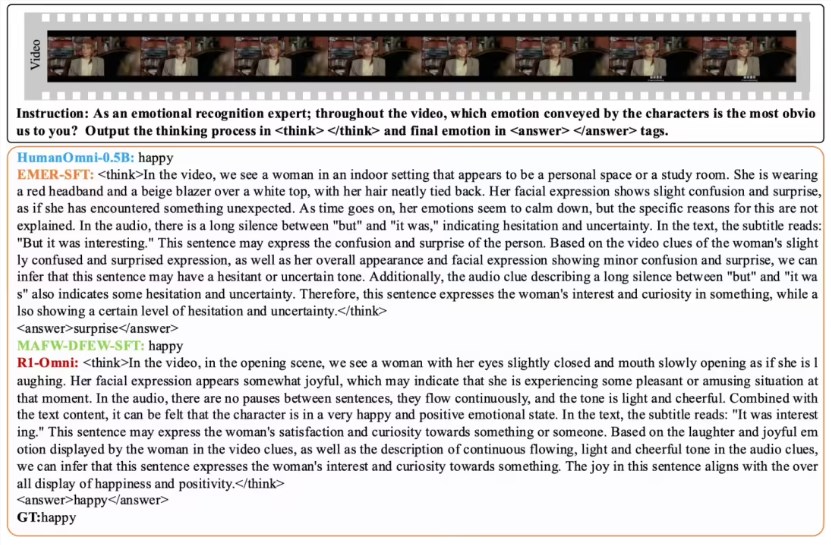

R1-OMNI يجعل تأثير معلومات الصوت والفيديو أكثر سهولة من خلال طريقة RLVR. على سبيل المثال ، في مهمة التعرف على العاطفة ، يمكن للنموذج أن يعرض بوضوح الإشارات الصوتية والفيديو التي تلعب دورًا رئيسيًا في الحكم العاطفي. لا تعمل هذه الشفافية على تحسين موثوقية النموذج فحسب ، بل توفر أيضًا للباحثين والمطورين رؤى أفضل.

فيما يتعلق بالتحقق من الأداء ، أجرى فريق مختبر Tongyi تجربة مقارنة على R1-OMNI مع نموذج Humanomni-0.5b الأصلي. أظهرت النتائج أن أداء R1-OMNI على كل من مجموعات بيانات DFEW و MAFW قد تحسن بشكل كبير ، بزيادة متوسط تزيد عن 35 ٪. بالإضافة إلى ذلك ، مقارنة بنموذج الضبط التقليدي الخاضع للإشراف (SFT) ، يتحسن R1-OMNI أيضًا بأكثر من 10 ٪ في التعلم غير الخاضع للإشراف (UAR). يوضح R1-OMNI قدرات تعميم ممتازة على مجموعات الاختبارات الموزعة المختلفة (مثل Ravdess) ، مع تحسينات الحرب و UAR بأكثر من 13 ٪. لا تثبت هذه الإنجازات فقط مزايا RLVR في تحسين قدرات التفكير ، ولكن أيضًا توفر أفكارًا واتجاهات جديدة للبحوث النموذجية متعددة الوسائط المستقبلية.

سيسهل المصدر المفتوح لـ R1-OMNI المزيد من الباحثين والمطورين ، ونتطلع إلى هذا النموذج الذي يجلب المزيد من الابتكارات والخرافات في التطبيقات المستقبلية.