Auf dem Gebiet der künstlichen Intelligenz kündigte das Alibaba Tongyi Laboratory Team kürzlich die Open Source seines neuesten multimodalen Modells - R1 -OMNI an. Dieses Modell kombiniert Verstärkungslernen mit einem RLVR -Ansatz (Validated Reward) und zeigt herausragende Fähigkeiten bei der Verarbeitung von Audio- und Videoinformationen. Der Höhepunkt von r1-omni ist seine Transparenz, die es uns ermöglicht, die Rolle verschiedener Modalitäten im Entscheidungsprozess zu verstehen, insbesondere bei Aufgaben wie der Emotionserkennung.

Mit der Einführung von Deepseek R1 wurde das Anwendungspotential des Verstärkungslernens in großen Modellen kontinuierlich untersucht. Die RLVR -Methode bringt neue Optimierungsideen für multimodale Aufgaben mit, die komplexe Aufgaben wie geometrische Inferenz und visuelle Zählung effektiv umgehen können. Obwohl sich die aktuelle Forschung auf die Kombination von Bildern und Text konzentriert, hat die neueste Erkundung des Tongyi-Labors dieses Gebiet erweitert und RLVR mit dem vollen Model mit Video-Vollmodal kombiniert und die weiten Anwendungsaussichten von Technologie vollständig demonstriert.

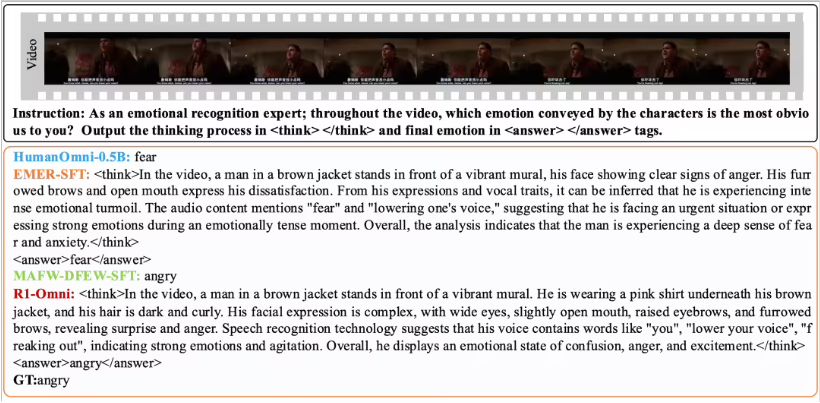

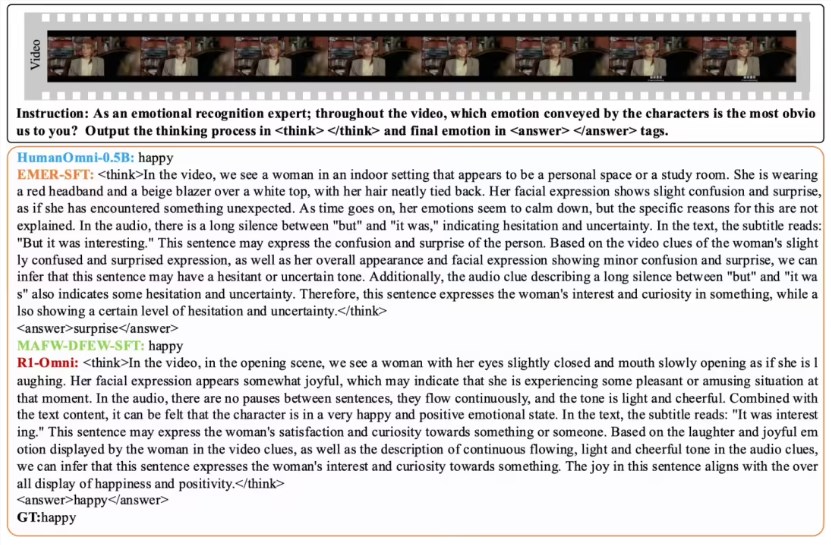

R1-OMNI macht den Einfluss von Audio- und Videoinformationen durch die RLVR-Methode intuitiver. Zum Beispiel kann das Modell bei der Emotionserkennungsaufgabe deutlich zeigen, welche Audio- und Videosignale eine Schlüsselrolle im emotionalen Urteilsvermögen spielen. Diese Transparenz verbessert nicht nur die Zuverlässigkeit des Modells, sondern bietet auch Forschern und Entwicklern bessere Erkenntnisse.

In Bezug auf die Leistungsüberprüfung führte das Laborteam von Tontyi ein vergleichendes Experiment zu R1-OMNI mit dem ursprünglichen Humanomni-0,5b-Modell durch. Die Ergebnisse zeigen, dass die Leistung von R1-OMNI sowohl für DFEW- als auch für MAFW-Datensätze mit einem durchschnittlichen Anstieg von mehr als 35%erheblich verbessert wurde. Darüber hinaus verbessert sich R1-OMNI im Vergleich zum traditionellen Modell für beaufsichtigte Feinabstimmungen (SFT) -Modell (UAR) auch um mehr als 10%. R1-OMNI zeigt hervorragende Generalisierungsfähigkeiten bei verschiedenen verteilten Testsets (wie Ravdess), sowohl bei Kriegs- als auch bei UAR-Verbesserungen von mehr als 13%. Diese Erfolge beweisen nicht nur die Vorteile von RLVR bei der Verbesserung der Argumentationsfähigkeiten, sondern bieten auch neue Ideen und Anweisungen für zukünftige multimodale Modellforschung.

Die Open Source von R1-OMNI wird mehr Forscher und Entwicklern ermöglichen, und wir freuen uns darauf, dass dieses Modell mehr Innovationen und Durchbrüche in zukünftigen Anwendungen bringt.