인공 지능 분야에서 Alibaba Tongyi Laboratory 팀은 최근 최신 멀티 모드 모델 인 R1 -Omni의 오픈 소스를 발표했습니다. 이 모델은 강화 학습과 검증 된 보상 (RLVR) 접근 방식을 결합하여 오디오 및 비디오 정보 처리의 뛰어난 능력을 보여줍니다. R1-Omni의 하이라이트는 투명성으로, 특히 감정 인식과 같은 작업에서 의사 결정 과정에서 다양한 양식의 역할을 이해할 수 있습니다.

DeepSeek R1이 출시되면서 큰 모델에서 강화 학습의 응용 잠재력이 지속적으로 탐구되었습니다. RLVR 방법은 다중 모드 작업에 새로운 최적화 아이디어를 제공하며, 이는 기하학적 추론 및 시각적 계수와 같은 복잡한 작업을 효과적으로 처리 할 수 있습니다. 현재의 연구는 이미지와 텍스트의 조합에 중점을두고 있지만 Tongyi Laboratory의 최신 탐색은 RLVR과 비디오 전체 모달 모델과 결합하여 기술의 광범위한 응용 전망을 완전히 보여주었습니다.

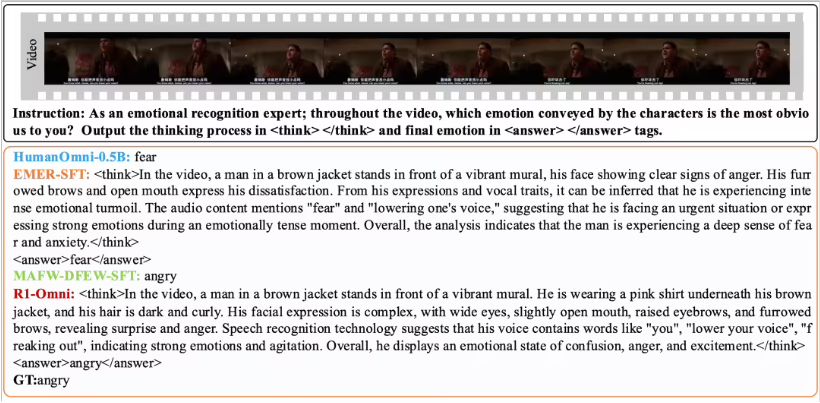

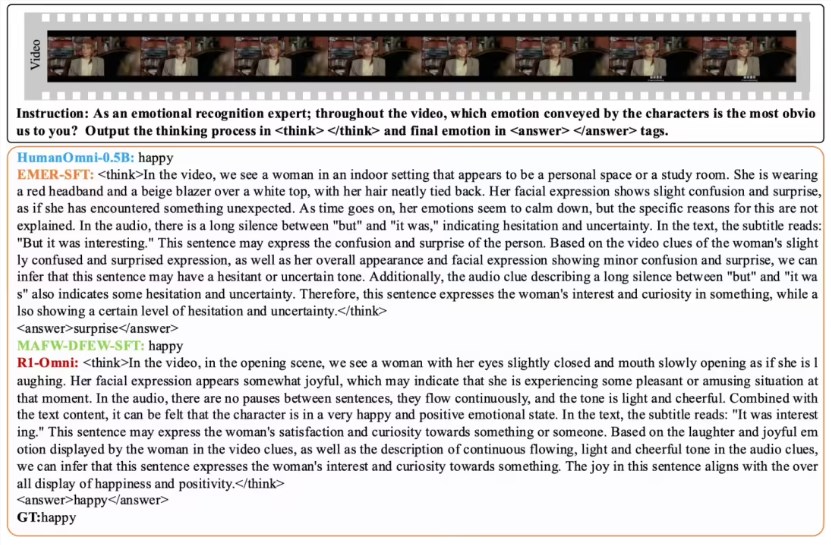

R1-Omni는 RLVR 방법을 통해 오디오 및 비디오 정보의 영향을보다 직관적으로 만듭니다. 예를 들어, 감정 인식 작업 에서이 모델은 어떤 오디오 및 비디오 신호가 정서적 판단에서 중요한 역할을하는지 명확하게 보여줄 수 있습니다. 이러한 투명성은 모델의 신뢰성을 향상시킬뿐만 아니라 연구원과 개발자에게 더 나은 통찰력을 제공합니다.

성능 검증 측면에서 Tongyi Laboratory 팀은 원래 Humanomni-0.5b 모델과 함께 R1-Omni에 대한 비교 실험을 수행했습니다. 결과는 DFEW 및 MAFW 데이터 세트 모두에서 R1-OMNI의 성능이 상당히 개선되었으며 평균 35%이상의 증가가 크게 향상되었음을 보여줍니다. 또한, 전통적인 감독 된 미세 조정 (SFT) 모델과 비교하여 R1-OMNI는 감독되지 않은 학습 (UAR)에서 10% 이상 향상됩니다. R1-OMNI는 전쟁 및 UAR 개선이 13%이상인 다양한 분산 테스트 세트 (예 : Ravdess)에서 우수한 일반화 기능을 보여줍니다. 이러한 성과는 추론 능력을 향상시키는 데있어서 RLVR의 장점을 증명할뿐만 아니라 미래의 멀티 모달 모델 연구를위한 새로운 아이디어와 방향을 제공합니다.

R1-Omni의 오픈 소스는 더 많은 연구원과 개발자를 촉진 할 것이며,이 모델을 기대하면 향후 응용 프로그램에서 더 많은 혁신과 혁신을 가져 오기를 기대합니다.