En el campo de la inteligencia artificial, el equipo de laboratorio de Alibaba Tongyi anunció recientemente el código abierto de su último modelo multimodal: R1 -OMNI. Este modelo combina el aprendizaje de refuerzo con un enfoque de recompensa validada (RLVR), demostrando habilidades sobresalientes en el procesamiento de la información de audio y video. Lo más destacado de R1-AMNI es su transparencia, lo que nos permite comprender el papel de diversas modalidades en el proceso de toma de decisiones, especialmente en tareas como el reconocimiento de emociones.

Con el lanzamiento de Deepseek R1, se ha explorado continuamente el potencial de aplicación del aprendizaje de refuerzo en modelos grandes. El método RLVR aporta nuevas ideas de optimización a tareas multimodales, que pueden manejar efectivamente tareas complejas, como la inferencia geométrica y el conteo visual. Aunque la investigación actual se centra en la combinación de imágenes y texto, la última exploración del laboratorio Tongyi ha ampliado este campo, combinando RLVR con un modelo de video completo, demostrando completamente las amplias perspectivas de tecnología de aplicaciones.

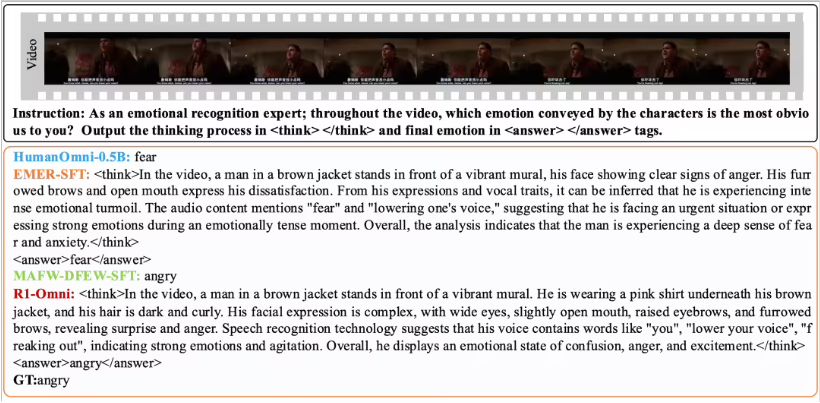

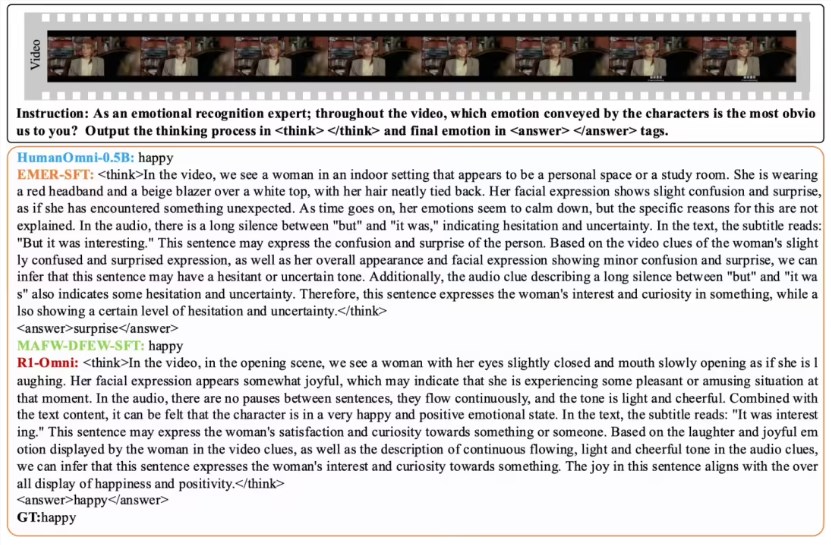

R1-OMNI hace que la influencia de la información de audio y video sea más intuitiva a través del método RLVR. Por ejemplo, en la tarea de reconocimiento de emociones, el modelo puede mostrar claramente qué señales de audio y video juegan un papel clave en el juicio emocional. Esta transparencia no solo mejora la confiabilidad del modelo, sino que también proporciona a los investigadores y desarrolladores mejores ideas.

En términos de verificación de rendimiento, el equipo de laboratorio Tongyi realizó un experimento comparativo en R1-OMNI con el modelo original HumanOmni-0.5B. Los resultados muestran que el rendimiento de R1-AMNI en los conjuntos de datos DFEW y MAFW ha mejorado significativamente, con un aumento promedio de más del 35%. Además, en comparación con el modelo tradicional de ajuste fino (SFT), R1-OMNI también mejora en más del 10% en el aprendizaje no supervisado (UAR). R1-AMNI demuestra excelentes capacidades de generalización en diferentes conjuntos de pruebas distribuidas (como Ravdess), con mejoras de guerra y UAR de más del 13%. Estos logros no solo prueban las ventajas de RLVR para mejorar las capacidades de razonamiento, sino que también proporcionan nuevas ideas y direcciones para futuras investigaciones de modelos multimodales.

El código abierto de R1-EMNI facilitará a más investigadores y desarrolladores, y esperamos que este modelo traiga más innovaciones y avances en futuras aplicaciones.