Di bidang kecerdasan buatan, tim Laboratorium Alibaba Tongyi baru -baru ini mengumumkan sumber terbuka model multimodal terbaru - R1 -OMNI. Model ini menggabungkan pembelajaran penguatan dengan pendekatan hadiah yang divalidasi (RLVR), menunjukkan kemampuan luar biasa dalam memproses informasi audio dan video. Sorotan R1-OMNI adalah transparansi, memungkinkan kita untuk memahami peran berbagai modalitas dalam proses pengambilan keputusan, terutama dalam tugas-tugas seperti pengenalan emosi.

Dengan peluncuran Deepseek R1, potensi aplikasi pembelajaran penguatan dalam model besar telah terus dieksplorasi. Metode RLVR membawa ide optimisasi baru ke tugas multimodal, yang secara efektif dapat menangani tugas -tugas kompleks seperti inferensi geometris dan penghitungan visual. Meskipun penelitian saat ini berfokus pada kombinasi gambar dan teks, eksplorasi terbaru dari Laboratorium Tongyi telah memperluas bidang ini, menggabungkan RLVR dengan model model penuh, sepenuhnya menunjukkan prospek aplikasi teknologi yang luas.

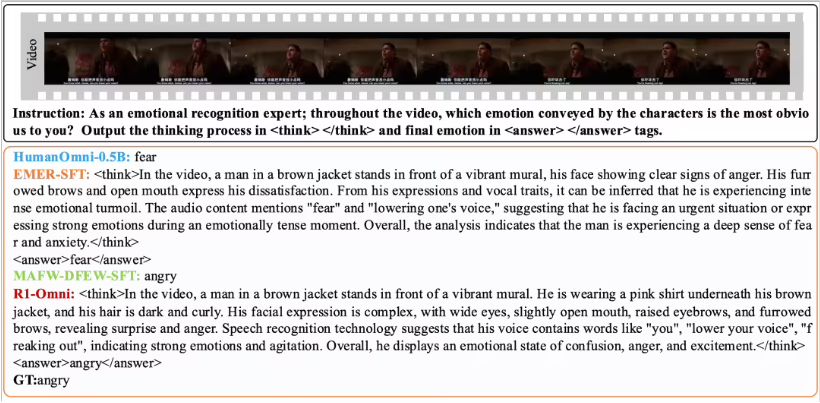

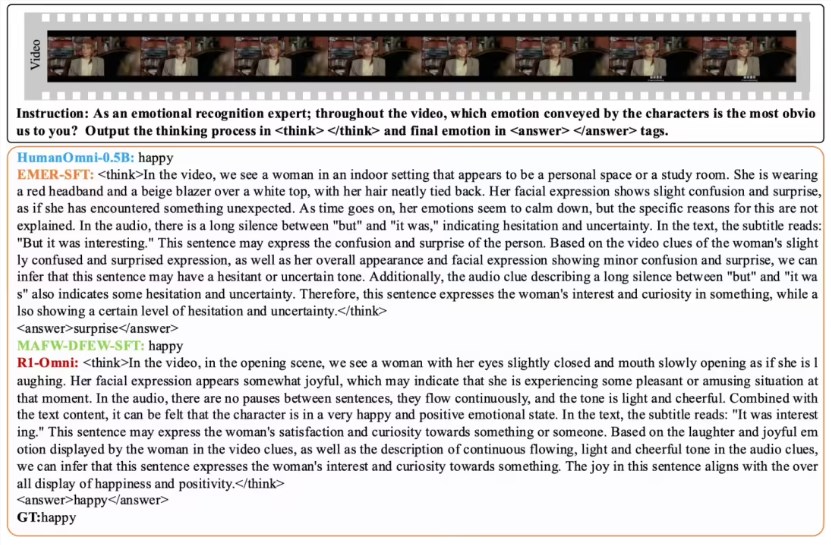

R1-OMNI membuat pengaruh informasi audio dan video lebih intuitif melalui metode RLVR. Misalnya, dalam tugas pengenalan emosi, model dapat dengan jelas menunjukkan sinyal audio dan video mana yang memainkan peran kunci dalam penilaian emosional. Transparansi ini tidak hanya meningkatkan keandalan model, tetapi juga memberi para peneliti dan pengembang wawasan yang lebih baik.

Dalam hal verifikasi kinerja, tim Laboratorium Tongyi melakukan percobaan komparatif pada R1-OMNI dengan model asli Humanomni-0.5b. Hasilnya menunjukkan bahwa kinerja R1-OMNI pada dataset DFEW dan MAFW telah meningkat secara signifikan, dengan peningkatan rata-rata lebih dari 35%. Selain itu, dibandingkan dengan model fine-tuning (SFT) yang diawasi tradisional, R1-OMNI juga meningkat lebih dari 10% dalam pembelajaran tanpa pengawasan (UAR). R1-OMNI menunjukkan kemampuan generalisasi yang sangat baik pada set uji terdistribusi yang berbeda (seperti RAVDESS), dengan perbaikan perang dan UAR lebih dari 13%. Prestasi ini tidak hanya membuktikan keunggulan RLVR dalam meningkatkan kemampuan penalaran, tetapi juga memberikan ide dan arahan baru untuk penelitian model multimodal di masa depan.

Sumber terbuka R1-OMNI akan memfasilitasi lebih banyak peneliti dan pengembang, dan kami menantikan model ini membawa lebih banyak inovasi dan terobosan dalam aplikasi masa depan.