В области искусственного интеллекта лабораторная команда Alibaba Tongyi недавно объявила об открытом исходном коде его новейшей мультимодальной модели - R1 -Omni. Эта модель сочетает в себе подход подкрепления с подтвержденным подходом вознаграждения (RLVR), демонстрируя выдающиеся способности при обработке аудио и видео информации. Основным моментом R1-omni является его прозрачность, позволяющая нам понять роль различных модальностей в процессе принятия решений, особенно в таких задачах, как распознавание эмоций.

С запуском DeepSeek R1 потенциал применения обучения подкреплению в крупных моделях постоянно изучался. Метод RLVR привносит новые идеи оптимизации в мультимодальные задачи, которые могут эффективно выполнять сложные задачи, такие как геометрический вывод и визуальный подсчет. Хотя текущее исследование фокусируется на сочетании изображений и текста, последнее исследование лаборатории Tongyi расширило эту область, объединив RLVR с видео полномодальной модели, полностью демонстрируя широкие перспективы применения технологии.

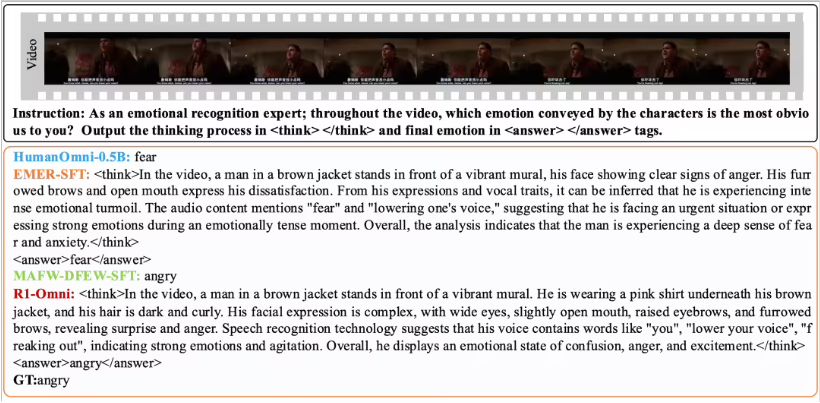

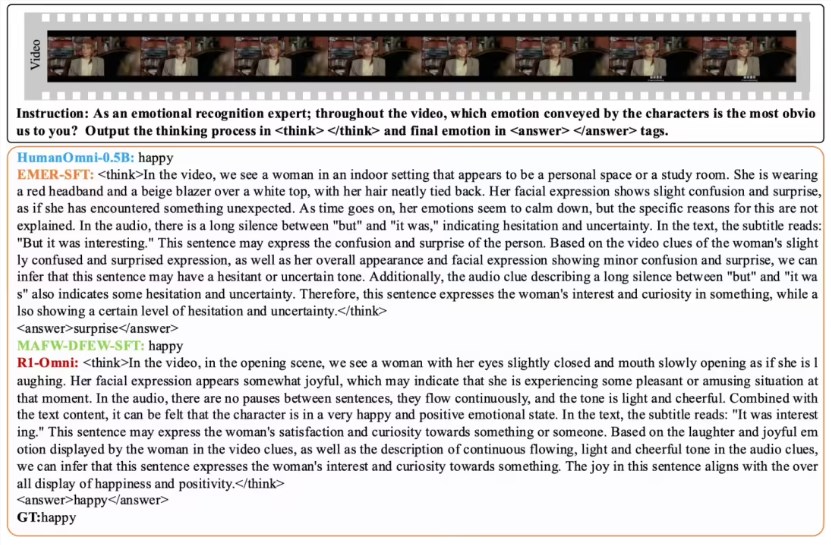

R1-Amni делает влияние аудио и видео информации более интуитивно понятным с помощью метода RLVR. Например, в задаче распознавания эмоций модель может четко показать, какие аудио и видеосигналы играют ключевую роль в эмоциональном суждении. Эта прозрачность не только повышает надежность модели, но и предоставляет исследователям и разработчикам лучшую информацию.

С точки зрения проверки производительности, лабораторная команда Тонги провела сравнительный эксперимент на R1-OMNI с оригинальной моделью Humanomni-0.5b. Результаты показывают, что производительность R1-OMNI как в наборах данных DFEW, так и на наборах данных DFEW и MAFW значительно улучшилась, со средним увеличением более чем на 35%. Кроме того, по сравнению с традиционной моделью с тонкой настройкой (SFT) R1-OMNI также улучшается более чем на 10% в неконтролируемом обучении (UAR). R1-OMNI демонстрирует превосходные возможности обобщения на различных распределенных тестовых наборах (таких как Ravdess), причем как военные, так и UAR улучшают более 13%. Эти достижения не только доказывают преимущества RLVR в улучшении возможностей рассуждений, но и предоставляют новые идеи и направления для будущих мультимодальных исследований модели.

Открытый источник R1-AMNI будет способствовать большему количеству исследователей и разработчиков, и мы с нетерпением ждем, чтобы эта модель принесла больше инноваций и прорывов в будущих приложениях.