การใช้งาน Pytorch ของการถ่ายโอนอารมณ์ข้ามลำโพงของ Bytedance ขึ้นอยู่กับการทำให้เป็นมาตรฐานของเลเยอร์สภาพลำโพงและการฝึกอบรมกึ่งผู้ดูแลในการพูดแบบข้อความเป็นคำพูด

ตัวอย่างเสียงมีให้ที่ /สาธิต

ชุดข้อมูล หมายถึงชื่อของชุดข้อมูลเช่น RAVDESS ในเอกสารต่อไปนี้

คุณสามารถติดตั้งการพึ่งพา Python ด้วย

pip3 install -r requirements.txt

นอกจากนี้ยังติดตั้ง Fairseq (เอกสารอย่างเป็นทางการ GitHub) เพื่อใช้ LConvBlock โปรดตรวจสอบที่นี่เพื่อแก้ไขปัญหาใด ๆ เกี่ยวกับการติดตั้ง โปรดทราบว่า Dockerfile มีไว้สำหรับผู้ใช้ Docker แต่คุณต้องติดตั้ง Fairseq ด้วยตนเอง

คุณต้องดาวน์โหลดโมเดลที่ผ่านการฝึกอบรมและวางไว้ใน output/ckpt/DATASET/

เพื่อแยกโทเค็นอารมณ์อ่อน ๆ ออกจากเสียงอ้างอิงให้เรียกใช้

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --speaker_id SPEAKER_ID --ref_audio REF_AUDIO_PATH --restore_step RESTORE_STEP --mode single --dataset DATASET

หรือเพื่อใช้โทเค็นอารมณ์ที่แข็งจากรหัสอารมณ์

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --speaker_id SPEAKER_ID --emotion_id EMOTION_ID --restore_step RESTORE_STEP --mode single --dataset DATASET

พจนานุกรมของลำโพงที่เรียนรู้สามารถพบได้ที่ preprocessed_data/DATASET/speakers.json และคำพูดที่สร้างขึ้นจะถูกนำไปใช้ใน output/result/

รองรับการอนุมานแบบแบทช์ด้วยลอง

python3 synthesize.py --source preprocessed_data/DATASET/val.txt --restore_step RESTORE_STEP --mode batch --dataset DATASET

เพื่อสังเคราะห์คำพูดทั้งหมดใน preprocessed_data/DATASET/val.txt โปรดทราบว่ามีเพียงโทเค็นอารมณ์ที่แข็งจากรหัสอารมณ์ที่กำหนดในโหมดนี้

ชุดข้อมูลที่รองรับคือ

ภาษาและชุดข้อมูลของคุณเอง สามารถปรับได้ตามที่นี่

สำหรับ TTS หลายลำโพงที่ มีลำโพง Embedder ดาวน์โหลด Rescnn Softmax+Triplet Pretrained Model ของ Deepspeaker ของ Philipperemy สำหรับการฝังลำโพงและค้นหาใน ./deepspeaker/pretrained_models/ deepspeaker/pretrained_models/

วิ่ง

python3 prepare_align.py --dataset DATASET

สำหรับการเตรียมการบางอย่าง

สำหรับการจัดตำแหน่งที่ถูกบังคับมอนทรีออลบังคับให้ผู้จัดตำแหน่ง (MFA) ใช้เพื่อให้ได้การจัดตำแหน่งระหว่างคำพูดและลำดับฟอนิม การจัดตำแหน่งที่สกัดไว้ล่วงหน้าสำหรับชุดข้อมูลมีให้ที่นี่ คุณต้องคลายซิปไฟล์ใน preprocessed_data/DATASET/TextGrid/ อีกวิธีหนึ่งคุณสามารถเรียกใช้การจัดตำแหน่งด้วยตัวเอง

หลังจากนั้นเรียกใช้สคริปต์การประมวลผลล่วงหน้าโดย

python3 preprocess.py --dataset DATASET

ฝึกอบรมแบบจำลองของคุณด้วย

python3 train.py --dataset DATASET

ตัวเลือกที่มีประโยชน์:

--use_amp อาร์กิวเมนต์ไปยังคำสั่งด้านบนCUDA_VISIBLE_DEVICES=<GPU_IDs> ที่จุดเริ่มต้นของคำสั่งด้านบนใช้

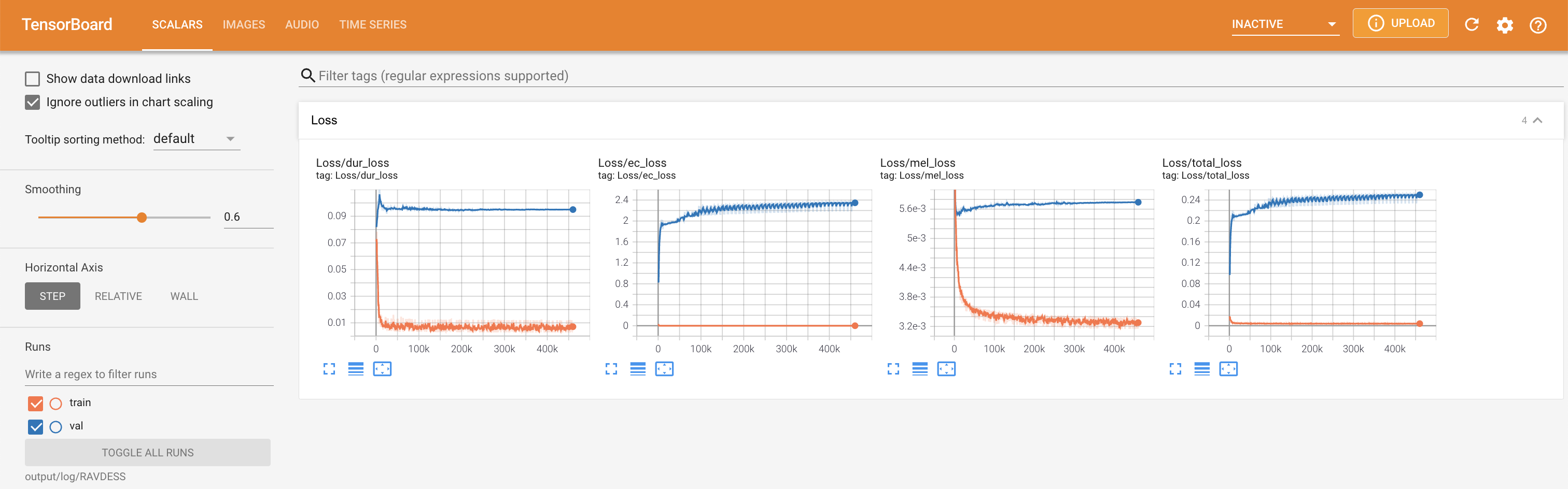

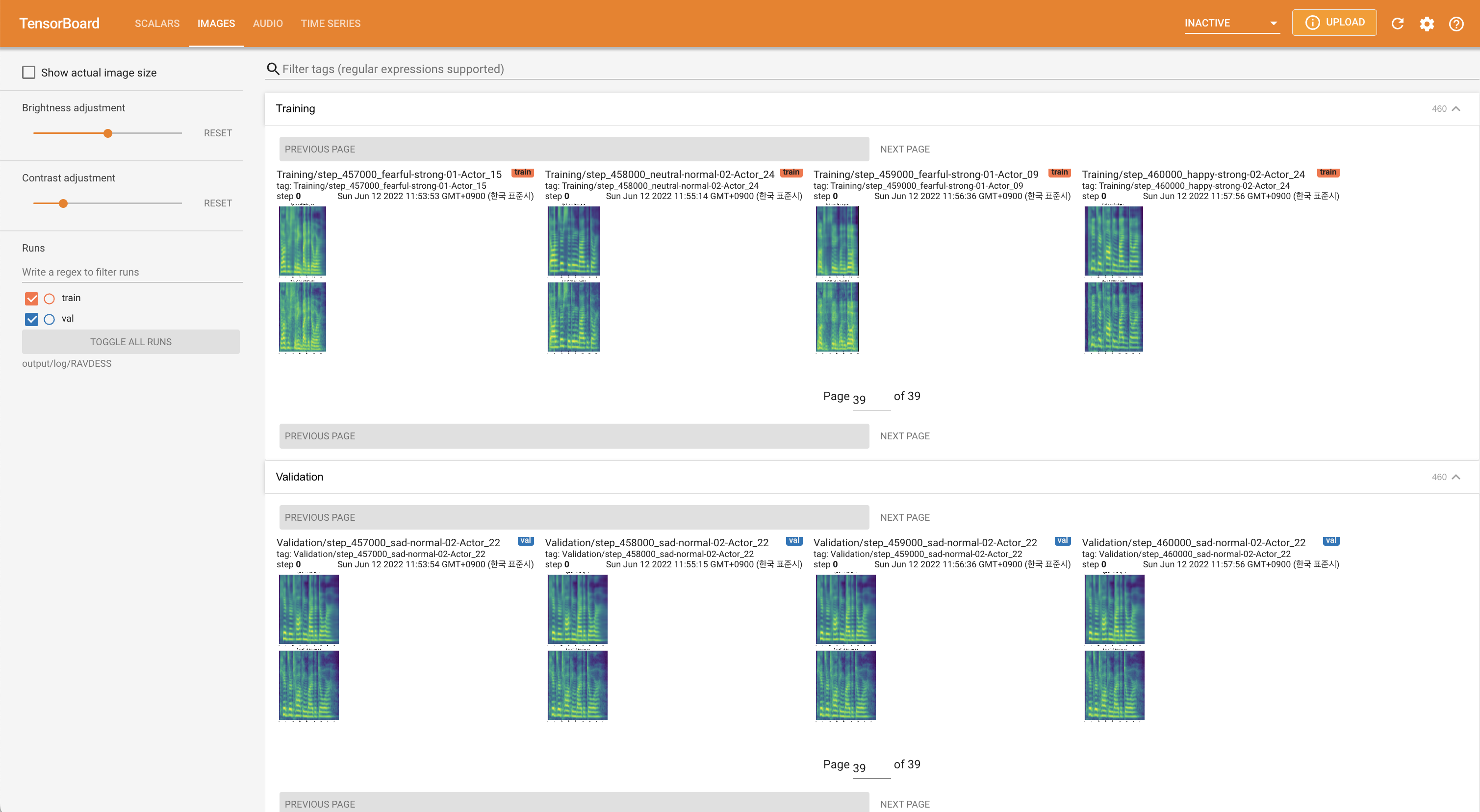

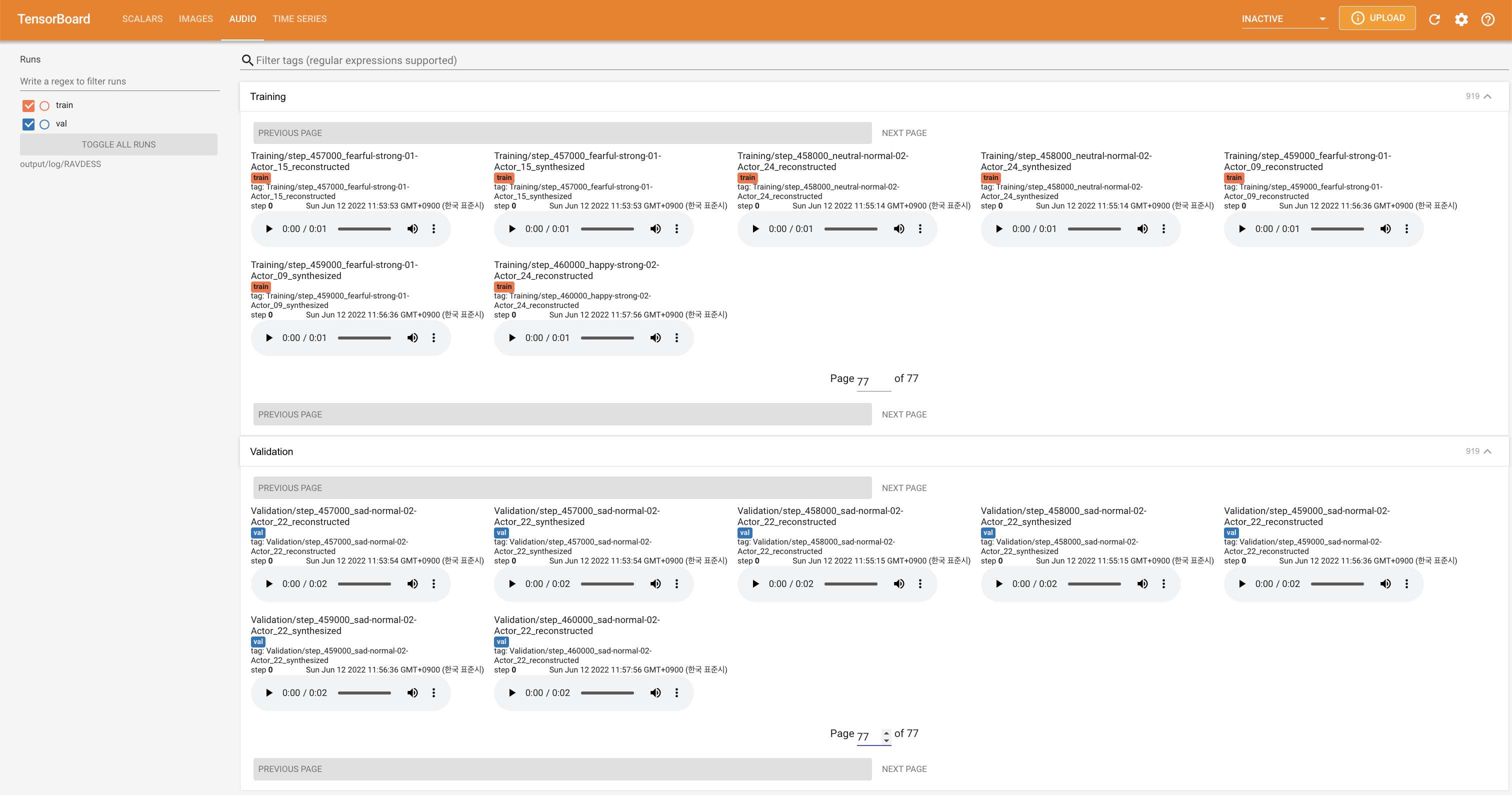

tensorboard --logdir output/log

เพื่อให้บริการ Tensorboard บนบ้านของคุณ เส้นโค้งการสูญเสีย mel-spectrograms สังเคราะห์และเสียงจะแสดง

'none' และ 'DeepSpeaker' )

โปรดอ้างอิงพื้นที่เก็บข้อมูลนี้โดย "อ้างอิงที่เก็บนี้" ของส่วน เกี่ยวกับ (ขวาบนของหน้าหลัก)