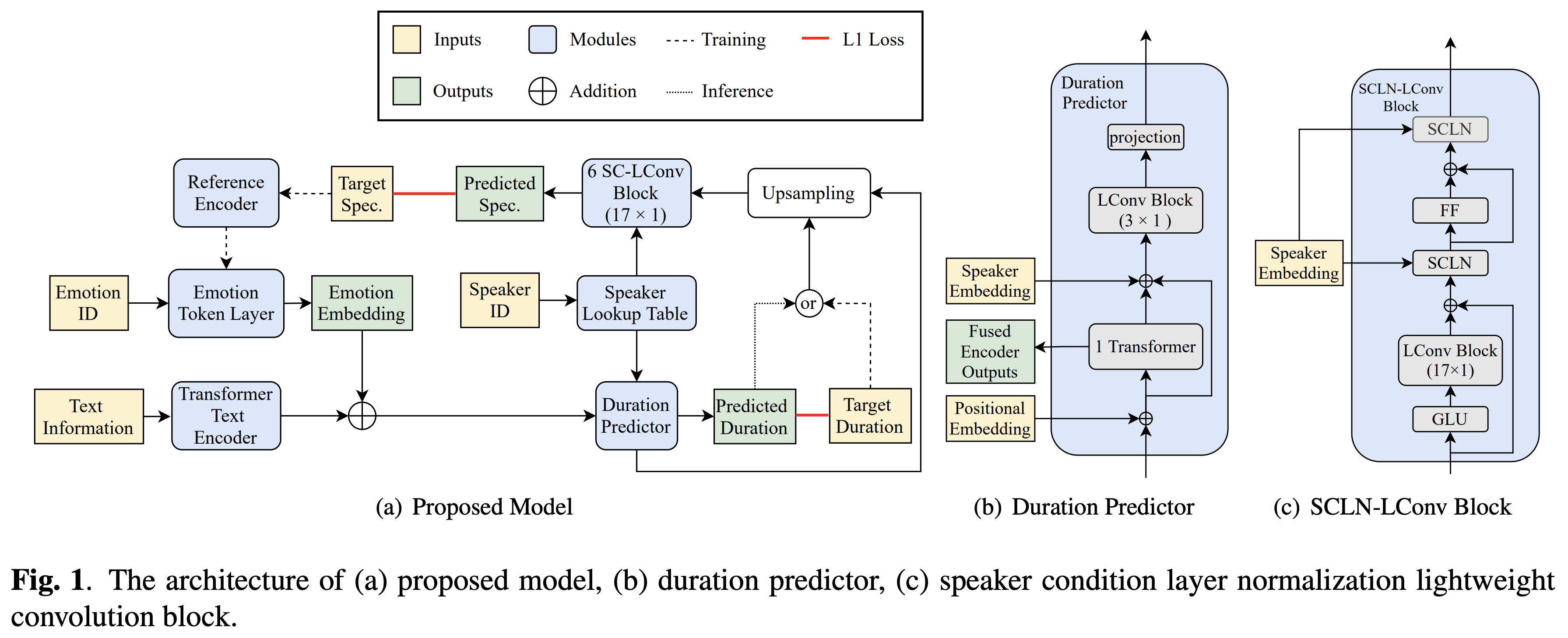

Pytorch-Implementierung des Cross-Sprecher-Emotionentransfs von Bytedance basierend auf der Normalisierung der Lautsprecherbedingung und einer halbübergreifenden Schulung in Text-zu-Sprache.

Audio -Samples sind bei /Demo erhältlich.

Der Datensatz bezieht sich auf die Namen von Datensätzen wie RAVDESS in den folgenden Dokumenten.

Sie können die Python -Abhängigkeiten mit installieren

pip3 install -r requirements.txt

Installieren Sie außerdem Fairseq (offizielles Dokument, Github), um LConvBlock zu verwenden. Bitte überprüfen Sie hier, um ein Problem bei der Installation zu beheben. Beachten Sie, dass Dockerfile für Docker -Benutzer bereitgestellt wird, Sie jedoch fairseq manuell installieren müssen.

Sie müssen die vorbereiteten Modelle herunterladen und in output/ckpt/DATASET/ einfügen.

Um weiche Emotionstoken aus einem Referenz -Audio zu extrahieren, laufen Sie

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --speaker_id SPEAKER_ID --ref_audio REF_AUDIO_PATH --restore_step RESTORE_STEP --mode single --dataset DATASET

Oder um harte Emotionstoken aus einer Emotions -ID zu verwenden

python3 synthesize.py --text "YOUR_DESIRED_TEXT" --speaker_id SPEAKER_ID --emotion_id EMOTION_ID --restore_step RESTORE_STEP --mode single --dataset DATASET

Das Wörterbuch der gelehrten Sprecher finden Sie unter preprocessed_data/DATASET/speakers.json , und die generierten Äußerungen werden in output/result/ .

Batch -Inferenz wird ebenfalls unterstützt, versuchen Sie es

python3 synthesize.py --source preprocessed_data/DATASET/val.txt --restore_step RESTORE_STEP --mode batch --dataset DATASET

So synthetisieren Sie alle Äußerungen in preprocessed_data/DATASET/val.txt . Bitte beachten Sie, dass nur die Hard -Emotion -Token einer bestimmten Emotions -ID in diesem Modus unterstützt werden.

Die unterstützten Datensätze sind

Ihre eigene Sprache und Ihr eigener Datensatz können hier gefolgt werden.

Download für ein Multi-Sprecher-TTS mit einem externen Lautsprecher-Einbettder Rescnn Softmax+Triplet Pretrainierte Modell von Philipperemy's Deepspeaker für den Lautsprecher-Einbettung und lokalisiert es in ./deepspeaker/pretrained_models/ .

Laufen

python3 prepare_align.py --dataset DATASET

Für einige Vorbereitungen.

Für die erzwungene Ausrichtung wird Montreal erzwungene Aligner (MFA) verwendet, um die Ausrichtungen zwischen den Äußerungen und den Phonemsequenzen zu erhalten. Vorextrahierte Ausrichtungen für die Datensätze werden hier bereitgestellt. Sie müssen die Dateien in preprocessed_data/DATASET/TextGrid/ entpacken. Alternativ können Sie den Aligner selbst ausführen.

Führen Sie danach das Vorverarbeitungskript durch

python3 preprocess.py --dataset DATASET

Trainieren Sie Ihr Modell mit

python3 train.py --dataset DATASET

Nützliche Optionen:

--use_amp Argument zum obigen Befehl.CUDA_VISIBLE_DEVICES=<GPU_IDs> an.Verwenden

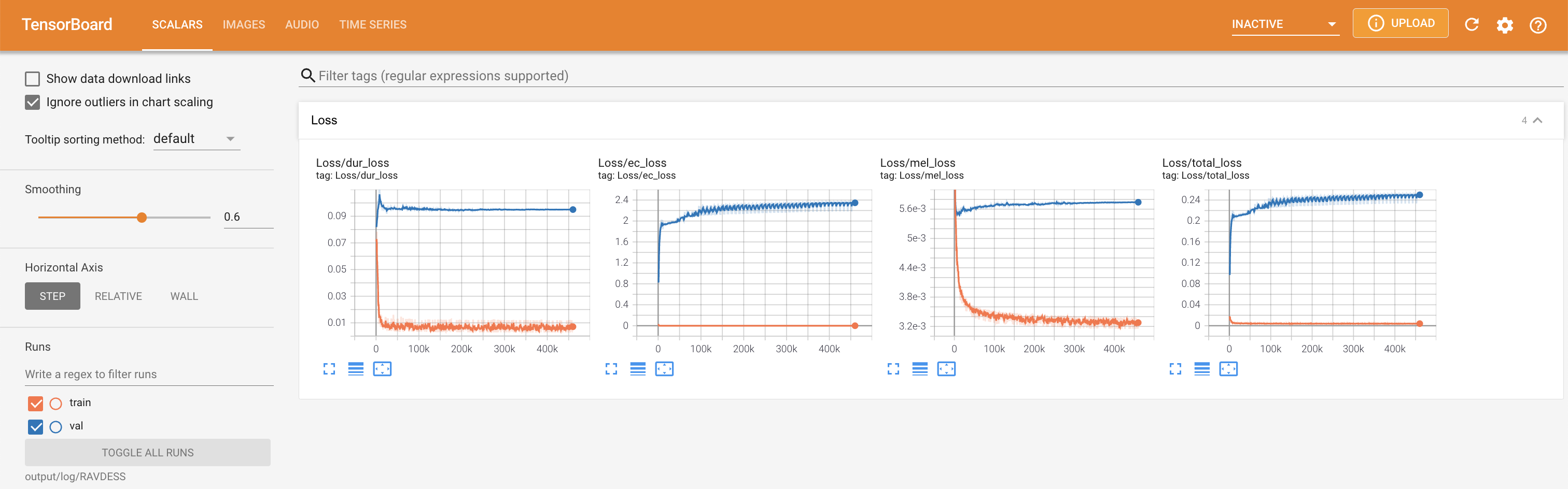

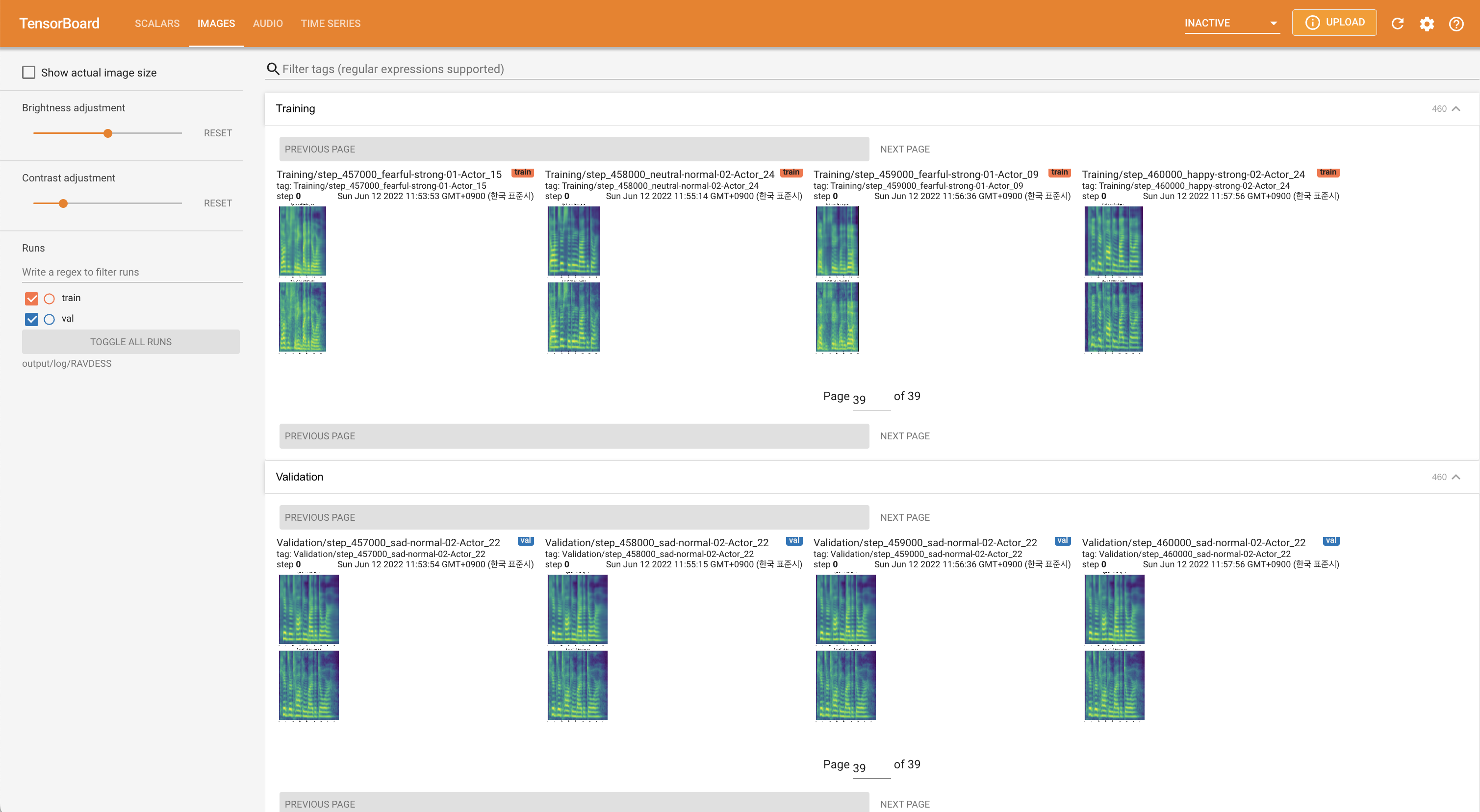

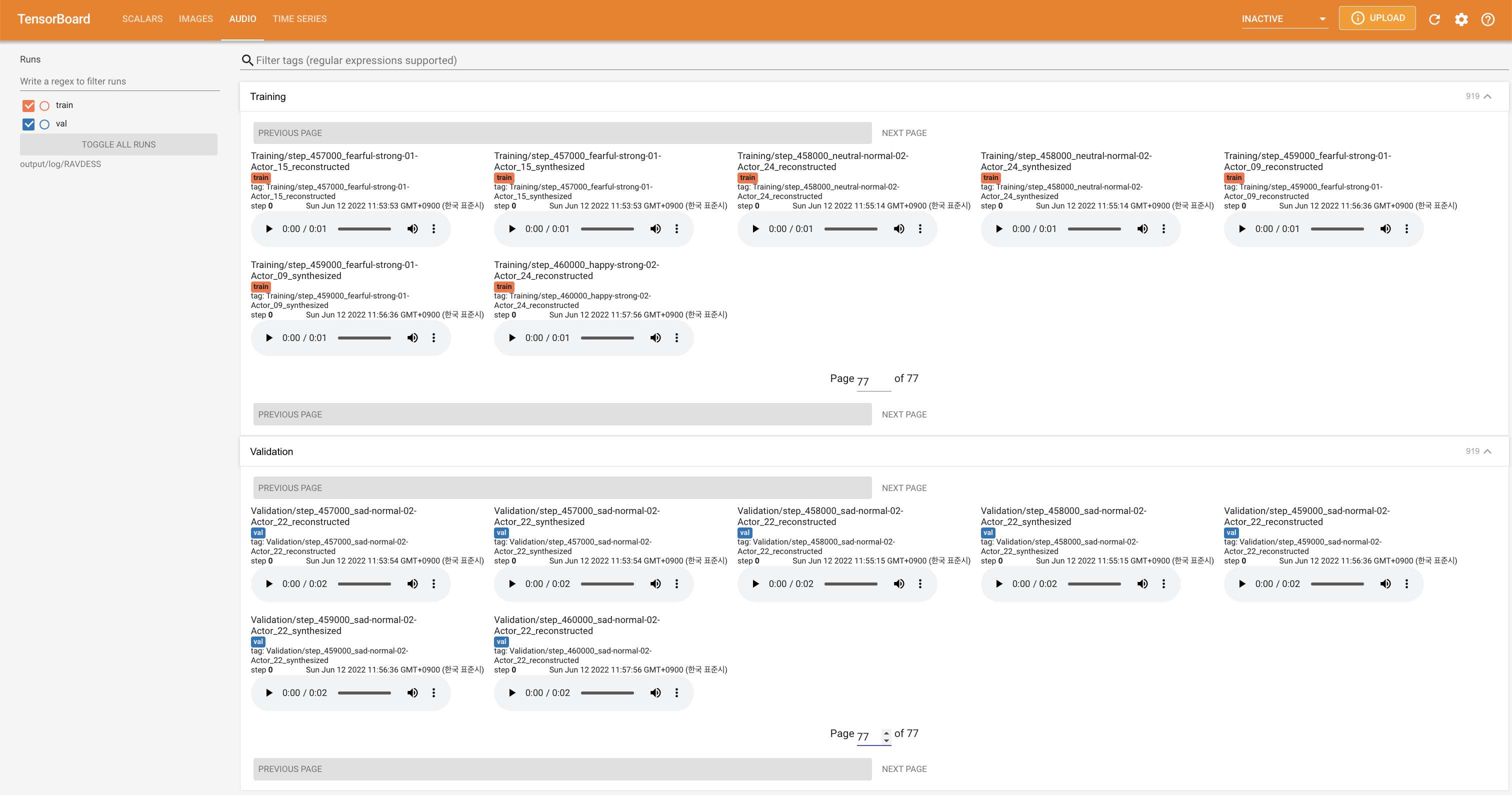

tensorboard --logdir output/log

Tensorboard auf Ihrem örtlichen Haus servieren. Die Verlustkurven, synthetisierte Melspektrogramme und Audios werden gezeigt.

'none' und 'DeepSpeaker' ) einstellen.

Bitte zitieren Sie dieses Repository durch das "Zitieren Sie dieses Repository" des Abschnitts (oben rechts auf der Hauptseite).