แหล่งที่มาของภาพ: MK Pavan Kumar

แหล่งที่มาของภาพ: Pinecone

โครงการนี้ใช้ประโยชน์จากโมเดลโอเพ่นซอร์สเพื่อสร้าง chatbot สำหรับ Nepse, Nepal Stock Exchange Ltd โดยใช้เทคนิคการสร้างการเพิ่มการดึง PDF หนังสือเล่มเล็กของ Nepse ใช้สำหรับการตอบคำถาม โครงการใช้โมเดลโอเพนซอร์ซต่อไปนี้:

Intel/Neural-Chat-7b-V3-1: LLM โอเพนซอร์ซซึ่งพัฒนาโดย Intel และ quantized โดย Thebloke โดยเฉพาะรุ่น GPTQ 8 บิตถูกใช้เนื่องจากหน่วยความจำที่ จำกัด

All-MPNET-BASE-V2: หม้อแปลงประโยคโอเพนซอร์ซจากการกอดใบหน้าที่เรียกว่า All-MPNET-BASE-V2 ใช้เพื่อสร้างการฝังคุณภาพสูง

AAI/BGE-RERANKER-LARGE: โมเดลการจัดเรียงโอเพ่นซอร์สจากการกอดใบหน้าที่เรียกว่า BGE-RERANKER-LARGE ใช้ในการจัดอันดับเอกสารที่ดึงมาจากร้านค้าเวกเตอร์อีกครั้ง

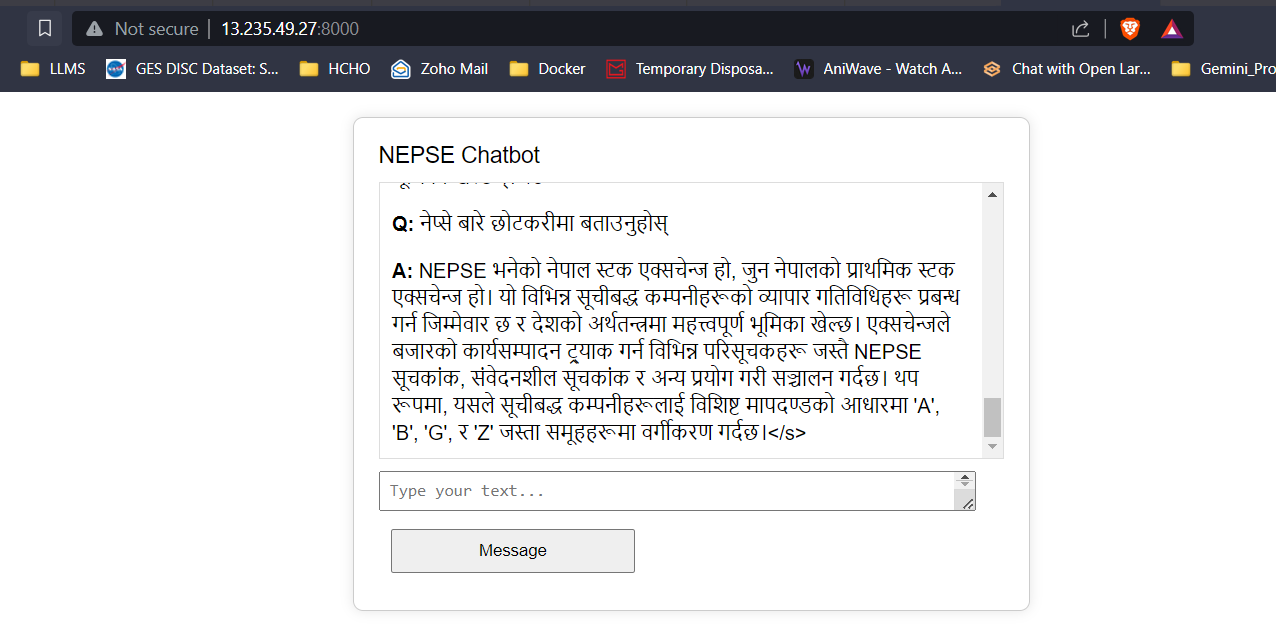

Google Translate API: Google Translate API ฟรีใช้เพื่อทำการแปลระหว่างเนปาลและเนื้อหาภาษาอังกฤษ

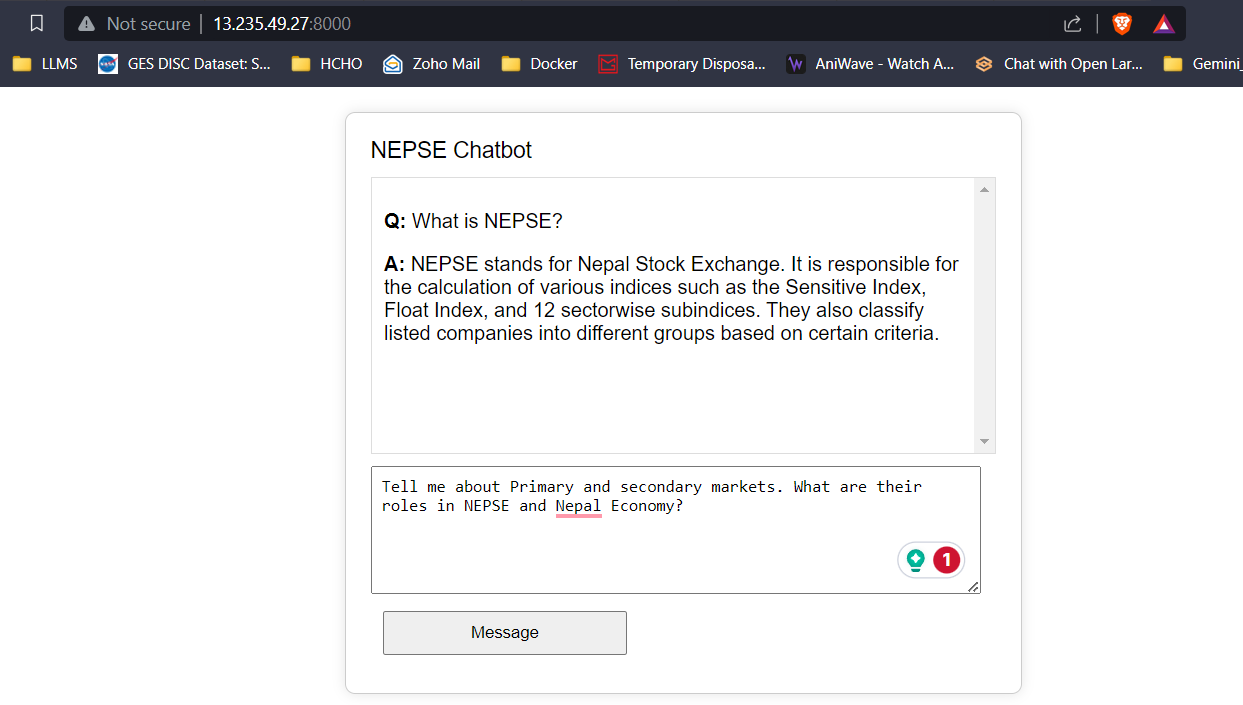

ข้อมูลข้อความจากหนังสือเล่มเล็กของ Nepse ได้รับการทำความสะอาดแบ่งออกเป็นชิ้นและการฝังตัวได้รับการพัฒนาโดยใช้หม้อแปลงประโยคซึ่งจะถูกเพิ่มเข้าไปในฐานข้อมูลเวกเตอร์ FAISS เมื่อผู้ใช้ป้อนคำถามการฝังตัวจากอินพุตได้รับการพัฒนาและคำถามที่ฝังอยู่จะถูกใช้เพื่อทำการค้นหาเวกเตอร์เพื่อดึงเอกสาร K ด้านบน เอกสารที่ดึงมาบน K จะถูกส่งผ่านไปยังโมเดล Reranking เพื่อเพิ่มคุณภาพและความเกี่ยวข้องของการดึงข้อมูล ในที่สุดเอกสาร K-Reranked อันดับต้น ๆ จะถูกส่งผ่านเป็นบริบทของ LLM ด้วยวิศวกรรมที่รวดเร็วเพื่อให้คำตอบแก่ผู้ใช้

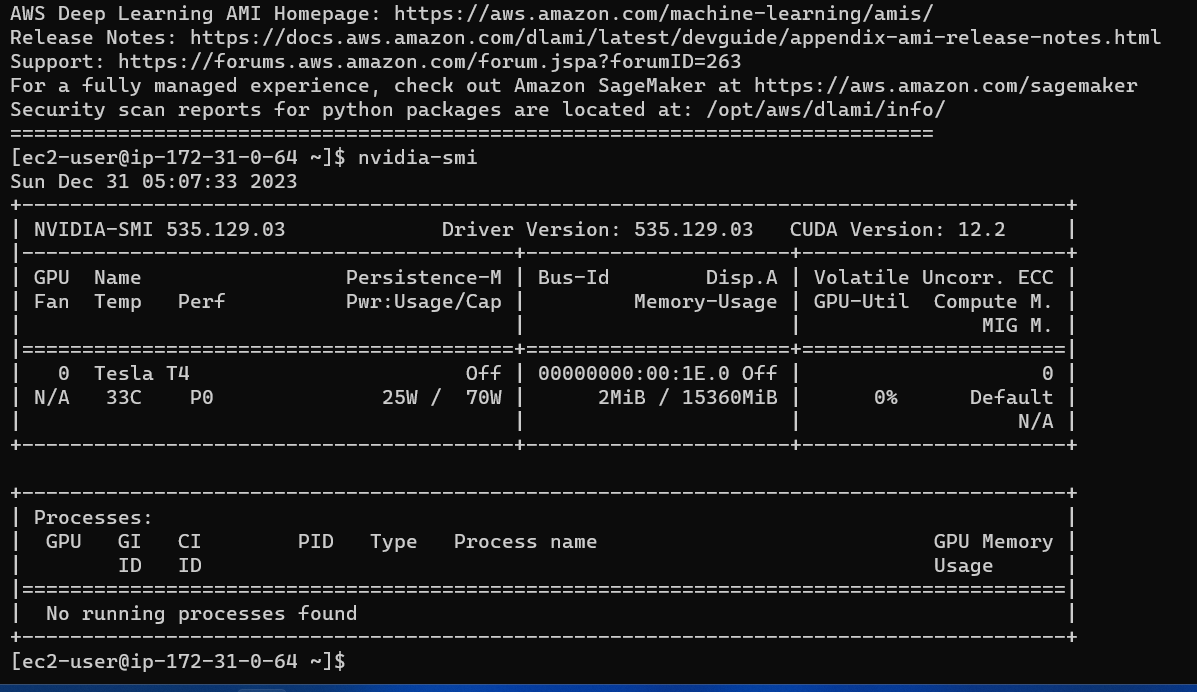

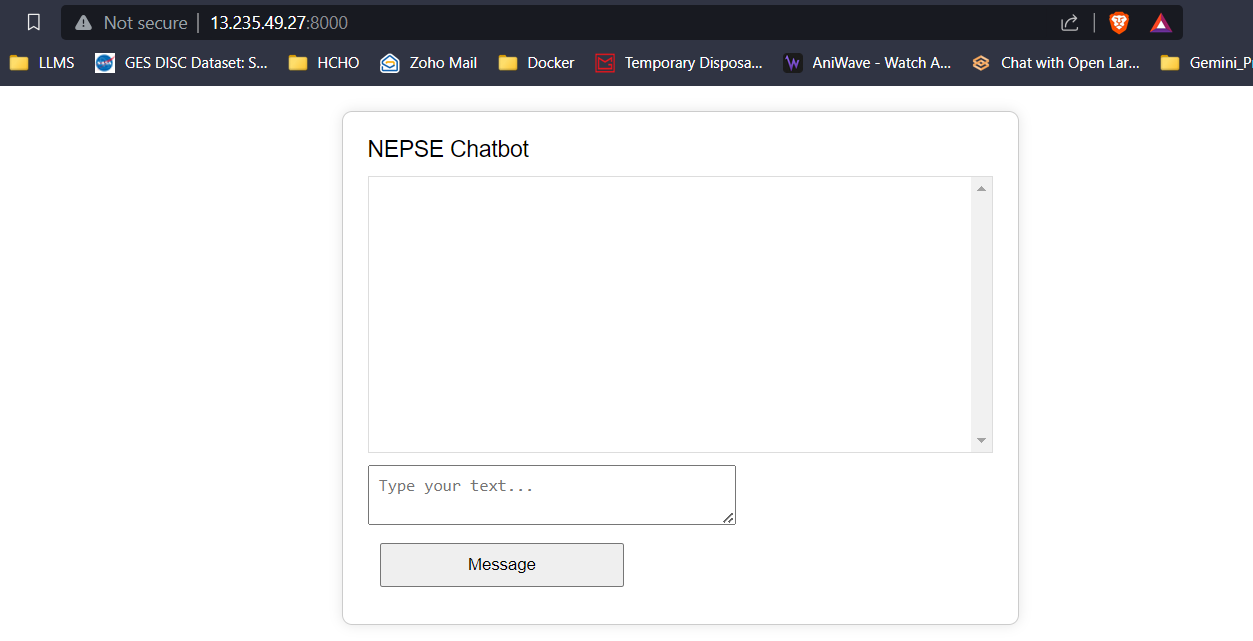

ส่วนหน้าอย่างง่ายโดยใช้ HTML, CSS และ JavaScript และแบ็กเอนด์ที่ใช้ขวดได้รับการพัฒนา การตอบสนอง/โทเค็นที่คาดการณ์จาก LLM จะถูกสตรีมไปยังส่วนหน้าแบบเรียลไทม์เพื่อลดเวลาแฝงของผู้ใช้และเพิ่มประสบการณ์ผู้ใช้ แอปพลิเคชันถูกปรับใช้ใน อินสแตนซ์ G4DN.xlarge AWS EC2 สำหรับการอนุมานแบบเรียลไทม์

ด้วย VRAM 16 GB ทั้งสามรุ่นจะพอดีโดยไม่มีปัญหาใด ๆ ภาพหน้าจอและคลิปด้านล่างแสดงความสามารถในการตอบคำถามแบบเรียลไทม์ของ Nepse Chatbot ที่ปรับใช้ใน AWS

LLM Response Streaming (เช่น CHATGPT)

คลิกที่ลิงค์ด้านล่างเพื่อดู/ดาวน์โหลดวิดีโอเต็ม

ดูวิดีโอ