이미지 출처 : MK Pavan Kumar

이미지 출처 : PENECONE

이 프로젝트는 오픈 소스 모델을 활용하여 검색 증강 생성 기술을 사용하여 NEPSE 인 NEPSE의 챗봇을 구축합니다. NEPSE 소책자 PDF는 질문 응답에 사용됩니다. 이 프로젝트는 다음과 같은 오픈 소스 모델을 사용합니다.

Intel/Neural-Chat-7B-V3-1 : 원래 Intel에 의해 개발되고 TheBloke에 의해 정량화 된 오픈 소스 LLM이 사용됩니다. 구체적으로, 8 비트 GPTQ 양자화 된 버전은 제한된 메모리로 인해 사용됩니다.

All-MPNet-Base-V2 : All-MPNet-Base-V2라는 포옹면에서 오픈 소스 문장 변압기는 고품질 임베딩을 생성하는 데 사용됩니다.

AAI/BGE-RERANKER-LARGE : BGE-RERANKER-LARGE라는 Hugging Face의 오픈 소스 재고 모델은 벡터 스토어에서 검색된 문서를 다시 평가하는 데 사용됩니다.

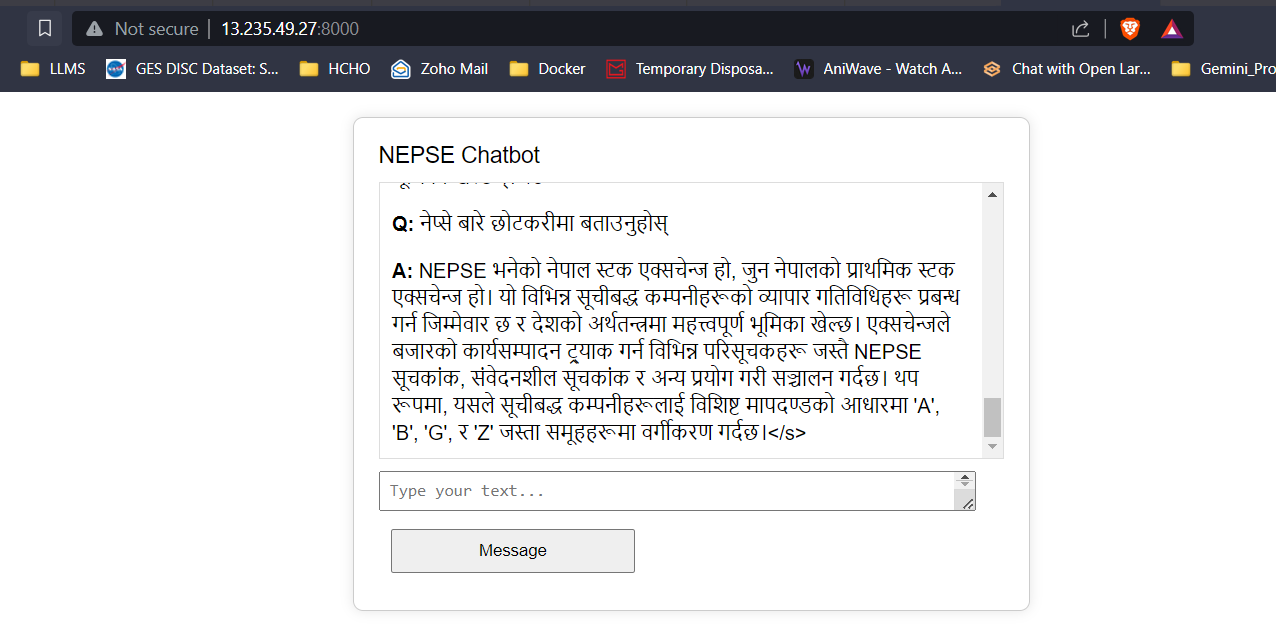

Google Translate API : 무료 Google Translate API는 네팔과 영어 콘텐츠 간의 번역을 수행하는 데 사용됩니다.

NEPSE 소책자의 텍스트 데이터는 청소하고 청크로 나뉘며 임베딩은 FAISS 벡터 데이터베이스에 추가되는 문장 변압기를 사용하여 개발됩니다. 사용자가 질문을 입력하면 입력의 임베딩이 개발되고 질문 임베딩은 벡터 검색을 수행하여 상단 K 문서를 검색합니다. Top-K 검색 된 문서는 검색의 품질과 관련성을 향상시키기 위해 재고 모델로 전달됩니다. 마지막으로, 최상위 K- 랭킹 문서는 사용자에게 답변을 제공하기 위해 적절한 프롬프트 엔지니어링을 통해 LLM에 컨텍스트로 전달됩니다.

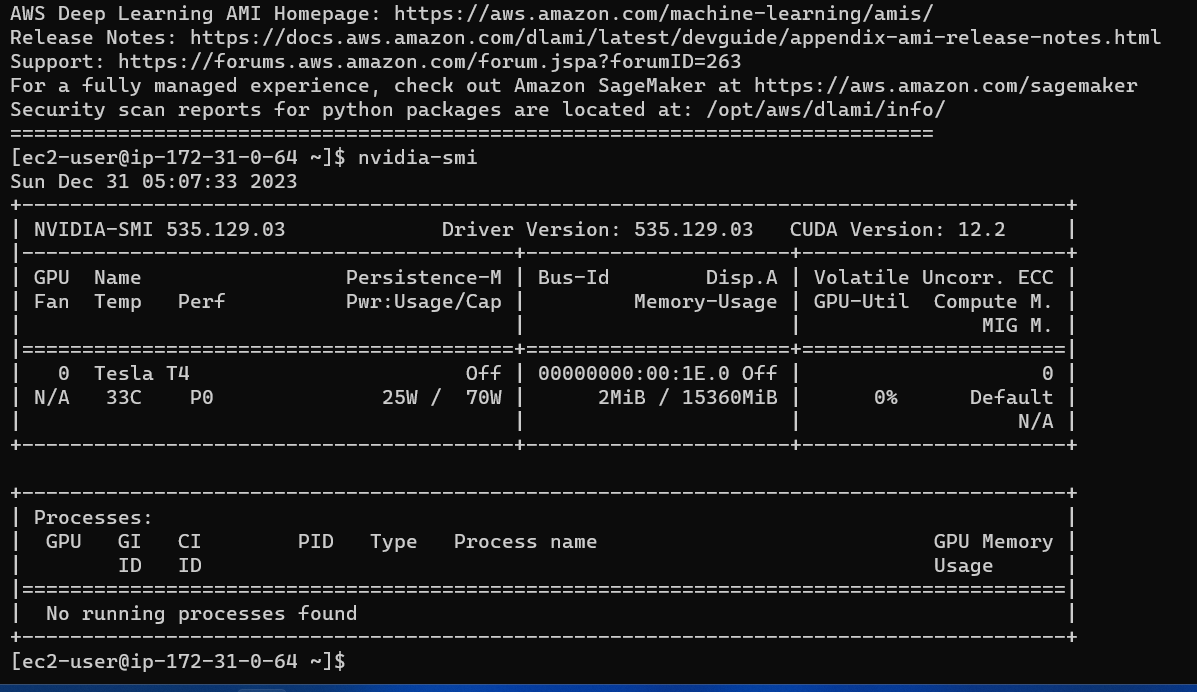

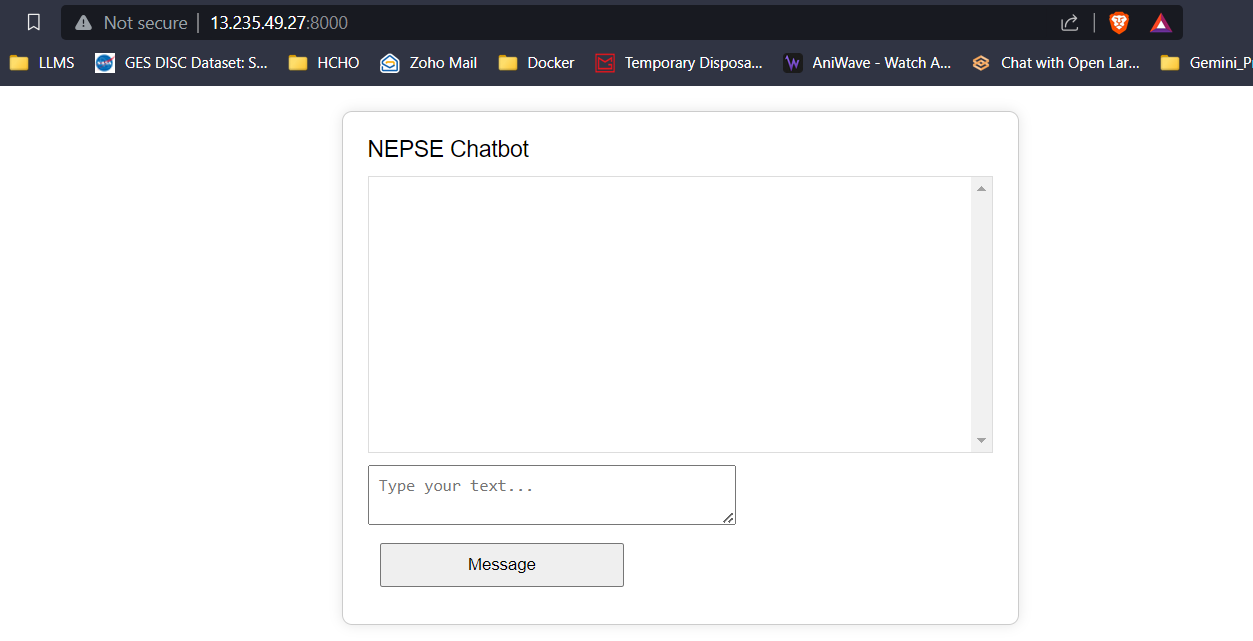

HTML, CSS 및 JavaScript를 사용한 간단한 프론트 엔드 및 플라스크를 사용한 백엔드가 개발되었습니다. LLM의 응답/예측 토큰은 사용자 대기 시간을 줄이고 사용자 경험을 향상시키기 위해 실시간으로 프론트 엔드로 스트리밍됩니다. 응용 프로그램은 실시간 추론을 위해 g4dn.xlarge aws ec2 인스턴스 에 배포됩니다.

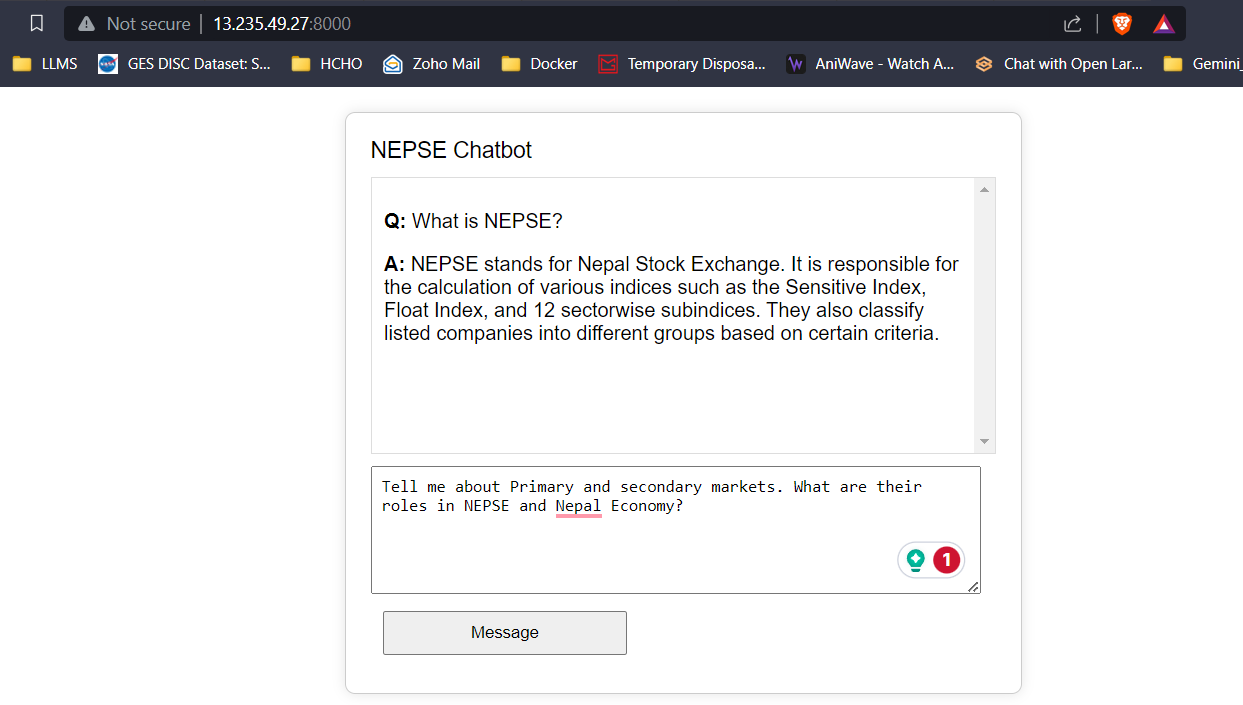

16GB의 VRAM을 사용하면 세 가지 모델 모두 문제없이 쉽게 맞습니다. 아래의 스크린 샷과 클립은 AWS에 배포 된 NEPSE 챗봇의 실시간 질문 응답 기능을 보여줍니다.

LLM 응답 스트리밍 (chatgpt와 같은)

전체 비디오를보고/다운로드하려면 아래 링크를 클릭하십시오.

비디오 시청