Источник изображения: MK PAVAN KUMAR

Источник изображения: Pinecone

Этот проект использует модели с открытым исходным кодом для создания чат-бота для Nepse, Nepal Focal Exchange Ltd, используя методику извлечения дополненного генерации. Nepse Booklet PDF используется для ответа вопросам. Проект использует следующие модели с открытым исходным кодом:

Intel/Neural-Chat-7b-V3-1: используется LLM с открытым исходным кодом, изначально разработанный Intel и квантованный TheBloke. В частности, 8-битная квантовая версия GPTQ используется из-за ограниченной памяти.

All-MPnet-Base-V2: трансформатор предложений с открытым исходным кодом от обнимающего лица, называемого All-MPnet-Base-V2, используется для создания высококачественных встраиваний.

AAI/BGE-RERANKER-LARGE: модель реэранзирования с открытым исходным кодом от обнимающего лица под названием BGE-RERANCER-LARGE используется для повторного оценки полученных документов из векторного магазина.

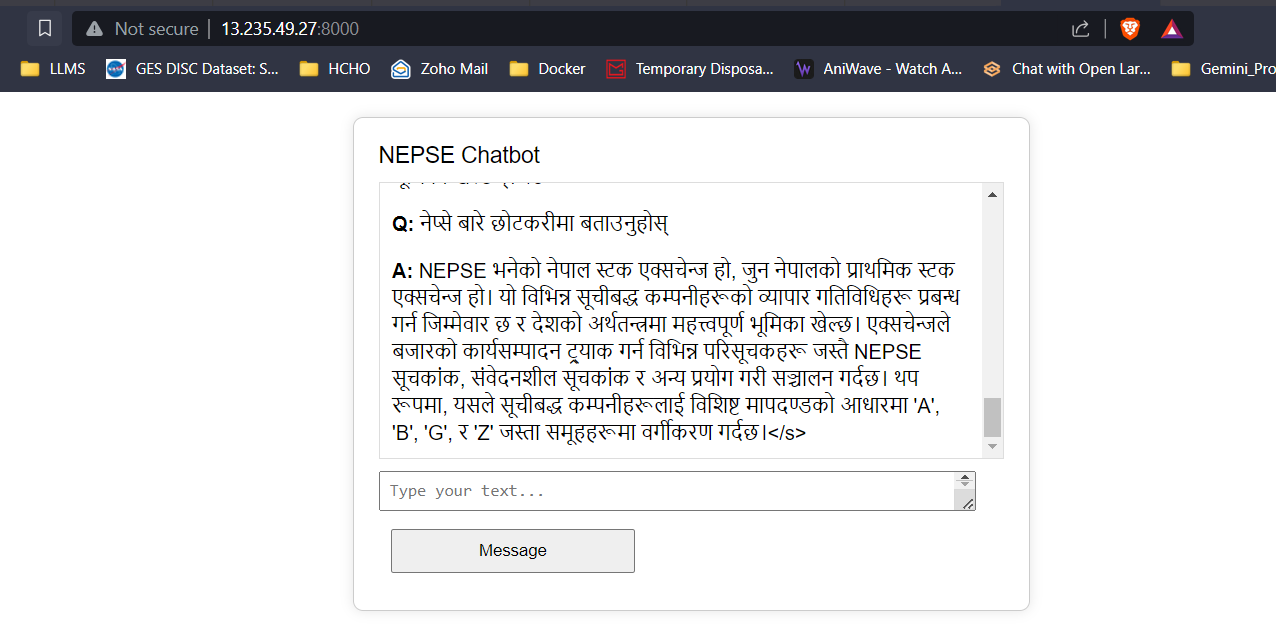

Google Translate API: бесплатный API Google Translate используется для выполнения перевода между непальским и английским контентом.

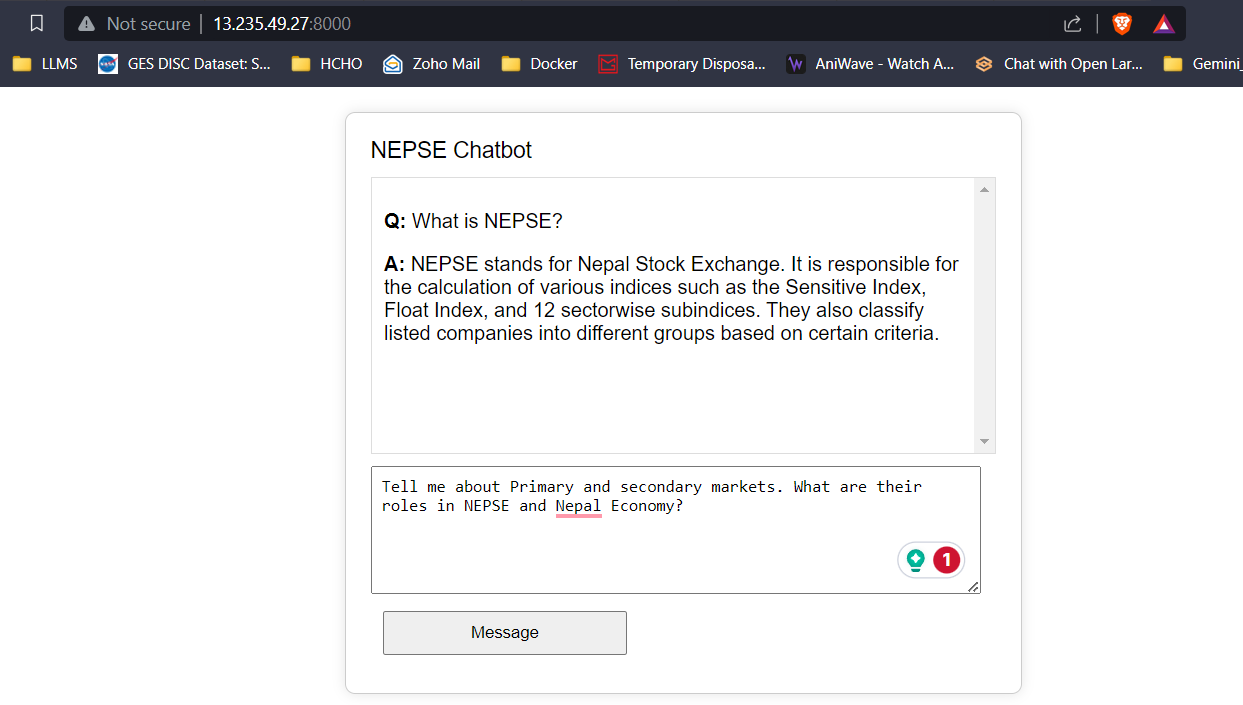

Текстовые данные из буклета Nepse очищаются, делятся на куски, а встроения разрабатываются с использованием трансформаторов предложений, которые добавляются в базу данных вектора FAISS. Когда пользователь вводит вопрос, разрабатываются вставки с ввода, а вопрос встроенных введений используется для выполнения векторного поиска для получения верхних документов K. Полученные документы Top-K передаются в модель реэранкировки для повышения качества и актуальности поиска. Наконец, ведущие документы K-reranked передаются в качестве контекста для LLM с надлежащей быстрой инженерией для предоставления ответов пользователям.

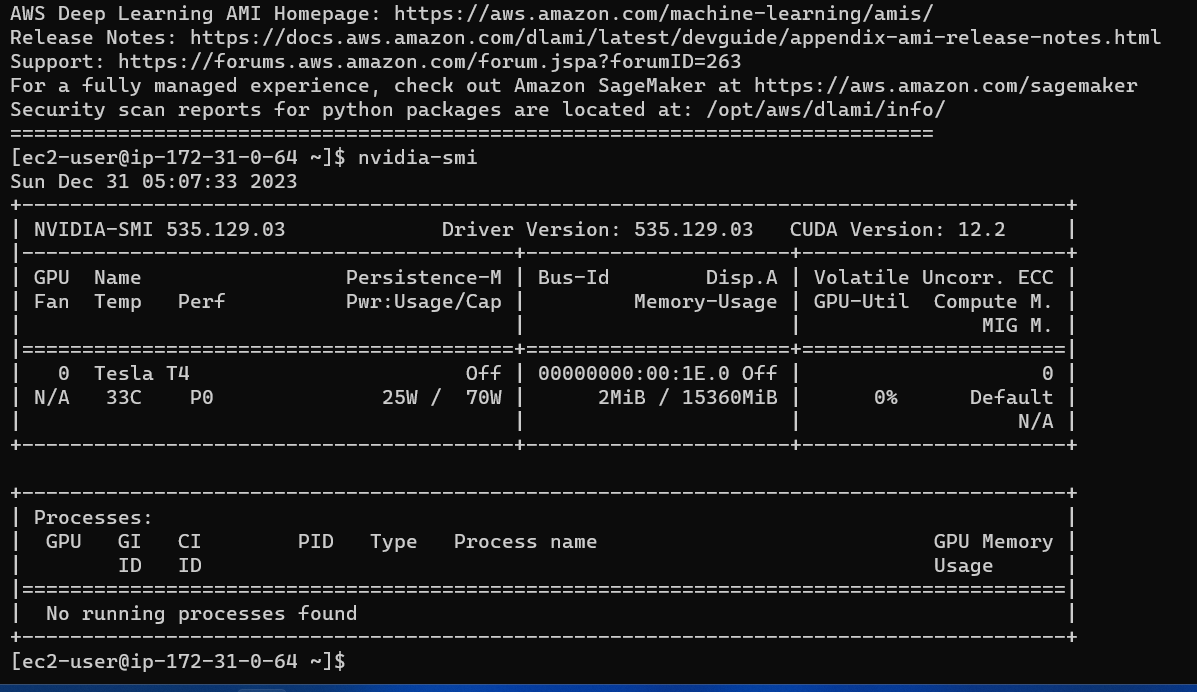

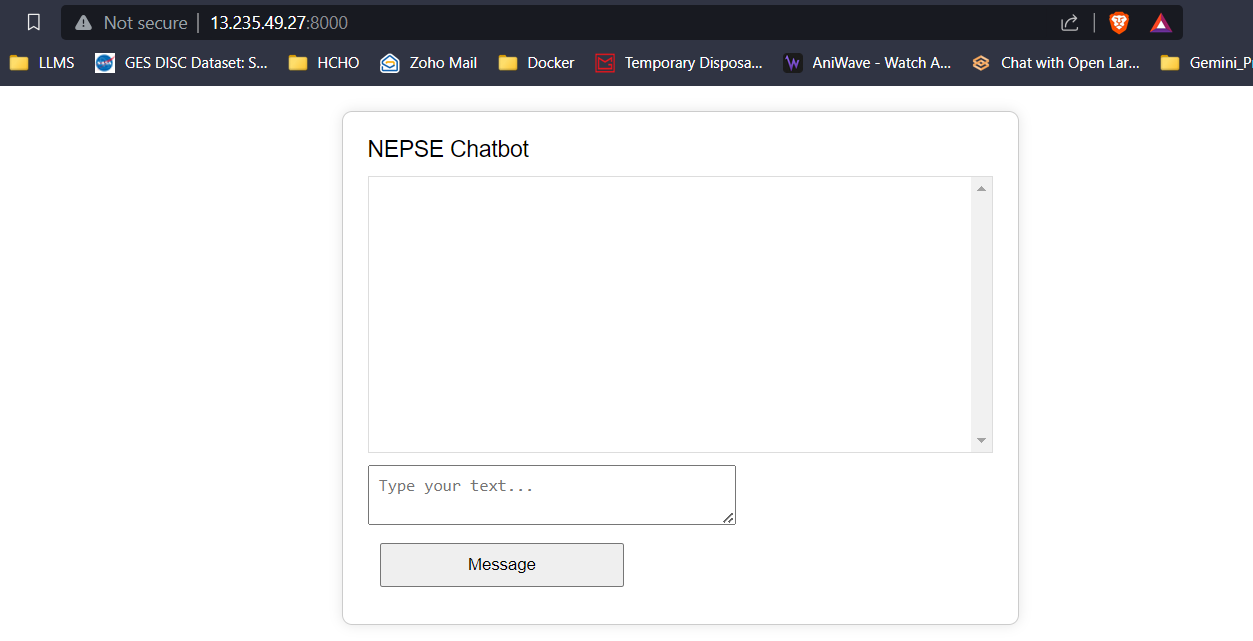

Был разработан простой фронт с использованием HTML, CSS и JavaScript, а также бэкэнд с использованием колбы. Ответы/прогнозируемые токены от LLM транслируются на фронт в режиме реального времени, чтобы уменьшить задержку пользователя и улучшить пользовательский опыт. Приложение развернуто в экземпляре G4DN.xlarge AWS EC2 для вывода в реальном времени.

С 16 ГБ VRAM все три модели будут легко подходить без каких -либо проблем. Скриншоты и клипы ниже демонстрируют возможность вопросов в реальном времени, отвечающего на вопрос Nepse Chatbot, развернутый на AWS.

Потоковая передача ответов LLM (например, CHATGPT)

Нажмите на ссылку ниже, чтобы посмотреть/загрузить полное видео.

Смотреть видео