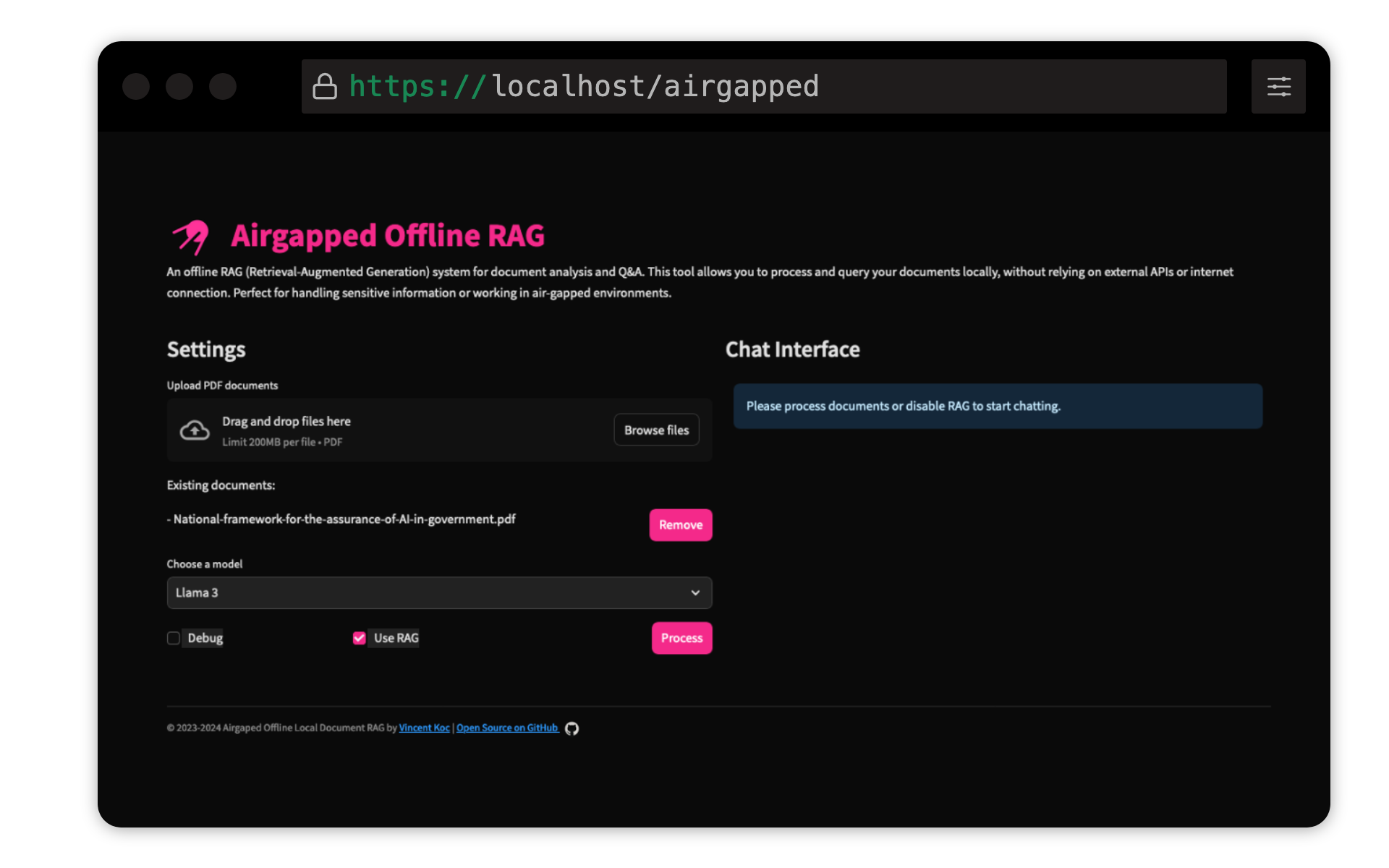

โครงการนี้โดย Vincent KOC ใช้ระบบการตอบคำถามแบบเรียกคืน (RAG) สำหรับเอกสาร มันใช้โมเดล Llama 3, Mistral และ Gemini สำหรับการอนุมานในท้องถิ่นด้วย Llama C ++, Langchain สำหรับการ orchestration, Chromadb สำหรับการจัดเก็บเวกเตอร์และความต่อเนื่องสำหรับส่วนต่อประสานผู้ใช้

ตรวจสอบให้แน่ใจว่ามีการติดตั้ง Python 3.9 : คุณสามารถใช้ pyenv :

pyenv install 3.9.16

pyenv local 3.9.16

pyenv rehash

สร้างสภาพแวดล้อมเสมือนจริงและติดตั้งการพึ่งพา :

make setup

ดาวน์โหลดรุ่น : ดาวน์โหลดรุ่น Llama 3 (8B) และ Mistral (7B) ในรูปแบบ GGUF และวางไว้ใน models/ ไดเรกทอรี TheBloke on Hugging Face ได้แชร์โมเดลที่นี่:

แบบจำลองจาก unsloth ได้รับการทดสอบและสามารถพบได้ที่นี่:

QDDRANT SENTENCE TRANSFORMER MODEL : สิ่งนี้จะถูกดาวน์โหลดโดยอัตโนมัติในการเรียกใช้ครั้งแรก หากเรียกใช้ผ้าขี้ริ้ว airgapped ในเครื่องควรจะเรียกใช้ codebase ด้วยการเข้าถึงอินเทอร์เน็ตในขั้นต้นเพื่อดาวน์โหลดรุ่น

make run

make docker-build

make docker-run

ปรับการตั้งค่าใน config.yaml เพื่อแก้ไขพา ธ รุ่นขนาดก้อนและพารามิเตอร์อื่น ๆ

ยินดีต้อนรับ! กรุณาแยกที่เก็บและส่งคำขอดึง สำหรับการเปลี่ยนแปลงครั้งใหญ่โปรดเปิดปัญหาก่อนเพื่อหารือเกี่ยวกับสิ่งที่คุณต้องการเปลี่ยนแปลง

โครงการนี้ได้รับใบอนุญาตภายใต้ใบอนุญาตสาธารณะ GNU ทั่วไป v3.0 (GPLV3) ดูไฟล์ใบอนุญาตสำหรับรายละเอียด

หมายความว่า:

สำหรับข้อมูลเพิ่มเติมโปรดเยี่ยมชม GNU GPL V3