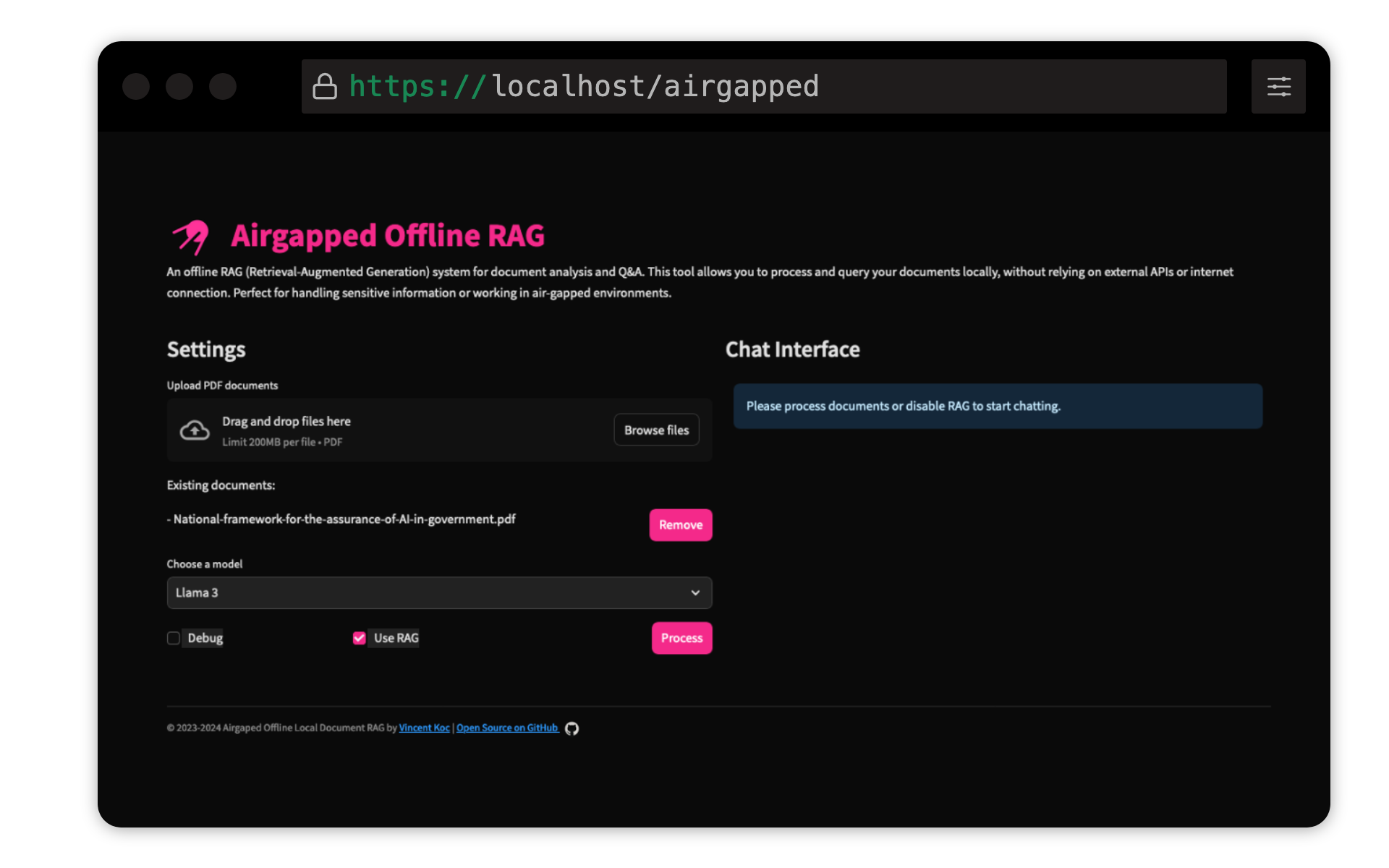

Proyek ini oleh Vincent KOC mengimplementasikan sistem penurunan tanya jawab berbasis pengambilan (RAG) untuk dokumen. Ini menggunakan model Llama 3, Mistral, dan Gemini untuk inferensi lokal dengan LLAMA C ++, Langchain untuk orkestrasi, ChromadB untuk penyimpanan vektor, dan learnlit untuk antarmuka pengguna.

Pastikan Python 3.9 diinstal : Anda dapat menggunakan pyenv :

pyenv install 3.9.16

pyenv local 3.9.16

pyenv rehash

Buat lingkungan virtual dan instal dependensi :

make setup

Model Unduh : Unduh model LLAMA 3 (8B) dan Mistral (7B) dalam format GGUF dan tempatkan di models/ direktori. TheBloke on Hugging Face telah berbagi model di sini:

Model -model dari unsloth juga telah diuji dan dapat ditemukan di sini:

Model Transformer Kalimat Qdrant : Ini akan diunduh secara otomatis pada menjalankan pertama. Jika menjalankan rag aergapped secara lokal, yang terbaik adalah menjalankan basis kode dengan akses internet awalnya untuk mengunduh model.

make run

make docker-build

make docker-run

Sesuaikan pengaturan di config.yaml untuk memodifikasi jalur model, ukuran chunk, dan parameter lainnya.

Kontribusi dipersilakan! Harap bayar repositori dan kirimkan permintaan tarik. Untuk perubahan besar, buka masalah terlebih dahulu untuk membahas apa yang ingin Anda ubah.

Proyek ini dilisensikan di bawah GNU General Public License v3.0 (GPLV3). Lihat file lisensi untuk detailnya.

Ini berarti:

Untuk informasi lebih lanjut, kunjungi GNU GPL v3.