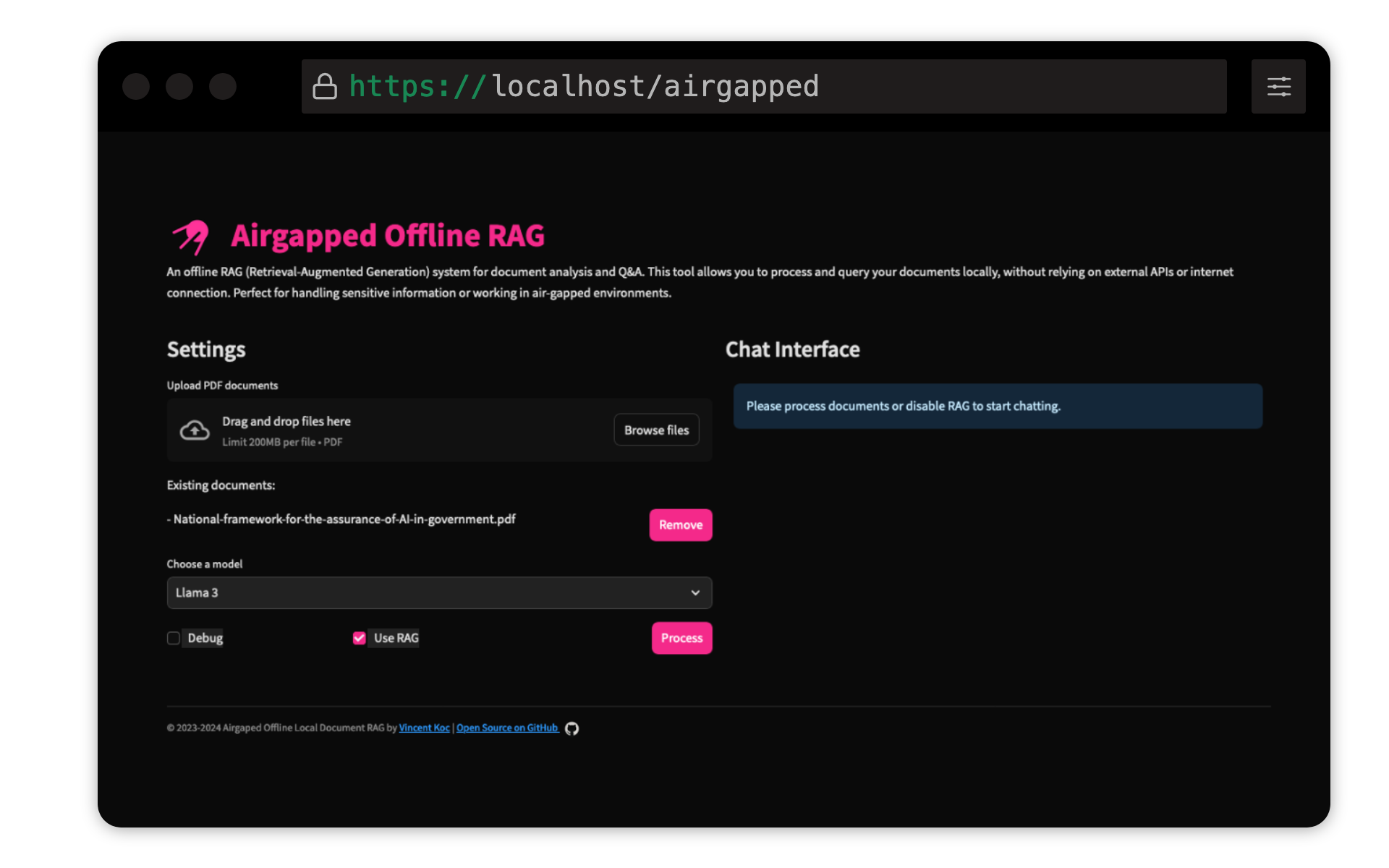

Dieses Projekt von Vincent KOC implementiert ein RAG-Basis-Fragen-Antworten-System für Dokumente. Es verwendet Lama 3, Mistral- und Gemini -Modelle für lokale Inferenz mit Lama C ++, Langchain für Orchestrierung, Chromadb für den Vektorspeicher und die Stromversorgung für die Benutzeroberfläche.

Stellen Sie sicher, dass Python 3.9 installiert ist : Sie können pyenv verwenden:

pyenv install 3.9.16

pyenv local 3.9.16

pyenv rehash

Erstellen Sie eine virtuelle Umgebung und installieren Sie Abhängigkeiten :

make setup

Herunterladen Modelle : Laden Sie die Modelle LLAMA 3 (8B) und Mistral (7B) im GGUF -Format herunter und platzieren Sie sie in die models/ Verzeichnis. TheBloke on Sharging Face hat die Modelle hier geteilt:

Die Modelle von unsloth wurden ebenfalls getestet und können hier gefunden werden:

QDRANT -Satztransformatormodell : Dies wird beim ersten Lauf automatisch heruntergeladen. Wenn Sie den Airgack Rag lokal ausführen, führen Sie die Codebasis am besten mit dem Internetzugang aus, um das Modell herunterzuladen.

make run

make docker-build

make docker-run

Passen Sie die Einstellungen in config.yaml an, um Modellpfade, Chunk -Größen und andere Parameter zu ändern.

Beiträge sind willkommen! Bitte geben Sie das Repository aus und senden Sie eine Pull -Anfrage. Für wichtige Änderungen öffnen Sie zuerst ein Problem, um zu besprechen, was Sie ändern möchten.

Dieses Projekt ist gemäß der GNU General Public Lizenz v3.0 (GPLV3) lizenziert. Weitere Informationen finden Sie in der Lizenzdatei.

Das heisst:

Weitere Informationen finden Sie unter GNU GPL V3.