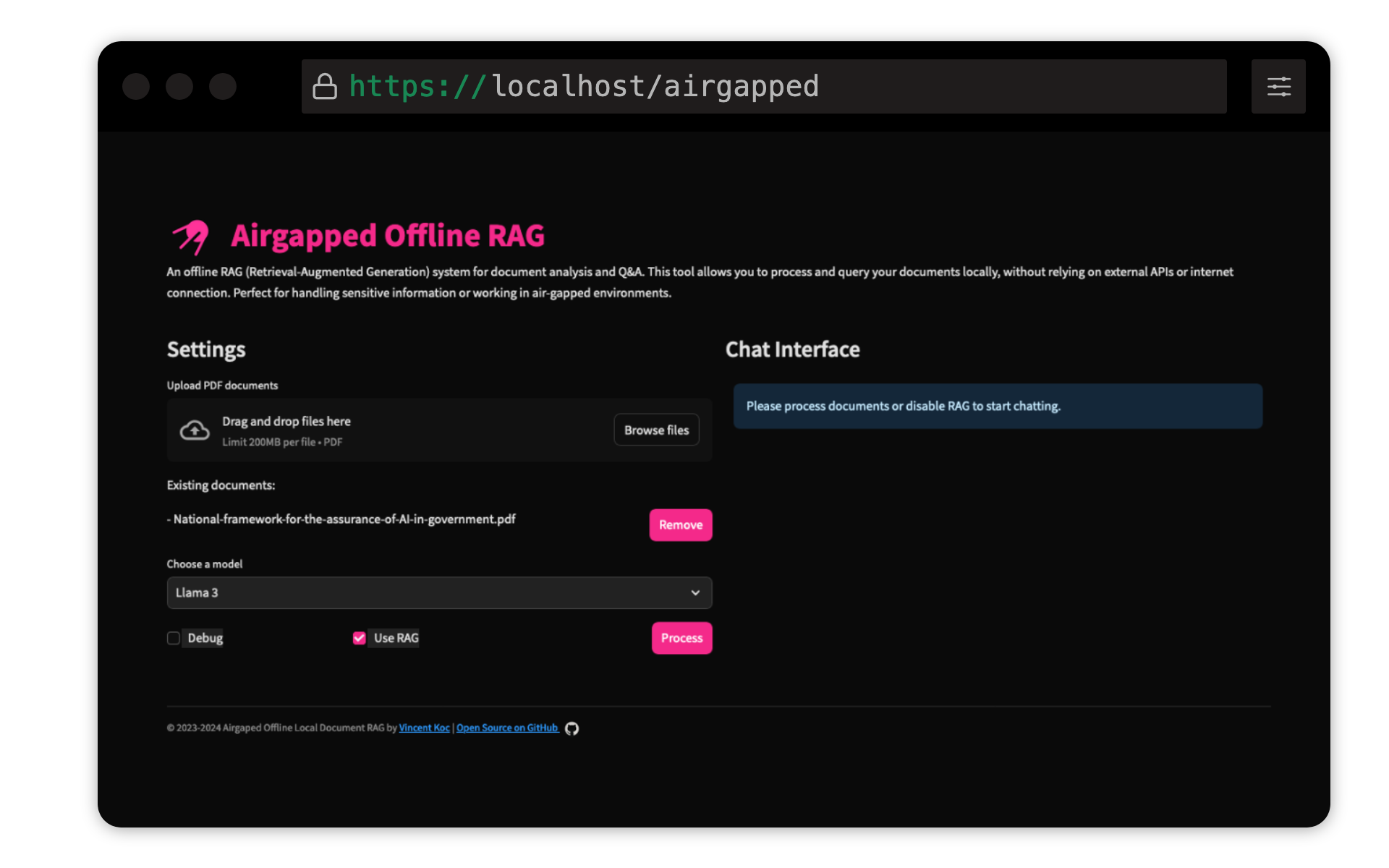

Vincent KOC 의이 프로젝트는 문서에 대한 검색 세대 (RAG) 기반 질문 응답 시스템을 구현합니다. LLAMA 3, MISTRAL 및 GEMINI 모델을 사용하여 LLAMA C ++, 오케스트레이션 용 Langchain, 벡터 저장을위한 ChromADB 및 사용자 인터페이스의 경우 간소를 사용합니다.

Python 3.9가 설치되었는지 확인하십시오 : pyenv 사용할 수 있습니다.

pyenv install 3.9.16

pyenv local 3.9.16

pyenv rehash

가상 환경을 만들고 종속성을 설치하십시오 .

make setup

모델 다운로드 : LLAMA 3 (8B) 및 MISTRAL (7B) 모델을 GGUF 형식으로 다운로드하여 models/ 디렉토리에 배치하십시오. Hugging Face의 TheBloke 여기에서 모델을 공유했습니다.

unsloth 의 모델도 테스트되었으며 여기에서 찾을 수 있습니다.

Qdrant Sentence Transformer 모델 : 첫 번째 실행에 자동으로 다운로드됩니다. 에어 갭 래그를 로컬로 실행하는 경우 처음에 인터넷 액세스로 코드베이스를 실행하여 모델을 다운로드하는 것이 가장 좋습니다.

make run

make docker-build

make docker-run

config.yaml 에서 설정을 조정하여 모델 경로, 청크 크기 및 기타 매개 변수를 수정하십시오.

기부금을 환영합니다! 저장소를 포크하고 풀 요청을 제출하십시오. 주요 변경 사항을 위해 먼저 문제를 열어 변경하고 싶은 것을 논의하십시오.

이 프로젝트는 GNU General Public License v3.0 (GPLV3)에 따라 라이센스가 부여됩니다. 자세한 내용은 라이센스 파일을 참조하십시오.

이것은 다음을 의미합니다.

자세한 내용은 GNU GPL V3를 방문하십시오.