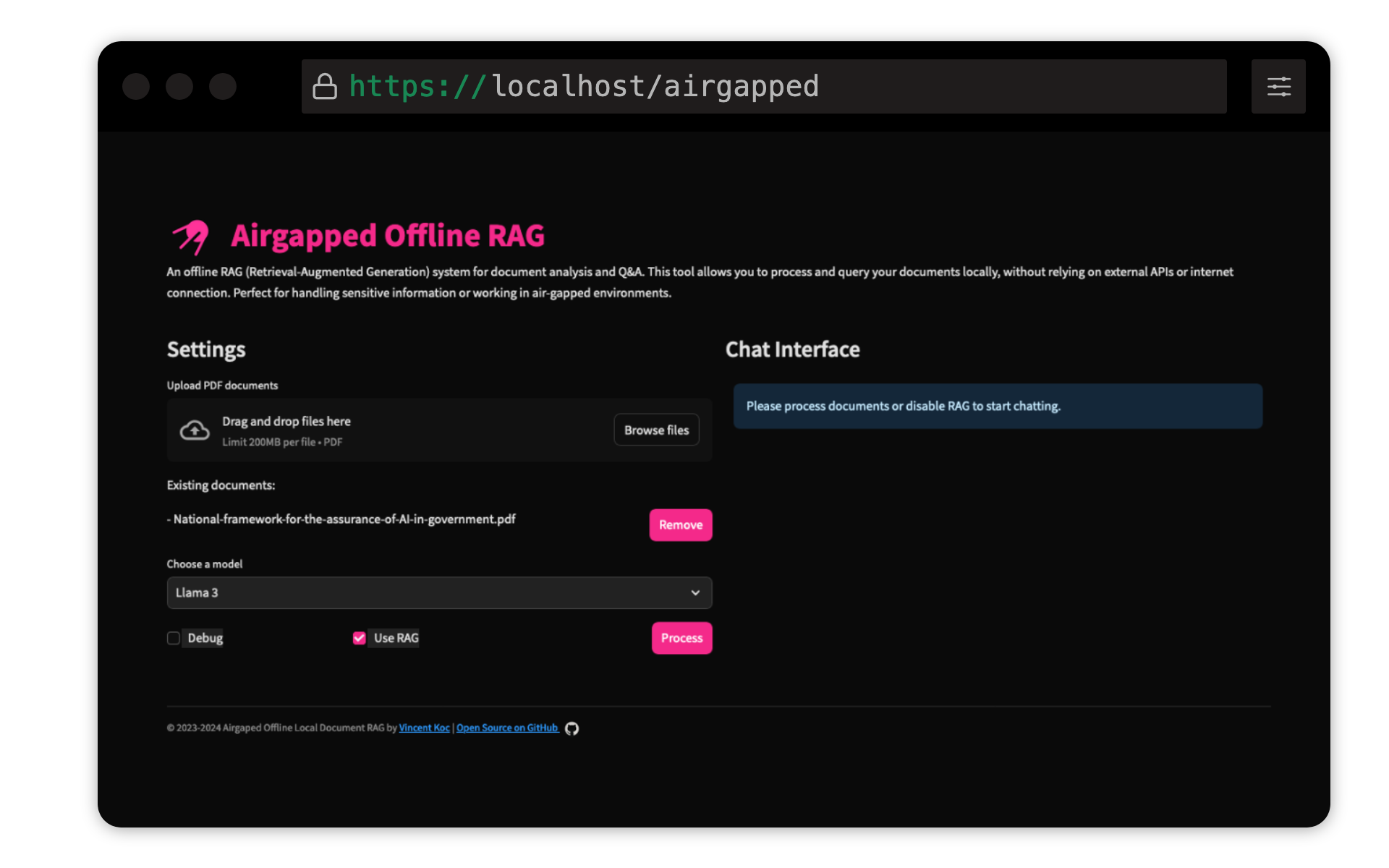

Этот проект Vincent KOC реализует систему для документов, основанную на извлечении-августах (RAG), для документов. Он использует модели Llama 3, Mistral и Gemini для локального вывода с Llama C ++, Langchain для оркестровки, ChromAdb для векторного хранения и потоковой связи для пользовательского интерфейса.

Убедитесь, что Python 3.9 установлен : вы можете использовать pyenv :

pyenv install 3.9.16

pyenv local 3.9.16

pyenv rehash

Создайте виртуальную среду и установите зависимости :

make setup

Скачать модели : Загрузите модели Llama 3 (8b) и Mistral (7b) в формате GGUF и поместите их в models/ каталог. TheBloke on Hugging Face поделился моделями здесь:

Модели из unsloth также были протестированы и могут быть найдены здесь:

Модель трансформатора Qdrant предложения : это будет загружено автоматически при первом забеге. Если запустить тряпку с воздушным приводом локально, лучше всего запустить кодовую базу с доступом к Интернету, чтобы загрузить модель.

make run

make docker-build

make docker-run

Регулируйте настройки в config.yaml , чтобы изменить пути модели, размеры кусок и другие параметры.

Взносы приветствуются! Пожалуйста, распадайте репозиторий и отправьте запрос на привлечение. Для серьезных изменений, пожалуйста, сначала откройте проблему, чтобы обсудить, что вы хотели бы изменить.

Этот проект лицензирован в рамках общей публичной лицензии GNU V3.0 (GPLV3). Смотрите файл лицензии для получения подробной информации.

Это означает:

Для получения дополнительной информации посетите GNU GPL V3.