21 февраля 2025 года команда интернационализации Alibaba официально объявила о открытом исходном источнике своей последней мультимодальной крупной языковой серии OVIS2. Этот основной шаг отмечает дальнейший прорыв Alibaba в области искусственного интеллекта, а также предоставляет глобальным разработчикам мощные технические инструменты для содействия разработке и применению мультимодальных крупных моделей.

OVIS2 - последняя версия серии OVIS модели международной команды Alibaba. По сравнению с предисловием версии 1.6, OVIS2 имеет значительно оптимизированные методы построения данных и обучения. Это не только улучшает плотность способностей мелких моделей, но и значительно улучшает цепочку мышления (COT) рассуждений посредством обучения в обучении и обучении предпочтениям. Кроме того, OVIS2 добавил функции обработки видео и многократного изображения и добился значительного прогресса в многоязычных возможностях и возможностях OCR в сложных сценариях, что еще больше улучшило возможности практичности и обобщения модели.

Серия OVIS2 с открытым исходным кодом на этот раз включает в себя шесть версий: 1B, 2B, 4B, 8B, 16B и 34B, каждая версия достигает уровня SOTA (состояние искусства) одинакового размера. Среди них OVIS2-34B особенно хорошо показал в авторитетном списке оценки OpenCompass. В мультимодальном списке общих возможностей OVIS2-34B занимает второе место во всех моделях с открытым исходным кодом, превосходя многие флагманские модели с открытым исходным кодом 70B с менее чем половиной размера параметров. В списке мультимодальных математических рассуждений в первую очередь занимает первое место OVIS2-34B, а другие версии размера также показывают отличные навыки рассуждений. Эти достижения не только проверяют эффективность архитектуры OVIS, но и демонстрируют огромный потенциал сообщества с открытым исходным кодом в продвижении развития мультимодальных крупных моделей.

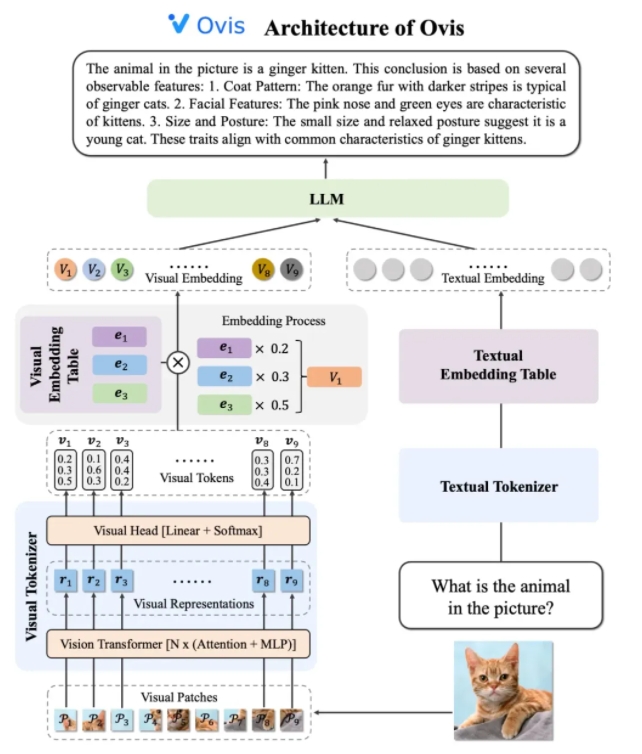

Дизайн архитектуры OVIS2 умно решает ограничения различий в стратегиях внедрения между модалами. Он состоит из трех основных компонентов: визуального токенизатора, таблицы визуального встраивания и LLM (модель большого языка). Визуальный токенизатор делит входное изображение на несколько блоков изображения, использует визуальный трансформатор для извлечения функций и соответствует функциям с «визуальными словами» через слой визуальной головки для генерации вероятностного визуального токена. В таблице визуального встраивания хранится векторы встраивания, соответствующие каждому визуальному слову, в то время как LLM рассыпает вектор визуального встраивания и вектор текста для обработки и, наконец, генерирует выход текста для выполнения мультимодальной задачи.

С точки зрения стратегий обучения, OVIS2 принимает четырехэтапный метод обучения, чтобы полностью стимулировать его мультимодальное понимание способности. Первый этап замораживает большинство параметров LLM и Vit (визуальный трансформатор), фокусируясь на обучении модулям зрения, обучению визуальным характеристикам для внедрения преобразований. На втором этапе дополнительно улучшается возможности извлечения признаков визуального модуля и улучшает понимание изображений с высоким разрешением, многоязычные возможности и OCR. Третий этап выравнивает формат диалога визуального встраивания с LLM с помощью данных визуальной подписи в форме диалога. Четвертый этап состоит в том, чтобы провести мультимодальное обучение обучению и предпочтение для дальнейшего улучшения способности модели следовать инструкциям пользователей и качества вывода в рамках нескольких режимов.

Чтобы улучшить возможности понимания видео, OVIS2 разработал инновационный алгоритм выбора ключей. Алгоритм выбирает наиболее полезные видео кадры на основе корреляции между кадрами и текстом, комбинированным разнообразием между кадрами и последовательности кадров. Благодаря высокомерным расчетам условного сходства, процесса детерминантной точки (DPP) и процесса принятия решений Марков (MDP) алгоритм может эффективно выбирать ключевые кадры в ограниченном визуальном контексте, тем самым значительно улучшая производительность понимания видео.

Модель серии OVIS2 особенно хорошо сыграла в списке мультимодальной оценки OpenCompass. Модели разных размеров достигли результатов SOTA по нескольким критериям. Например, OVIS2-34B занял второе место и первое в мультимодальной общей способности и списке математических рассуждений, соответственно, показывая ее мощную производительность. Кроме того, OVIS2 также достиг ведущих результатов в списке понимания видео, дополнительно доказывая свои преимущества в мультимодальных задачах.

Команда интернационализации Alibaba заявила, что открытый исходный код является ключевой силой в продвижении прогресса технологии ИИ. Публично поделившись результатами исследований OVIS2, команда с нетерпением ждет возможности изучить передовые мультимодальные крупные модели с глобальными разработчиками и вдохновлять более инновационные приложения. В настоящее время код OVIS2 был открыт для GitHub, и модель может быть получена на платформах обнимающего лица и моделей, а онлайн -демонстрации предоставляются для пользовательского опыта. Связанные исследовательские работы также были опубликованы на ARXIV для справки разработчиками и исследователями.

Код: https://github.com/aidc-ai/ovis

Модель (HuggingFace): https://huggingface.co/aidc-ai/ovis2-34b

Модели: https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

Демо: https://huggingface.co/spaces/aidc-ai/ovis2-16b

arxiv: https: //arxiv.org/abs/2405.20797