2025 년 2 월 21 일, Alibaba의 국제화 팀은 공식적으로 최신 멀티 모달 대형 언어 모델 OVIS2 시리즈의 오픈 소스를 공식적으로 발표했습니다. 이 주요 움직임은 인공 지능 분야에서 Alibaba의 획기적인 획기적인 혁신을 나타내며, 세계 개발자에게 멀티 모달 대형 모델의 개발 및 적용을 촉진하는 강력한 기술 도구를 제공합니다.

OVIS2는 Alibaba 국제 팀의 OVIS 시리즈 모델의 최신 버전입니다. OVIS2는 데이터 구성 및 교육 방법을 크게 최적화했습니다. 소규모 모델의 능력 밀도를 향상시킬뿐만 아니라 교육 미세 조정 및 선호도 학습을 통해 사고 체인 (COT) 추론 능력을 크게 향상시킵니다. 또한 OVIS2는 비디오 및 다중 이미지 처리 기능을 추가했으며 복잡한 시나리오에서 다국어 기능 및 OCR 기능을 크게 발전시켜 모델의 실용성과 일반화 기능을 더욱 향상 시켰습니다.

이번에 오픈 소스 OVIS2 시리즈에는 1B, 2B, 4B, 8B, 16B 및 34B의 6 가지 버전이 포함되며 각 버전은 동일한 크기 SOTA (ART) 레벨에 도달합니다. 그중에서도 OVIS2-34B는 권위있는 평가 목록 OpenCompass에서 특히 잘 수행되었습니다. 멀티 모달 일반 기능 목록에서 OVIS2-34B는 모든 오픈 소스 모델에서 2 위를 차지하여 매개 변수 크기의 절반 미만으로 많은 70B 오픈 소스 플래그십 모델을 능가합니다. 멀티 모드 수학적 추론 목록에서 OVIS2-34B는 먼저 순위를 매기고 다른 크기 버전도 우수한 추론 기술을 보여줍니다. 이러한 성과는 OVIS 아키텍처의 효과를 확인할뿐만 아니라 멀티 모달 대형 모델의 개발을 촉진하는 데있어 오픈 소스 커뮤니티의 큰 잠재력을 보여줍니다.

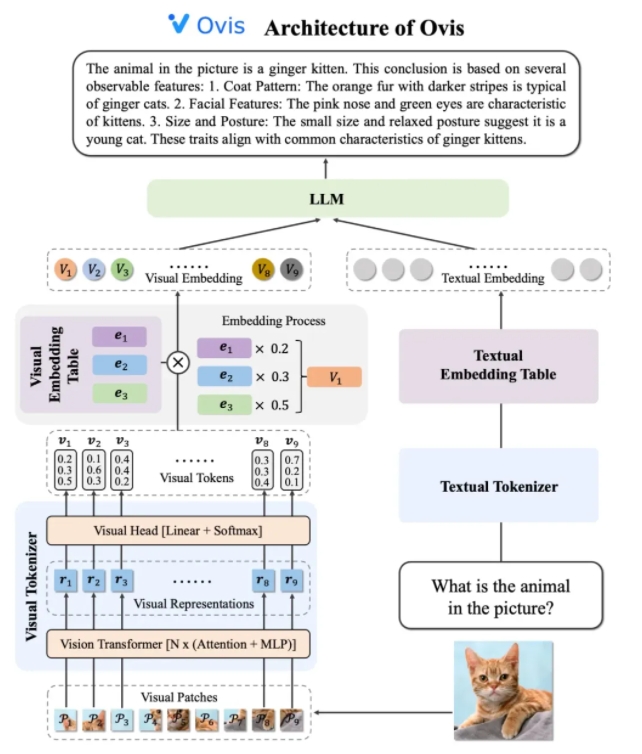

OVIS2의 아키텍처 설계는 모달 사이의 임베딩 전략의 차이의 한계를 영리하게 해결합니다. 시각적 토큰 화기, 시각적 임베딩 테이블 및 LLM (큰 언어 모델)의 세 가지 핵심 구성 요소로 구성됩니다. Visual Tokenizer는 입력 이미지를 여러 이미지 블록으로 나누고 시각적 변압기를 사용하여 기능을 추출하며 시각적 헤드 레이어를 통해 "시각적 단어"와 기능을 일치시켜 확률 론적 시각적 토큰을 생성합니다. 시각적 임베딩 테이블은 각 시각적 단어에 대응하는 임베딩 벡터를 저장하는 반면, LLM은 처리를 위해 시각적 임베딩 벡터와 텍스트 포함 벡터를 스플라이킹하고 마지막으로 텍스트 출력을 생성하여 멀티 모달 작업을 완료합니다.

교육 전략 측면에서 OVIS2는 4 단계 교육 방법을 채택하여 다중 모드 이해 능력을 완전히 자극합니다. 첫 번째 단계는 대부분의 LLM 및 VIT (Visual Transformer) 매개 변수를 동결하여 비전 모듈 교육에 중점을두고, 전환에 대한 시각적 기능을 배우는 데 중점을 둡니다. 두 번째 단계는 시각적 모듈의 기능 추출 기능을 더욱 향상시키고 고해상도 이미지 이해, 다국어 및 OCR 기능을 향상시킵니다. 세 번째 단계는 대화 형태의 시각적 캡션 데이터를 통해 LLM과 시각적 임베딩의 대화 형식을 대화 형태로 정렬합니다. 네 번째 단계는 여러 모드에서 사용자 지침 및 출력 품질을 따르는 모델의 능력을 더욱 향상시키기 위해 멀티 모드 교육 교육 및 선호도 학습을 수행하는 것입니다.

비디오 이해 기능을 향상시키기 위해 OVIS2는 혁신적인 키 프레임 선택 알고리즘을 개발했습니다. 알고리즘은 프레임과 텍스트 간의 상관 관계, 프레임 사이의 조합 다양성과 프레임 시퀀스를 기반으로 가장 유용한 비디오 프레임을 선택합니다. 고차원 조건부 유사성 계산, 결정 포인트 프로세스 (DPP) 및 MDP (Markov 의사 결정 프로세스)를 통해 알고리즘은 제한된 시각적 컨텍스트에서 키 프레임을 효율적으로 선택하여 비디오 이해력의 성능을 크게 향상시킬 수 있습니다.

OVIS2 시리즈 모델은 특히 OpenCompass MultimoDal 평가 목록에서 잘 수행되었습니다. 다양한 크기의 모델은 여러 벤치 마크에서 SOTA 결과를 달성했습니다. 예를 들어, OVIS2-34B는 각각 멀티 모달 일반 기능 및 수학적 추론 목록에서 2 위와 1 위를 차지하여 강력한 성능을 보여줍니다. 또한 OVIS2는 비디오 이해 목록에서 주요 결과를 달성하여 멀티 모달 작업의 장점을 더욱 입증했습니다.

알리바바의 국제화 팀은 오픈 소스가 AI 기술의 진보를 촉진하는 데 중요한 힘이라고 말했다. OVIS2의 연구 결과를 공개적으로 공유 함으로써이 팀은 글로벌 개발자와 함께 멀티 모달 대형 모델의 최첨단을 탐색하고보다 혁신적인 응용 프로그램을 고무시키기를 기대합니다. 현재 OVIS2의 코드는 GitHub에 공개되었으며 Hugging Face 및 ModelScope 플랫폼에서 모델을 얻을 수 있으며 온라인 데모가 사용자 경험을 위해 제공됩니다. 관련 연구 논문은 또한 개발자와 연구원이 참조하기 위해 ARXIV에 출판되었습니다.

코드 : https://github.com/aidc-ai/ovis

모델 (huggingface) : https://huggingface.co/aidc-ai/ovis2-34b

모델 : https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

데모 : https://huggingface.co/spaces/aidc-ai/ovis2-16b

arxiv : https : //arxiv.org/abs/2405.20797