Le 21 février 2025, l'équipe d'internationalisation d'Alibaba a officiellement annoncé l'open source de sa dernière série OVIS2 de modèle de grande langue multimodal. Ce mouvement majeur marque la nouvelle percée d'Alibaba dans le domaine de l'intelligence artificielle, et offre également aux développeurs mondiaux des outils techniques puissants pour promouvoir le développement et l'application de grands modèles multimodaux.

OVIS2 est la dernière version du modèle de série OVIS de l'équipe internationale d'Alibaba. Par rapport à la version 1.6 de la préface, OVIS2 a considérablement optimisé la construction de données et les méthodes de formation. Il améliore non seulement la densité des capacités des modèles à petite échelle, mais améliore également considérablement la chaîne de capacités de raisonnement de pensée (COT) grâce à un apprentissage de réglage fin et de préférence. De plus, OVIS2 a ajouté des fonctions de traitement vidéo et multi-images, et a fait des progrès significatifs dans les capacités multilingues et les capacités OCR dans des scénarios complexes, améliorant davantage les capacités de praticité et de généralisation du modèle.

La série OVIS2 open source cette fois comprend six versions: 1b, 2b, 4b, 8b, 16b et 34b, chaque version atteint le même niveau SOTA (ultime de l'art). Parmi eux, OVIS2-34B a particulièrement bien fonctionné sur la liste d'évaluation faisant autorité OpenCompass. Sur la liste des capacités générales multimodales, OVIS2-34B se classe deuxième dans tous les modèles open source, dépassant de nombreux modèles phares open source 70B avec moins de la moitié de la taille des paramètres. Sur la liste des raisons mathématiques multimodales, les classements OVIS2-34B en premier, et d'autres versions de taille présentent également d'excellentes compétences de raisonnement. Ces réalisations vérifient non seulement l'efficacité de l'architecture OVIS, mais démontrent également l'énorme potentiel de la communauté open source dans la promotion du développement de grands modèles multimodaux.

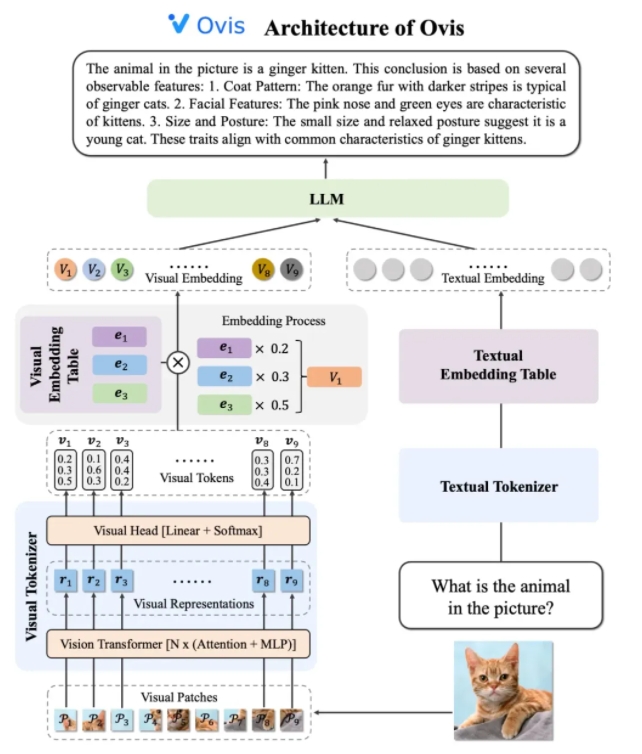

La conception d'architecture d'OVIS2 résout intelligemment les limites des différences dans les stratégies d'intégration entre les modaux. Il se compose de trois composants centraux: tokenizer visuel, table d'intégration visuelle et LLM (modèle grand langage). Le jeton visuel divise l'image d'entrée en plusieurs blocs d'image, utilise le transformateur visuel pour extraire les fonctionnalités et correspond aux fonctionnalités de "mots visuels" à travers la couche de tête visuelle pour générer un jeton visuel probabiliste. La table d'intégration visuelle stocke les vecteurs d'incorporation correspondant à chaque mot visuel, tandis que LLM épisser le vecteur d'intégration visuelle et le vecteur d'intégration de texte pour le traitement, et génère enfin de sortie de texte pour terminer la tâche multimodale.

En termes de stratégies de formation, OVIS2 adopte une méthode de formation en quatre étapes pour stimuler pleinement sa capacité de compréhension multimodale. La première étape gèle la plupart des paramètres LLM et VIT (transformateur visuel), en se concentrant sur la formation des modules de vision, en apprenant les caractéristiques visuelles des transformations d'intégration. La deuxième étape améliore encore les capacités d'extraction des caractéristiques du module visuel et améliore la compréhension de l'image haute résolution, les capacités multilingues et OCR. La troisième étape aligne le format de dialogue de l'incorporation visuelle avec LLM à travers des données de légende visuelle sous forme de dialogue. La quatrième étape consiste à effectuer une formation à l'enseignement multimodal et l'apprentissage des préférences pour améliorer davantage la capacité du modèle à suivre les instructions des utilisateurs et la qualité de sortie sous plusieurs modes.

Pour améliorer les capacités de compréhension vidéo, OVIS2 a développé un algorithme de sélection innovant de l'image clé. L'algorithme sélectionne les trames vidéo les plus utiles en fonction de la corrélation entre les cadres et le texte, la diversité combinée entre les trames et la séquence des cadres. Grâce à des calculs de similitude conditionnelle à haute dimension, au processus de point de détermination (DPP) et au processus de prise de décision de Markov (MDP), l'algorithme peut sélectionner efficacement les images clés dans un contexte visuel limité, améliorant ainsi considérablement les performances de la compréhension vidéo.

Le modèle de la série OVIS2 a particulièrement bien fonctionné sur la liste d'évaluation multimodale d'Opencompass. Des modèles de différentes tailles ont obtenu des résultats SOTA sur plusieurs repères. Par exemple, OVIS2-34B s'est classé deuxième et premier dans la liste des capacités générales multimodales et du raisonnement mathématique, respectivement, montrant ses performances puissantes. De plus, OVIS2 a également obtenu des résultats de premier plan dans la liste de compréhension vidéo, prouvant en outre ses avantages dans les tâches multimodales.

L'équipe d'internationalisation d'Alibaba a déclaré que l'open source est une force clé dans la promotion de la progression de la technologie de l'IA. En partageant publiquement les résultats de la recherche d'OVIS2, l'équipe a hâte d'explorer la pointe de grands modèles multimodaux avec des développeurs mondiaux et d'inspirer des applications plus innovantes. Actuellement, le code d'OVIS2 a été ouvert à GitHub, et le modèle peut être obtenu sur les plates-formes de face et de modèles étreintes, et des démos en ligne sont fournies pour l'expérience utilisateur. Des articles de recherche connexes ont également été publiés sur ArXIV pour référence par les développeurs et les chercheurs.

Code: https://github.com/aidc-ai/ovis

Modèle (HuggingFace): https://huggingface.co/aidc-ai/ovis2-34b

Modèles: https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

Demo: https://huggingface.co/spaces/aidc-ai/ovis2-16b

arXiv: https: //arxiv.org/abs/2405.20797