Pada 21 Februari 2025, tim internasionalisasi Alibaba secara resmi mengumumkan open source dari seri Model Bahasa Multimodal Bahasa OVIS2 terbaru. Langkah utama ini menandai terobosan lebih lanjut Alibaba di bidang kecerdasan buatan, dan juga memberi pengembang global alat teknis yang kuat untuk mempromosikan pengembangan dan penerapan model besar multimoda.

OVIS2 adalah versi terbaru dari model Seri OVIS dari tim internasional Alibaba. Dibandingkan dengan versi Kata Pengantar 1.6, OVIS2 telah secara signifikan mengoptimalkan metode konstruksi dan pelatihan data. Ini tidak hanya meningkatkan kepadatan kemampuan model skala kecil, tetapi juga sangat meningkatkan kemampuan penalaran rantai (COT) melalui penyempurnaan instruksi dan pembelajaran preferensi. Selain itu, OVIS2 telah menambahkan fungsi pemrosesan video dan multi-gambar, dan telah membuat kemajuan yang signifikan dalam kemampuan multibahasa dan kemampuan OCR dalam skenario yang kompleks, lebih lanjut meningkatkan kemampuan kepraktisan dan generalisasi model.

Seri Open Source OVIS2 kali ini mencakup enam versi: 1b, 2b, 4b, 8b, 16b dan 34b, setiap versi mencapai tingkat ukuran sota (canggih) yang sama. Di antara mereka, OVIS2-34B berkinerja sangat baik pada daftar evaluasi otoritatif OpenCompass. Pada daftar kemampuan umum multimodal, OVIS2-34B menempati urutan kedua di semua model open source, melampaui banyak model flagship open source 70B dengan kurang dari setengah ukuran parameter. Pada daftar penalaran matematika multimodal, OVIS2-34B peringkat pertama, dan versi ukuran lainnya juga menunjukkan keterampilan penalaran yang sangat baik. Prestasi ini tidak hanya memverifikasi efektivitas arsitektur OVIS, tetapi juga menunjukkan potensi besar dari komunitas open source dalam mempromosikan pengembangan model besar multimoda.

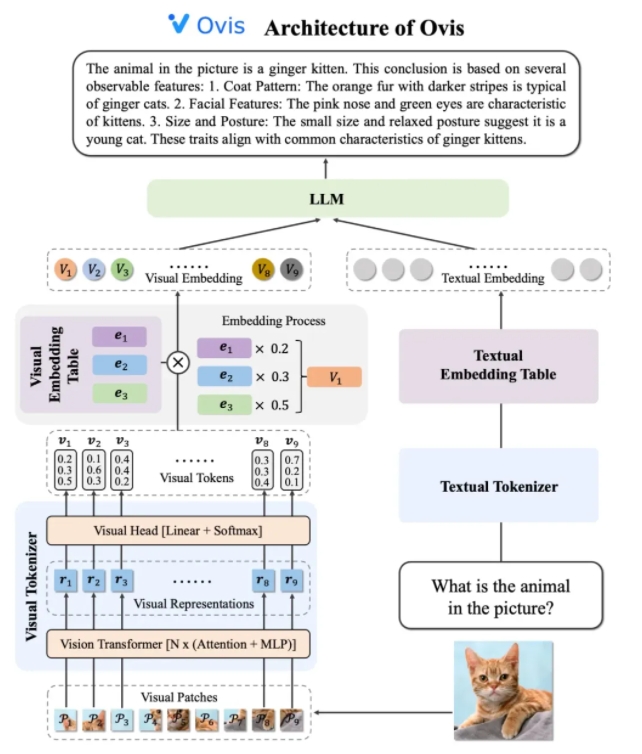

Desain arsitektur OVIS2 secara cerdik memecahkan keterbatasan perbedaan dalam strategi menanamkan antara modal. Ini terdiri dari tiga komponen inti: tokenizer visual, tabel embedding visual dan LLM (model bahasa besar). Tokenizer visual membagi gambar input menjadi beberapa blok gambar, menggunakan transformator visual untuk mengekstrak fitur, dan mencocokkan fitur dengan "kata -kata visual" melalui lapisan kepala visual untuk menghasilkan token visual probabilistik. Tabel embedding visual menyimpan vektor embedding yang sesuai dengan setiap kata visual, sementara LLM menyambungkan vektor embedding visual dan vektor embedding teks untuk diproses, dan akhirnya menghasilkan output teks untuk menyelesaikan tugas multimoda.

Dalam hal strategi pelatihan, OVIS2 mengadopsi metode pelatihan empat tahap untuk sepenuhnya merangsang kemampuan pemahaman multimodalnya. Tahap pertama membekukan sebagian besar parameter LLM dan VIT (transformator visual), dengan fokus pada modul visi pelatihan, mempelajari fitur visual untuk menanamkan transformasi. Tahap kedua lebih lanjut meningkatkan kemampuan ekstraksi fitur dari modul visual dan meningkatkan pemahaman gambar resolusi tinggi, kemampuan multibahasa dan OCR. Tahap ketiga menyelaraskan format dialog dari penyematan visual dengan LLM melalui data keterangan visual dalam bentuk dialog. Tahap keempat adalah melakukan pelatihan instruksi multimodal dan pembelajaran preferensi untuk lebih meningkatkan kemampuan model untuk mengikuti instruksi pengguna dan kualitas output di bawah beberapa mode.

Untuk meningkatkan kemampuan pemahaman video, OVIS2 telah mengembangkan algoritma pemilihan keyframe yang inovatif. Algoritma memilih frame video yang paling berguna berdasarkan korelasi antara bingkai dan teks, keragaman kombinasi antara bingkai dan urutan bingkai. Melalui perhitungan kesamaan bersyarat dimensi tinggi, proses titik determinan (DPP), dan Markov Proses Making-Making (MDP), algoritma dapat secara efisien memilih keyframe dalam konteks visual yang terbatas, sehingga secara signifikan meningkatkan kinerja pemahaman video.

Model seri OVIS2 telah berkinerja sangat baik pada daftar evaluasi multimodal opencompass. Model berbagai ukuran telah mencapai hasil SOTA pada beberapa tolok ukur. Sebagai contoh, OVIS2-34B peringkat kedua dan pertama dalam Daftar Kemampuan Umum Multimodal dan Daftar Penalaran Matematika, masing-masing, menunjukkan kinerja yang kuat. Selain itu, OVIS2 juga mencapai hasil utama dalam daftar pemahaman video, lebih lanjut membuktikan keunggulannya dalam tugas multimodal.

Tim internasionalisasi Alibaba mengatakan bahwa open source adalah kekuatan utama dalam mempromosikan kemajuan teknologi AI. Dengan berbagi hasil penelitian OVIS2 secara publik, tim berharap untuk mengeksplorasi mutakhir model besar multimoda dengan pengembang global dan menginspirasi aplikasi yang lebih inovatif. Saat ini, kode OVIS2 telah bersumber terbuka untuk GitHub, dan model dapat diperoleh pada platform pemeluk tangan dan model, dan demo online disediakan untuk pengalaman pengguna. Makalah penelitian terkait juga telah diterbitkan di ARXIV untuk referensi oleh pengembang dan peneliti.

Kode: https://github.com/aidc-ai/ovis

Model (HuggingFace): https://huggingface.co/aidc-ai/ovis2-34b

Model: https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

Demo: https://huggingface.co/spaces/aidc-ai/ovis2-16b

arxiv: https: //arxiv.org/abs/2405.20797