Em 21 de fevereiro de 2025, a equipe de internacionalização da Alibaba anunciou oficialmente o código aberto de sua mais recente série multimodal de modelo OVIS2 de grande idioma. Esse grande movimento marca a avanço adicional do Alibaba no campo da inteligência artificial e também fornece aos desenvolvedores globais poderosos ferramentas técnicas para promover o desenvolvimento e a aplicação de grandes modelos multimodais.

O OVIS2 é a versão mais recente do modelo da série Ovis da equipe internacional do Alibaba. Comparado com o prefácio versão 1.6, o OVIS2 otimizou significativamente os métodos de construção e treinamento de dados. Ele não apenas melhora a densidade de capacidade dos modelos de pequena escala, mas também aprimora muito a cadeia de recursos de raciocínio de pensamento (COT) por meio de instruções de ajuste fino e aprendizado de preferência. Além disso, o OVIS2 adicionou funções de processamento de vídeo e várias imagens e fez progressos significativos nos recursos multilíngues e nos recursos de OCR em cenários complexos, melhorando ainda mais os recursos de praticidade e generalização do modelo.

A série Open OVIS2 desta vez inclui seis versões: 1b, 2b, 4b, 8b, 16b e 34b, cada versão atinge o mesmo tamanho SOTA (estado da arte). Entre eles, o OVIS2-34B teve um desempenho particularmente bom na lista de avaliação autoritativa OpenCompass. Na lista de capacidade geral multimodal, o OVIS2-34B ocupa o segundo lugar em todos os modelos de código aberto, superando muitos modelos de 70b de código aberto com menos da metade do tamanho do parâmetro. Na lista de raciocínio matemático multimodal, o OVIS2-34B classifica primeiro e outras versões de tamanho também mostram excelentes habilidades de raciocínio. Essas conquistas não apenas verificam a eficácia da arquitetura OVIS, mas também demonstram o enorme potencial da comunidade de código aberto na promoção do desenvolvimento de grandes modelos multimodais.

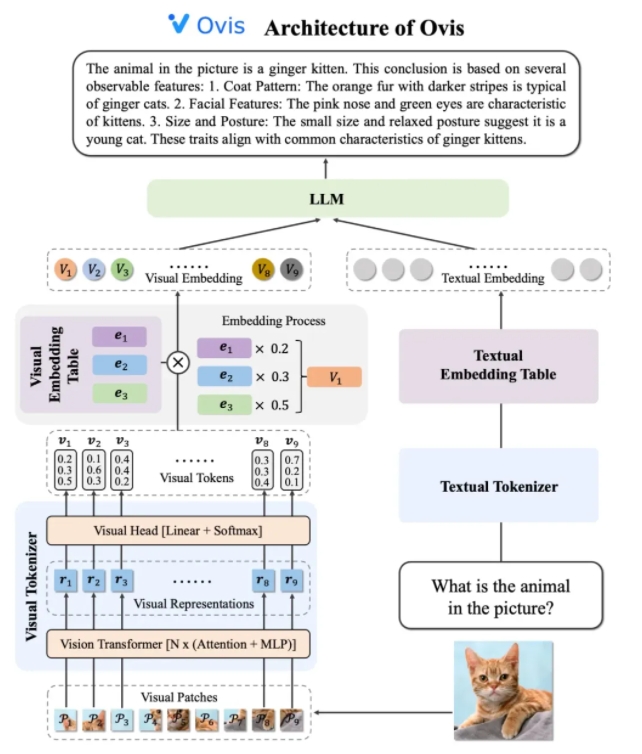

O design da arquitetura do OVIS2 resolve inteligentemente as limitações das diferenças na incorporação de estratégias entre os modais. Consiste em três componentes principais: Tokenizer visual, tabela de incorporação visual e LLM (modelo de idioma grande). O Tokenizer visual divide a imagem de entrada em vários blocos de imagem, usa o transformador visual para extrair recursos e corresponde aos recursos de "palavras visuais" através da camada visual da cabeça para gerar um token visual probabilístico. A tabela de incorporação visual armazena os vetores de incorporação correspondentes a cada palavra visual, enquanto o LLM lança o vetor de incorporação visual e o vetor de incorporação de texto para processamento e, finalmente, gera saída de texto para concluir a tarefa multimodal.

Em termos de estratégias de treinamento, o OVIS2 adota um método de treinamento em quatro estágios para estimular completamente sua capacidade de compreensão multimodal. O primeiro estágio congela a maioria dos parâmetros LLM e VIT (Visual Transformer), com foco nos módulos de visão de treinamento, aprendendo recursos visuais para incorporar transformações. O segundo estágio melhora ainda mais os recursos de extração de recursos do módulo visual e aprimora os recursos de imagem de alta resolução, multilíngues e OCR. O terceiro estágio alinha o formato de diálogo de incorporação visual com o LLM através dos dados da legenda visual na forma de diálogo. O quarto estágio é realizar treinamento multimodal de instrução e aprendizado de preferência para melhorar ainda mais a capacidade do modelo de seguir as instruções do usuário e a qualidade da saída em vários modos.

Para melhorar os recursos de compreensão de vídeo, o OVIS2 desenvolveu um algoritmo inovador de seleção de quadros -chave. O algoritmo seleciona os quadros de vídeo mais úteis com base na correlação entre quadros e texto, a diversidade combinada entre os quadros e a sequência de quadros. Através de cálculos de similaridade condicional de alta dimensão, processo de ponto determinante (DPP) e processo de tomada de decisão de Markov (MDP), o algoritmo pode selecionar com eficiência os quadros-chave em um contexto visual limitado, melhorando significativamente o desempenho da compreensão de vídeo.

O modelo da série OVIS2 teve um desempenho particularmente bem na lista de avaliação multimodal OpenCompass. Modelos de tamanhos diferentes alcançaram os resultados do SOTA em vários benchmarks. Por exemplo, o OVIS2-34B ficou em segundo e primeiro na lista de capacidade geral multimodal e raciocínio matemático, respectivamente, mostrando seu desempenho poderoso. Além disso, o OVIS2 também alcançou os principais resultados na lista de entendimento de vídeo, provando ainda mais suas vantagens em tarefas multimodais.

A equipe de internacionalização do Alibaba disse que o código aberto é uma força -chave para promover o progresso da tecnologia de IA. Ao compartilhar publicamente os resultados da pesquisa da OVIS2, a equipe espera explorar a ponta de grandes modelos multimodais com desenvolvedores globais e inspirar aplicativos mais inovadores. Atualmente, o código do OVIS2 foi de origem aberta para o GitHub, e o modelo pode ser obtido nas plataformas Hugging Face e ModelCope, e as demos on -line são fornecidas para a experiência do usuário. Documentos de pesquisa relacionados também foram publicados no ARXIV para referência por desenvolvedores e pesquisadores.

Código: https://github.com/aidc-ai/ovis

Modelo (HuggingFace): https://huggingface.co/aidc-ai/ovis2-34b

Modelos: https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

Demo: https://huggingface.co/spaces/aidc-ai/ovis2-16b

Arxiv: https: //arxiv.org/abs/2405.20797