El 21 de febrero de 2025, el equipo de internacionalización de Alibaba anunció oficialmente el código abierto de su último modelo de lenguaje multimodal OVIS2. Este movimiento principal marca el gran avance de Alibaba en el campo de la inteligencia artificial, y también proporciona a los desarrolladores globales herramientas técnicas potentes para promover el desarrollo y la aplicación de modelos grandes multimodales.

OVIS2 es la última versión del modelo de la serie OVIS del equipo internacional de Alibaba. No solo mejora la densidad de capacidad de los modelos a pequeña escala, sino que también mejora en gran medida la cadena de pensamiento de las capacidades de razonamiento a través de la instrucción ajustado y el aprendizaje de preferencias. Además, OVIS2 ha agregado funciones de procesamiento de video y múltiples imágenes, y ha hecho un progreso significativo en las capacidades multilingües y las capacidades de OCR en escenarios complejos, mejorando aún más las capacidades de practicidad y generalización del modelo.

La serie OVIS2 de código abierto esta vez incluye seis versiones: 1b, 2b, 4b, 8b, 16b y 34b, cada versión alcanza el mismo nivel de SOTA (estado del arte). Entre ellos, OVIS2-34B se desempeñó particularmente bien en la lista de evaluación autorizada OpenCompass. En la lista multimodal de capacidad general, OVIS2-34B ocupa el segundo lugar en todos los modelos de código abierto, superando muchos modelos insignia de código abierto 70B con menos de la mitad del tamaño del parámetro. En la lista de razonamiento matemático multimodal, OVIS2-34B ocupa el primer lugar, y otras versiones de tamaño también muestran excelentes habilidades de razonamiento. Estos logros no solo verifican la efectividad de la arquitectura de OVIS, sino que también demuestran el enorme potencial de la comunidad de código abierto para promover el desarrollo de modelos grandes multimodales.

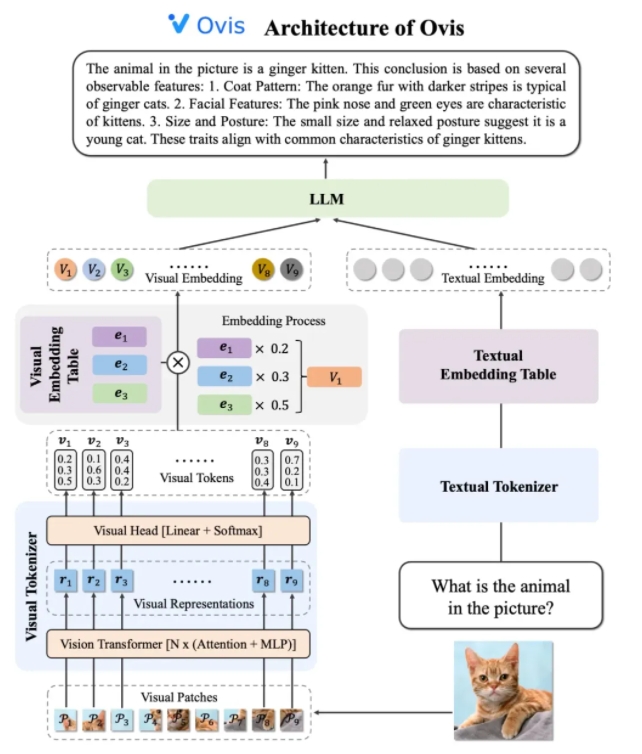

El diseño de arquitectura de OVIS2 resuelve hábilmente las limitaciones de las diferencias en la incrustación de estrategias entre modales. Consiste en tres componentes centrales: tokenizador visual, tabla de incrustación visual y LLM (modelo de lenguaje grande). El tokenizador visual divide la imagen de entrada en múltiples bloques de imágenes, utiliza el transformador visual para extraer características y coincide con las características con "palabras visuales" a través de la capa visual de la cabeza para generar un token visual probabilístico. La tabla de incrustación visual almacena los vectores de incrustación correspondientes a cada palabra visual, mientras que LLM empaliza el vector de incrustación visual y el vector de incrustación de texto para el procesamiento, y finalmente genera salida de texto para completar la tarea multimodal.

En términos de estrategias de entrenamiento, OVIS2 adopta un método de entrenamiento de cuatro etapas para estimular completamente su capacidad de comprensión multimodal. La primera etapa congela la mayoría de los parámetros LLM y VIT (transformador visual), centrándose en los módulos de visión de entrenamiento, aprendiendo características visuales para las transformaciones de incrustación. La segunda etapa mejora aún más las capacidades de extracción de características del módulo visual y mejora las capacidades de comprensión de imágenes de alta resolución, multilingües y OCR. La tercera etapa alinea el formato de diálogo de la incrustación visual con LLM a través de datos de subtítulos visuales en forma de diálogo. La cuarta etapa es llevar a cabo capacitación en instrucción multimodal y aprendizaje de preferencia para mejorar aún más la capacidad del modelo para seguir las instrucciones del usuario y la calidad de la salida en múltiples modos.

Para mejorar las capacidades de comprensión de video, OVIS2 ha desarrollado un algoritmo innovador de selección de cuadros. El algoritmo selecciona los cuadros de video más útiles basados en la correlación entre los marcos y el texto, la diversidad de combinación entre los cuadros y la secuencia de marcos. A través de los cálculos de similitud condicional de alta dimensión, el proceso de punto determinante (DPP) y el proceso de toma de decisiones de Markov (MDP), el algoritmo puede seleccionar eficientemente los cuadros clave en un contexto visual limitado, mejorando significativamente el rendimiento de la comprensión de video.

El modelo de la serie OVIS2 se ha desempeñado particularmente bien en la lista de evaluación multimodal OpenCompass. Los modelos de diferentes tamaños han logrado resultados de SOTA en múltiples puntos de referencia. Por ejemplo, OVIS2-34B ocupó el segundo y primer lugar en la lista de capacidades generales multimodales y de razonamiento matemático, respectivamente, que muestra su poderoso rendimiento. Además, OVIS2 también logró los principales resultados en la lista de comprensión de video, lo que demuestra aún más sus ventajas en tareas multimodales.

El equipo de internacionalización de Alibaba dijo que el código abierto es una fuerza clave para promover el progreso de la tecnología de IA. Al compartir públicamente los resultados de la investigación de OVIS2, el equipo espera explorar la vanguardia de modelos grandes multimodales con desarrolladores globales e inspirar aplicaciones más innovadoras. Actualmente, el código de OVIS2 se ha abierto a GitHub, y el modelo se puede obtener en las plataformas de abrazaderas y modelos de abrazos, y se proporcionan demostraciones en línea para la experiencia del usuario. Los trabajos de investigación relacionados también se han publicado en ARXIV como referencia por desarrolladores e investigadores.

Código: https://github.com/aidc-ai/ovis

Modelo (Huggingface): https://huggingface.co/aidc-ai/ovis2-34b

Modelos: https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

Demostración: https://huggingface.co/spaces/aidc-ai/vis2-16b

arxiv: https: //arxiv.org/abs/2405.20797