2025年2月21日、アリババの国際化チームは、最新のマルチモーダル大手言語モデルOvis2シリーズのオープンソースを公式に発表しました。この主要な動きは、人工知能の分野でのアリババのさらなるブレークスルーをマークし、マルチモーダル大規模モデルの開発と応用を促進するための強力な技術ツールをグローバルな開発者に提供します。

Ovis2は、Alibabaの国際チームのOvisシリーズモデルの最新バージョンです。序文バージョン1.6と比較して、OVIS2はデータ構築およびトレーニング方法を大幅に最適化しました。小規模モデルの能力密度を向上させるだけでなく、指導の微調整と好みの学習を通じて、思考の連鎖(COT)推論能力を大幅に向上させます。さらに、OVIS2はビデオおよびマルチイメージ処理機能を追加し、複雑なシナリオで多言語機能とOCR機能に大きな進歩を遂げ、モデルの実用性と一般化機能をさらに改善しました。

今回のオープンソースのOVIS2シリーズには、1B、2B、4B、8B、16B、34Bの6つのバージョンが含まれています。各バージョンは同じサイズのSOTA(最先端)レベルに達します。その中で、OVIS2-34Bは、権威ある評価リストのOpenCompassで特にうまく機能しました。マルチモーダルの一般的な機能リストでは、OVIS2-34Bはすべてのオープンソースモデルで2位にランクされており、パラメーターサイズの半分以下の70Bのオープンソースフラッグシップモデルを上回ります。マルチモーダル数学的推論リストでは、Ovis2-34Bが最初にランクされ、他のサイズのバージョンも優れた推論スキルを示しています。これらの成果は、OVISアーキテクチャの有効性を検証するだけでなく、マルチモーダル大規模モデルの開発を促進するオープンソースコミュニティの大きな可能性を示しています。

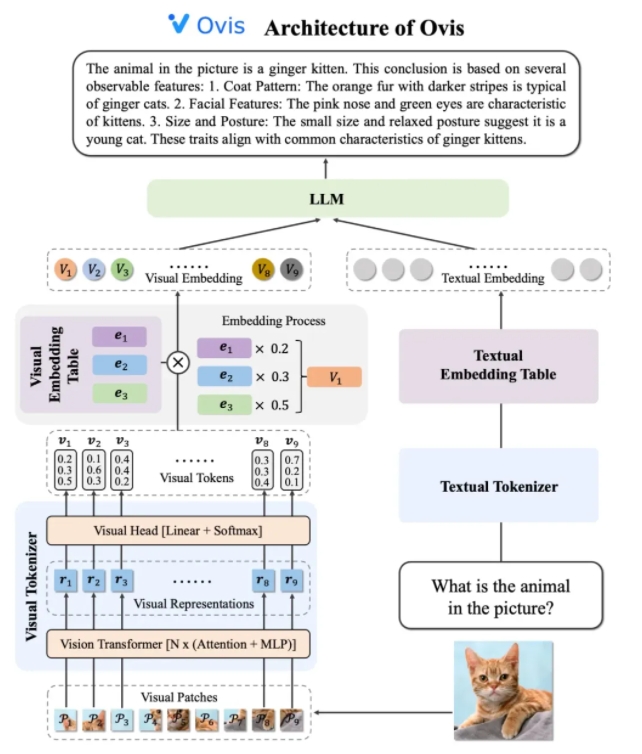

ovis2のアーキテクチャデザインは、モーダル間の戦略を埋め込むことの違いの制限を巧みに解決します。 3つのコアコンポーネントで構成されています:視覚トークネザー、視覚埋め込みテーブル、LLM(大規模な言語モデル)。視覚トークネイザーは、入力画像を複数の画像ブロックに分割し、視覚的な変圧器を使用して特徴を抽出し、視覚的なヘッドレイヤーを介して「視覚的単語」と一致して、確率的な視覚トークンを生成します。視覚埋め込みテーブルには、各視覚的単語に対応する埋め込みベクターが保存され、LLMは視覚埋め込みベクターと処理用のテキスト埋め込みベクトルをスプライブし、最後にテキスト出力を生成してマルチモーダルタスクを完了します。

トレーニング戦略の観点から、OVIS2はマルチモーダル理解能力を完全に刺激するために4段階のトレーニング方法を採用しています。最初の段階では、ほとんどのLLMおよびVIT(視覚的な変圧器)パラメーターをフリーズし、トレーニングビジョンモジュールに焦点を当て、変換を埋め込むための視覚的特徴を学習します。第2段階は、視覚モジュールの特徴抽出機能をさらに改善し、高解像度の画像理解、多言語、OCR機能を強化します。第3段階では、ダイアログの形式で視覚的なキャプションデータを介してLLMを使用した視覚的な埋め込みのダイアログ形式を並べます。 4番目の段階は、複数のモードでユーザーの指示と出力品質に従うモデルの能力をさらに向上させるために、マルチモーダルの指導トレーニングと優先的学習を実行することです。

ビデオ理解機能を改善するために、Ovis2は革新的なキーフレーム選択アルゴリズムを開発しました。このアルゴリズムは、フレームとテキストの相関、フレームとフレームのシーケンスの組み合わせの多様性に基づいて、最も有用なビデオフレームを選択します。高次元の条件付き類似性計算、決定要因ポイントプロセス(DPP)、およびマルコフの意思決定プロセス(MDP)を通じて、アルゴリズムは限られた視覚的コンテキストでキーフレームを効率的に選択でき、それによりビデオ理解のパフォーマンスを大幅に改善できます。

OVIS2シリーズモデルは、OpenCompassマルチモーダル評価リストで特にうまく機能しています。さまざまなサイズのモデルは、複数のベンチマークでSOTA結果を達成しています。たとえば、Ovis2-34Bは、それぞれマルチモーダルの一般的な能力と数学的推論リストで2位、1位にランクされ、その強力なパフォーマンスを示しています。さらに、OVIS2はビデオ理解リストでも主要な結果を達成し、マルチモーダルタスクの利点をさらに証明しました。

Alibabaの国際化チームは、オープンソースがAIテクノロジーの進歩を促進する重要な力であると述べました。 Ovis2の研究結果を公に共有することで、チームはグローバルな開発者との最先端のマルチモーダル大型モデルを探索し、より革新的なアプリケーションを刺激することを楽しみにしています。現在、Ovis2のコードはGithubに供給されており、モデルはハグの顔とモデルのプラットフォームで取得でき、オンラインデモがユーザーエクスペリエンスのために提供されています。関連する研究論文は、開発者と研究者による参照のためにARXIVにも掲載されています。

コード:https://github.com/aidc-ai/ovis

モデル(Huggingface):https://huggingface.co/aidc-ai/ovis2-34b

モデル:https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

デモ:https://huggingface.co/spaces/aidc-ai/ovis2-16b

arxiv:https://arxiv.org/abs/2405.20797