Am 21. Februar 2025 kündigte das Internationalisierungsteam von Alibaba offiziell die Open Source seiner neuesten multimodalen großsprachigen OVIS2 -Serie an. Dieser große Schritt markiert Alibabas weiteren Durchbruch im Bereich der künstlichen Intelligenz und bietet globalen Entwicklern leistungsstarke technische Instrumente, um die Entwicklung und Anwendung multimodaler großer Modelle zu fördern.

OVIS2 ist die neueste Version des OVIS -Serienmodells des internationalen Teams von Alibaba. Es verbessert nicht nur die Fähigkeitsdichte von kleinen Modellen, sondern verbessert auch die Denkkette (COT-) Argumentationsfunktionen durch Unterrichtsfeineinstimmungen und Präferenzlernen. Darüber hinaus hat OVIS2 Video- und Multi-Image-Verarbeitungsfunktionen hinzugefügt und in komplexen Szenarien erhebliche Fortschritte bei mehrsprachigen Funktionen und OCR-Funktionen erzielt, wodurch die praktischen und Generalisierungsfähigkeiten des Modells weiter verbessert werden.

Die Open Source OVIS2 -Serie enthält diesmal sechs Versionen: 1B, 2B, 4B, 8B, 16B und 34B. Jede Version erreicht die gleiche Größe SOTA (Stand der Kunst). Unter ihnen hat OVIS2-34B auf der maßgeblichen Bewertungsliste OpenCompass besonders gut gespielt. Auf der multimodalen allgemeinen Funktionsliste belegt OVIS2-34B in allen Open-Source-Modellen den zweiten Platz und übertrifft viele 70B Open-Source-Flaggschiff-Modelle mit weniger als der Hälfte der Parametergröße. Auf der multimodalen mathematischen Argumentationsliste stehen OVIS2-34B an erster Stelle und andere Versionen der Größen zeigen auch hervorragende Argumentationsfähigkeiten. Diese Erfolge überprüfen nicht nur die Wirksamkeit der OVIS -Architektur, sondern zeigen auch das enorme Potenzial der Open -Source -Community bei der Förderung der Entwicklung multimodaler großer Modelle.

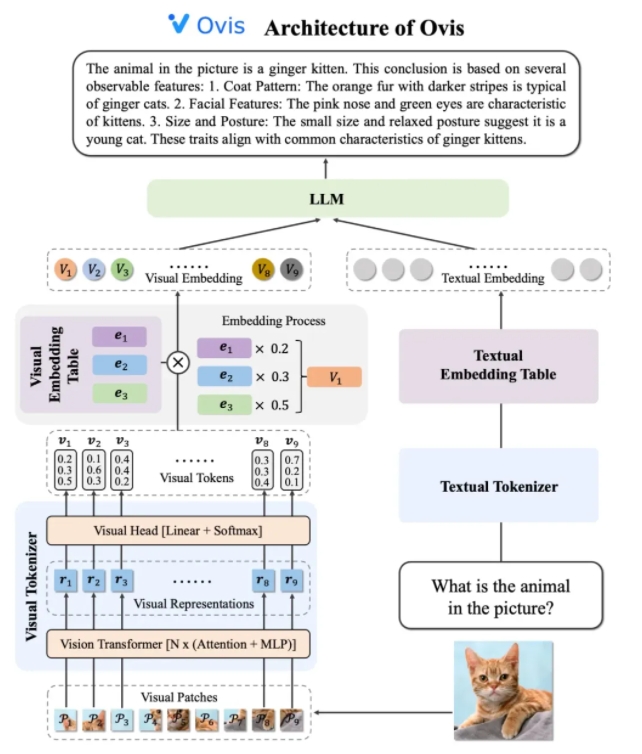

Das Architekturdesign von OVIS2 löst geschickt die Einschränkungen der Unterschiede in der Einbettungsstrategien zwischen Modalen. Es besteht aus drei Kernkomponenten: visueller Tokenizer, visuelle Einbettungstabelle und LLM (großes Sprachmodell). Der visuelle Tokenizer unterteilt das Eingabebild in mehrere Bildblöcke, verwendet den visuellen Transformator, um Merkmale zu extrahieren, und passt die Merkmale mit "visuellen Wörtern" über die visuelle Kopfschicht ab, um ein probabilistisches visuelles Token zu erzeugen. Die visuelle Einbettungstabelle speichert die Einbettungsvektoren, die jedem visuellen Wort entsprechen, während LLM den visuellen Einbettungsvektor und den Text -Einbettungsvektor zur Verarbeitung speichert und schließlich die Textausgabe erzeugt, um die multimodale Aufgabe abzuschließen.

In Bezug auf Schulungsstrategien verfolgt OVIS2 eine vierstufige Trainingsmethode, um seine multimodale Verständnisfähigkeit vollständig zu stimulieren. Die erste Stufe friert die meisten LLM- und VIT -Parameter (visuellen Transformator) ein und konzentriert sich auf Trainingsvisionsmodule und lernte visuelle Merkmale in die Einbettung von Transformationen. Die zweite Stufe verbessert die Funktionen der Funktionextraktion des visuellen Moduls weiter und verbessert hochauflösende Bildverständnisse, mehrsprachige und OCR-Funktionen. Die dritte Stufe richtet das Dialogformat der visuellen Einbettung mit LLM durch visuelle Bildunterschriftendaten in Form des Dialogs aus. In der vierten Stufe besteht die Durchführung multimodaler Schulungsschulungen und Präferenzlernen durch, um die Fähigkeit des Modells weiter zu verbessern, Benutzeranweisungen und Ausgabequalität unter mehreren Modi zu befolgen.

Um das Videoverständnis zu verbessern, hat OVIS2 einen innovativen Keyframe -Auswahlalgorithmus entwickelt. Der Algorithmus wählt die nützlichsten Videorahmen basierend auf der Korrelation zwischen Frames und Text, der Kombinationsdiversität zwischen Frames und der Abfolge der Frames aus. Durch hochdimensionale konditionelle Ähnlichkeitsberechnungen, Determinant Point Process (DPP) und Markov-Entscheidungsprozess (MDP) kann der Algorithmus Keyframes in einem begrenzten visuellen Kontext effizient auswählen, wodurch die Leistung des Videoverständnisses signifikant verbessert wird.

Das Modell der OVIS2 -Serie hat sich besonders gut auf der OpenCompass -Multimodal -Evaluierungsliste entwickelt. Modelle verschiedener Größen haben SOTA -Ergebnisse bei mehreren Benchmarks erzielt. Zum Beispiel belegte OVIS2-34B den zweiten und ersten in der Liste der multimodalen allgemeinen Fähigkeiten bzw. mathematischen Argumentationsliste, was seine leistungsstarke Leistung zeigt. Darüber hinaus erzielte OVIS2 auch führende Ergebnisse in der Videoverständnisliste, was seine Vorteile bei multimodalen Aufgaben weiter nachweist.

Alibabas Internationalisierungsteam sagte, Open Source sei eine wichtige Kraft bei der Förderung des Fortschritts der AI -Technologie. Durch die öffentliche Teile von OVIS2s Forschungsergebnissen freut sich das Team darauf, die Spitzenreiter multimodaler großer Modelle mit globalen Entwicklern zu untersuchen und innovativere Anwendungen zu inspirieren. Derzeit wurde der Code von OVIS2 für GitHub offen gesammelt, und das Modell kann auf den umarmenden Gesichts- und Modelscope -Plattformen erhalten werden, und Online -Demos werden für Benutzererfahrungen bereitgestellt. Verwandte Forschungsarbeiten wurden auch in Arxiv als Referenz von Entwicklern und Forschern veröffentlicht.

Code: https://github.com/aidc-ai/ovis

Modell (Huggingface): https://huggingface.co/aidc-ai/ovis2-34b

Modelle: https://modelscope.cn/collections/ovis2-1e2840cb4f7d45

Demo: https://huggingface.co/spaces/aidc-ai/ovis2-16b

ARXIV: https: //arxiv.org/abs/2405.20797