DeepSeek недавно выпустила свою новую модель с открытым исходным кодом DeepSeek-Coder-V2, которая превосходит GPT-4-Turbo с точки зрения кода и математических возможностей, а также значительно улучшает многоязычную поддержку и длину обработки контекста. Он использует архитектуру Mix of Experts (MoE) и специально оптимизирован для генерации кода и возможностей математического рассуждения. Его производительность является одной из лучших в мире, и он предоставляет два варианта масштабирования параметров 236B и параметров 16B для удовлетворения различных потребностей приложений. Все коды, документы и модели имеют открытый исходный код и могут использоваться бесплатно в коммерческих целях без приложения.

Домашняя страница веб-мастера (ChinaZ.com) Новости от 18 июня: DeepSeek недавно объявила о выпуске модели с открытым исходным кодом под названием DeepSeek-Coder-V2, которая превосходит GPT-4-Turbo с точки зрения кода и математических возможностей и значительно расширена. многоязычная поддержка и длина обработки контекста. Основанный на структуре модели DeepSeek-V2, DeepSeek-Coder-V2 использует архитектуру Mix of Experts (MoE), специально разработанную для улучшения возможностей кода и математических рассуждений.

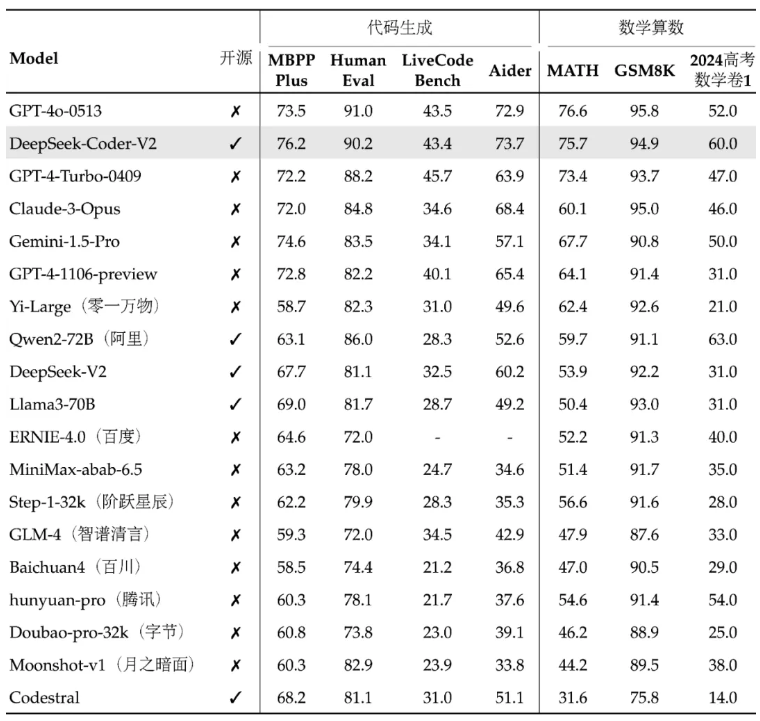

Производительность DeepSeek-Coder-V2 считается одной из лучших в мире, а его возможности генерации кода и математической арифметики особенно выдающиеся. Эта модель и связанные с ней коды и документы имеют открытый исходный код и доступны для бесплатного коммерческого использования без приложения. Модель доступна в двух размерах: параметры 236B и параметры 16B для удовлетворения различных потребностей приложений.

Что касается многоязычной поддержки, число языков программирования, которые может поддерживать DeepSeek-Coder-V2, было расширено с 86 до 338, что позволяет адаптироваться к более разнообразным потребностям разработки. В то же время поддерживаемая длина контекста увеличена с 16 КБ до 128 КБ, что позволяет обрабатывать более длинный входной контент. DeepSeek-Coder-V2 также предоставляет услуги API, поддерживает контекст 32 КБ, а цена такая же, как у DeepSeek-V2.

В стандартных тестах производительности DeepSeek-Coder-V2 превосходит некоторые модели с закрытым исходным кодом в генерации кода, дополнении кода, восстановлении кода и математических рассуждениях. Пользователи могут скачать различные версии модели DeepSeek-Coder-V2, включая базовую версию и версию инструкции, а также версии с разными масштабами параметров.

DeepSeek также предоставляет онлайн-платформу и ссылки на GitHub, а также технические отчеты, чтобы помочь пользователям лучше понять и использовать DeepSeek-Coder-V2. Выпуск этой модели не только предоставляет сообществу открытого исходного кода мощные возможности кодирования и математической обработки, но также помогает продвигать разработку и применение связанных технологий.

Адрес проекта: https://top.aibase.com/tool/deepseek-coder-v2

Онлайн-опыт: https://chat.deepseek.com/sign_in

Выпуск DeepSeek-Coder-V2 с открытым исходным кодом предоставляет разработчикам мощные инструменты и знаменует собой значительный прогресс в технологии больших моделей с открытым исходным кодом. Его бесплатное коммерческое использование и удобная онлайн-платформа будут способствовать дальнейшей популяризации и применению технологии искусственного интеллекта, и стоит с нетерпением ждать ее дальнейшего развития и применения.