DeepSeek baru-baru ini merilis model open source barunya DeepSeek-Coder-V2, yang melampaui GPT-4-Turbo dalam hal kode dan kemampuan matematika, serta secara signifikan meningkatkan dukungan multi-bahasa dan durasi pemrosesan konteks. Ini mengadopsi arsitektur Mix of Experts (MoE) dan secara khusus dioptimalkan untuk pembuatan kode dan kemampuan penalaran matematis. Kinerjanya termasuk yang terbaik di dunia, dan menyediakan dua opsi skala parameter 236B dan parameter 16B untuk memenuhi kebutuhan aplikasi yang berbeda. Semua kode, makalah, dan model bersifat open source dan dapat digunakan secara gratis secara komersial tanpa aplikasi.

Berita Beranda Webmaster (ChinaZ.com) pada 18 Juni: DeepSeek baru-baru ini mengumumkan peluncuran model sumber terbuka yang disebut DeepSeek-Coder-V2, yang melampaui GPT-4-Turbo dalam hal kode dan kemampuan matematika dukungan multi-bahasa dan durasi pemrosesan konteks. Berdasarkan struktur model DeepSeek-V2, DeepSeek-Coder-V2 mengadopsi arsitektur Mix of Experts (MoE) yang dirancang khusus untuk meningkatkan kemampuan kode dan penalaran matematis.

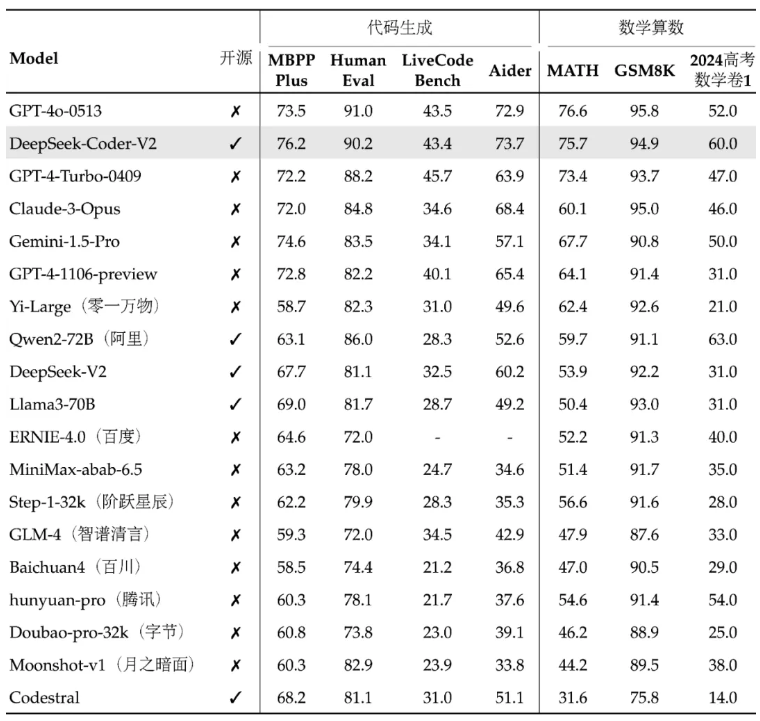

Performa DeepSeek-Coder-V2 termasuk yang terbaik di dunia, dan kemampuan pembuatan kode serta aritmatika matematisnya sangat luar biasa. Model ini dan kode serta makalah terkait semuanya bersifat open source dan tersedia untuk penggunaan komersial gratis tanpa aplikasi. Model ini tersedia dalam dua ukuran: parameter 236B dan parameter 16B untuk memenuhi kebutuhan aplikasi yang berbeda.

Dalam hal dukungan multi-bahasa, bahasa pemrograman yang dapat didukung DeepSeek-Coder-V2 telah diperluas dari 86 menjadi 338, beradaptasi dengan kebutuhan pengembangan yang lebih beragam. Pada saat yang sama, panjang konteks yang didukungnya diperluas dari 16K menjadi 128K, sehingga memungkinkannya menangani konten masukan yang lebih panjang. DeepSeek-Coder-V2 juga menyediakan layanan API, mendukung konteks 32K, dan harganya sama dengan DeepSeek-V2.

Dalam pengujian benchmark standar, DeepSeek-Coder-V2 mengungguli beberapa model sumber tertutup dalam pembuatan kode, penyelesaian kode, perbaikan kode, dan penalaran matematis. Pengguna dapat mengunduh berbagai versi model DeepSeek-Coder-V2, termasuk versi dasar dan versi instruksi, serta versi dengan skala parameter berbeda.

DeepSeek juga menyediakan platform pengalaman online dan tautan GitHub, serta laporan teknis, untuk memfasilitasi pengguna untuk lebih memahami dan menggunakan DeepSeek-Coder-V2. Peluncuran model ini tidak hanya menghadirkan kemampuan pemrosesan kode dan matematis yang kuat kepada komunitas open source, namun juga membantu mendorong pengembangan dan penerapan teknologi terkait.

Alamat proyek: https://top.aibase.com/tool/deepseek-coder-v2

Pengalaman online: https://chat.deepseek.com/sign_in

Rilis open source DeepSeek-Coder-V2 memberi pengembang alat canggih dan menandai kemajuan signifikan dalam teknologi model besar open source. Penggunaan komersial gratis dan platform pengalaman online yang nyaman akan semakin mendorong pemasyarakatan dan penerapan teknologi kecerdasan buatan, dan pengembangan dan penerapannya di masa depan patut dinantikan.