DeepSeek은 최근 코드 및 수학적 기능 측면에서 GPT-4-Turbo를 능가하고 다중 언어 지원 및 컨텍스트 처리 길이를 크게 향상시키는 새로운 오픈 소스 모델 DeepSeek-Coder-V2를 출시했습니다. MoE(Mix of Experts) 아키텍처를 채택하고 코드 생성 및 수학적 추론 기능에 특별히 최적화되어 있으며 성능은 세계 최고 수준이며 다양한 애플리케이션 요구 사항을 충족하기 위해 236B 매개변수와 16B 매개변수의 두 가지 확장 옵션을 제공합니다. 모든 코드, 논문 및 모델은 오픈 소스이며 애플리케이션 없이 상업적으로 무료로 사용할 수 있습니다.

6월 18일 웹마스터 홈(ChinaZ.com) 뉴스: DeepSeek은 최근 코드 및 수학적 기능 측면에서 GPT-4-Turbo를 능가하는 DeepSeek-Coder-V2라는 오픈 소스 모델의 출시를 발표했습니다. 다국어 지원 및 컨텍스트 처리 길이. DeepSeek-V2의 모델 구조를 기반으로 DeepSeek-Coder-V2는 코드 및 수학적 추론 기능을 향상시키기 위해 특별히 설계된 MoE(Mix of Experts) 아키텍처를 채택합니다.

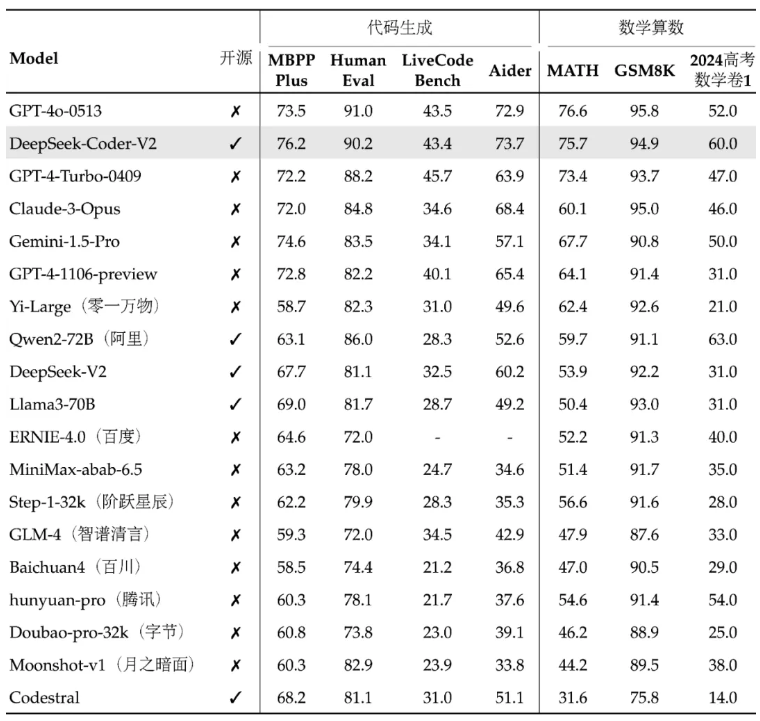

DeepSeek-Coder-V2의 성능은 세계 최고 수준이며, 코드 생성 및 수학 연산 기능이 특히 뛰어납니다. 이 모델과 관련 코드 및 논문은 모두 오픈 소스였으며 응용 프로그램 없이 무료로 상업적으로 사용할 수 있습니다. 이 모델은 다양한 응용 분야 요구 사항을 충족하기 위해 236B 매개변수와 16B 매개변수의 두 가지 크기로 제공됩니다.

다국어 지원 측면에서 DeepSeek-Coder-V2가 지원할 수 있는 프로그래밍 언어가 86개에서 338개로 확장되어 보다 다양한 개발 요구에 적응했습니다. 동시에 지원하는 컨텍스트 길이가 16K에서 128K로 확장되어 더 긴 입력 콘텐츠를 처리할 수 있습니다. DeepSeek-Coder-V2는 API 서비스도 제공하고 32K 컨텍스트를 지원하며 가격은 DeepSeek-V2와 동일합니다.

표준 벤치마크 테스트에서 DeepSeek-Coder-V2는 코드 생성, 코드 완성, 코드 복구 및 수학적 추론에서 일부 비공개 소스 모델보다 성능이 뛰어납니다. 사용자는 기본 버전과 지침 버전은 물론 다양한 매개변수 규모의 버전을 포함하여 DeepSeek-Coder-V2 모델의 다양한 버전을 다운로드할 수 있습니다.

DeepSeek은 또한 사용자가 DeepSeek-Coder-V2를 더 잘 이해하고 사용할 수 있도록 온라인 경험 플랫폼과 GitHub 링크, 기술 보고서를 제공합니다. 이 모델의 출시는 오픈 소스 커뮤니티에 강력한 코드 및 수학적 처리 기능을 제공할 뿐만 아니라 관련 기술의 개발 및 적용을 촉진하는 데에도 도움이 됩니다.

프로젝트 주소: https://top.aibase.com/tool/deepseek-coder-v2

온라인 체험: https://chat.deepseek.com/sign_in

DeepSeek-Coder-V2의 오픈 소스 릴리스는 개발자에게 강력한 도구를 제공하고 오픈 소스 대형 모델 기술의 상당한 발전을 의미합니다. 무료 상업적 이용과 편리한 온라인 체험 플랫폼은 인공지능 기술의 대중화와 적용을 더욱 촉진할 것이며, 앞으로의 발전과 활용을 기대해볼 만하다.