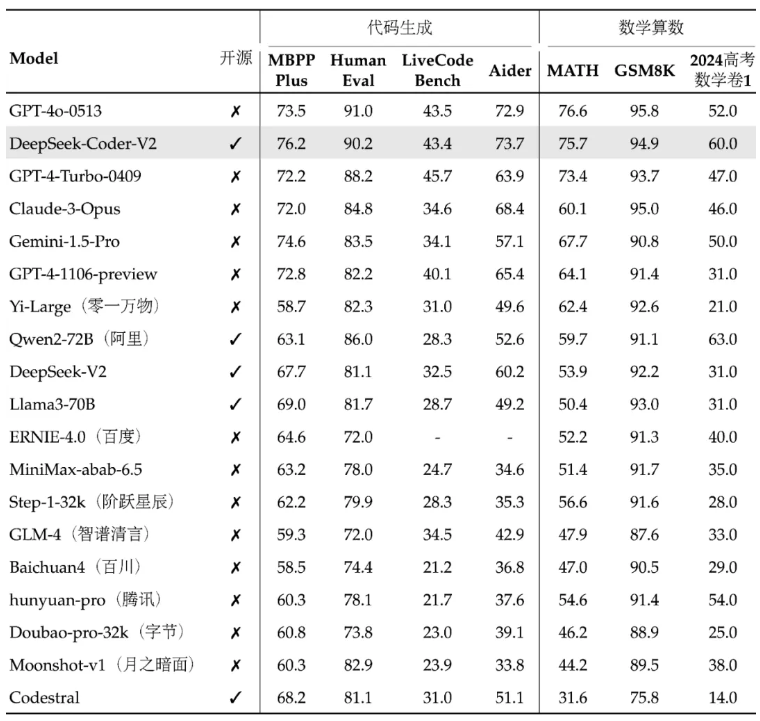

DeepSeek lanzó recientemente su nuevo modelo de código abierto DeepSeek-Coder-V2, que supera a GPT-4-Turbo en términos de código y capacidades matemáticas, y mejora significativamente la compatibilidad con varios idiomas y la duración del procesamiento de contexto. Adopta una arquitectura Mix of Experts (MoE) y está optimizada específicamente para la generación de código y capacidades de razonamiento matemático. Su rendimiento se encuentra entre los mejores del mundo y proporciona dos opciones de escala de parámetros de 236 B y parámetros de 16 B para satisfacer diferentes necesidades de aplicaciones. Todos los códigos, documentos y modelos son de código abierto y se pueden utilizar comercialmente de forma gratuita sin necesidad de una aplicación.

Webmaster's Home (ChinaZ.com) Noticias del 18 de junio: DeepSeek anunció recientemente el lanzamiento de un modelo de código abierto llamado DeepSeek-Coder-V2, que supera al GPT-4-Turbo en términos de código y capacidades matemáticas y se ha ampliado significativamente. soporte multilingüe y longitud de procesamiento de contexto. Basado en la estructura del modelo de DeepSeek-V2, DeepSeek-Coder-V2 adopta una arquitectura Mix of Experts (MoE) diseñada específicamente para mejorar las capacidades de código y razonamiento matemático.

El rendimiento de DeepSeek-Coder-V2 se encuentra entre los mejores del mundo y sus capacidades de generación de código y aritmética matemática son particularmente sobresalientes. Este modelo y sus códigos y documentos relacionados han sido de código abierto y están disponibles para uso comercial gratuito sin necesidad de aplicación. El modelo está disponible en dos tamaños: parámetros 236B y parámetros 16B para satisfacer diferentes necesidades de aplicaciones.

En términos de soporte multilenguaje, los lenguajes de programación que puede admitir DeepSeek-Coder-V2 se han ampliado de 86 a 338, adaptándose a necesidades de desarrollo más diversas. Al mismo tiempo, la longitud del contexto que admite se amplía de 16K a 128K, lo que le permite manejar contenido de entrada más largo. DeepSeek-Coder-V2 también proporciona servicios API, admite contexto de 32K y el precio es el mismo que DeepSeek-V2.

En las pruebas comparativas estándar, DeepSeek-Coder-V2 supera a algunos modelos de código cerrado en generación de código, finalización de código, reparación de código y razonamiento matemático. Los usuarios pueden descargar diferentes versiones del modelo DeepSeek-Coder-V2, incluida la versión básica y la versión de instrucciones, así como versiones con diferentes escalas de parámetros.

DeepSeek también proporciona una plataforma de experiencia en línea y enlaces de GitHub, así como informes técnicos, para facilitar que los usuarios comprendan y utilicen DeepSeek-Coder-V2. El lanzamiento de este modelo no solo aporta potentes capacidades de procesamiento matemático y de código a la comunidad de código abierto, sino que también ayuda a promover el desarrollo y la aplicación de tecnologías relacionadas.

Dirección del proyecto: https://top.aibase.com/tool/deepseek-coder-v2

Experiencia en línea: https://chat.deepseek.com/sign_in

La versión de código abierto de DeepSeek-Coder-V2 proporciona a los desarrolladores herramientas poderosas y marca un avance significativo en la tecnología de modelos grandes de código abierto. Su uso comercial gratuito y su conveniente plataforma de experiencia en línea promoverán aún más la popularización y aplicación de la tecnología de inteligencia artificial, y vale la pena esperar su desarrollo y aplicación futuros.