DeepSeek hat kürzlich sein neues Open-Source-Modell DeepSeek-Coder-V2 veröffentlicht, das GPT-4-Turbo in Bezug auf Code und mathematische Fähigkeiten übertrifft und die Unterstützung mehrerer Sprachen und die Länge der Kontextverarbeitung erheblich verbessert. Es verwendet eine Mix of Experts (MoE)-Architektur und ist speziell für die Codegenerierung und mathematische Argumentationsfunktionen optimiert. Seine Leistung gehört zu den besten der Welt und es bietet zwei Skalierungsoptionen mit 236B-Parametern und 16B-Parametern, um unterschiedliche Anwendungsanforderungen zu erfüllen. Alle Codes, Dokumente und Modelle sind Open Source und können ohne Antrag kostenlos kommerziell genutzt werden.

Webmaster's Home (ChinaZ.com) Neuigkeiten vom 18. Juni: DeepSeek hat kürzlich die Veröffentlichung eines Open-Source-Modells namens DeepSeek-Coder-V2 angekündigt, das GPT-4-Turbo in Bezug auf Code und mathematische Fähigkeiten übertrifft und erheblich erweitert wurde Unterstützung mehrerer Sprachen und Länge der Kontextverarbeitung. Basierend auf der Modellstruktur von DeepSeek-V2 verwendet DeepSeek-Coder-V2 eine Mix of Experts (MoE)-Architektur, die speziell zur Verbesserung der Code- und mathematischen Argumentationsfähigkeiten entwickelt wurde.

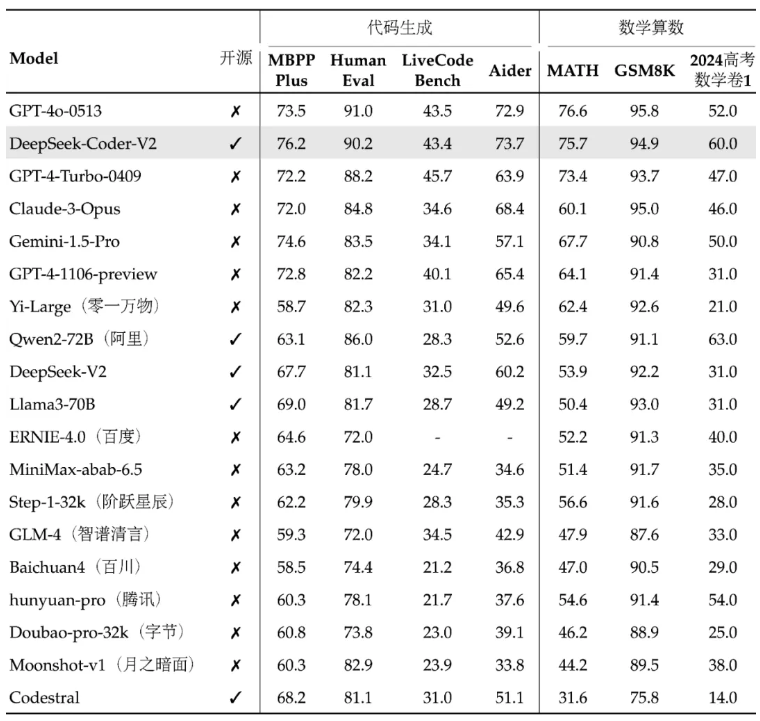

Die Leistung von DeepSeek-Coder-V2 zählt zu den besten der Welt, besonders hervorzuheben sind die Codegenerierung und die mathematischen Rechenfähigkeiten. Dieses Modell und die zugehörigen Codes und Dokumente sind alle Open Source und können ohne Anwendung kostenlos und kommerziell genutzt werden. Das Modell ist in zwei Größen erhältlich: 236B-Parameter und 16B-Parameter, um unterschiedlichen Anwendungsanforderungen gerecht zu werden.

Im Hinblick auf die Mehrsprachenunterstützung wurden die Programmiersprachen, die DeepSeek-Coder-V2 unterstützen kann, von 86 auf 338 erweitert, um sich an vielfältigere Entwicklungsanforderungen anzupassen. Gleichzeitig wird die unterstützte Kontextlänge von 16 KB auf 128 KB erweitert, sodass längere Eingabeinhalte verarbeitet werden können. DeepSeek-Coder-V2 bietet außerdem API-Dienste, unterstützt 32K-Kontext und der Preis ist der gleiche wie bei DeepSeek-V2.

In Standard-Benchmark-Tests übertrifft DeepSeek-Coder-V2 einige Closed-Source-Modelle in den Bereichen Codegenerierung, Codevervollständigung, Codereparatur und mathematisches Denken. Benutzer können verschiedene Versionen des DeepSeek-Coder-V2-Modells herunterladen, darunter die Basisversion und die Anleitungsversion sowie Versionen mit unterschiedlichen Parameterskalen.

DeepSeek bietet außerdem eine Online-Erlebnisplattform und GitHub-Links sowie technische Berichte, um Benutzern das Verständnis und die Verwendung von DeepSeek-Coder-V2 zu erleichtern. Die Veröffentlichung dieses Modells bringt nicht nur leistungsstarke Code- und mathematische Verarbeitungsfunktionen in die Open-Source-Community, sondern trägt auch dazu bei, die Entwicklung und Anwendung verwandter Technologien zu fördern.

Projektadresse: https://top.aibase.com/tool/deepseek-coder-v2

Online-Erlebnis: https://chat.deepseek.com/sign_in

Die Open-Source-Version von DeepSeek-Coder-V2 bietet Entwicklern leistungsstarke Tools und markiert einen bedeutenden Fortschritt in der Open-Source-Technologie für große Modelle. Die kostenlose kommerzielle Nutzung und die praktische Online-Erlebnisplattform werden die Popularisierung und Anwendung der Technologie der künstlichen Intelligenz weiter vorantreiben, und es lohnt sich, auf ihre zukünftige Entwicklung und Anwendung zu blicken.