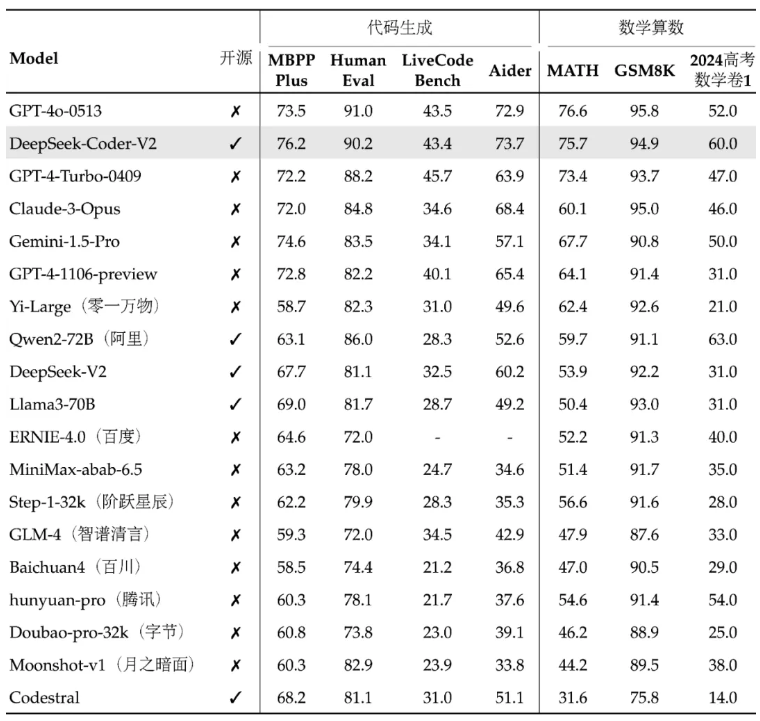

DeepSeek a récemment publié son nouveau modèle open source DeepSeek-Coder-V2, qui surpasse GPT-4-Turbo en termes de code et de capacités mathématiques, et améliore considérablement la prise en charge multilingue et la durée de traitement du contexte. Il adopte une architecture Mix of Experts (MoE) et est spécifiquement optimisé pour la génération de code et les capacités de raisonnement mathématique. Ses performances sont parmi les meilleures au monde et il offre deux options d'échelle de paramètres 236B et 16B pour répondre aux différents besoins des applications. Tous les codes, documents et modèles sont open source et peuvent être utilisés gratuitement commercialement sans application.

Webmaster's Home (ChinaZ.com) News du 18 juin : DeepSeek a récemment annoncé la sortie d'un modèle open source appelé DeepSeek-Coder-V2, qui surpasse GPT-4-Turbo en termes de code et de capacités mathématiques et a été considérablement étendu. prise en charge multilingue et longueur de traitement du contexte. Basé sur la structure du modèle de DeepSeek-V2, DeepSeek-Coder-V2 adopte une architecture Mix of Experts (MoE) spécialement conçue pour améliorer les capacités de code et de raisonnement mathématique.

Les performances de DeepSeek-Coder-V2 se classent parmi les meilleures au monde, et ses capacités de génération de code et d'arithmétique mathématique sont particulièrement remarquables. Ce modèle et ses codes et documents associés sont tous open source et sont disponibles pour une utilisation commerciale gratuite sans application. Le modèle est disponible en deux tailles : paramètres 236B et paramètres 16B pour répondre aux différents besoins des applications.

En termes de prise en charge multilingue, les langages de programmation que DeepSeek-Coder-V2 peut prendre en charge ont été étendus de 86 à 338, s'adaptant à des besoins de développement plus diversifiés. Dans le même temps, la longueur du contexte qu'il prend en charge est étendue de 16 Ko à 128 Ko, ce qui lui permet de gérer un contenu d'entrée plus long. DeepSeek-Coder-V2 fournit également des services API, prend en charge le contexte 32K et le prix est le même que DeepSeek-V2.

Dans les tests de référence standard, DeepSeek-Coder-V2 surpasse certains modèles à source fermée en termes de génération de code, de complétion de code, de réparation de code et de raisonnement mathématique. Les utilisateurs peuvent télécharger différentes versions du modèle DeepSeek-Coder-V2, y compris la version de base et la version d'instructions, ainsi que des versions avec différentes échelles de paramètres.

DeepSeek fournit également une plate-forme d'expérience en ligne et des liens GitHub, ainsi que des rapports techniques, pour permettre aux utilisateurs de mieux comprendre et utiliser DeepSeek-Coder-V2. La sortie de ce modèle apporte non seulement de puissantes capacités de code et de traitement mathématique à la communauté open source, mais contribue également à promouvoir le développement et l'application de technologies associées.

Adresse du projet : https://top.aibase.com/tool/deepseek-coder-v2

Expérience en ligne : https://chat.deepseek.com/sign_in

La version open source de DeepSeek-Coder-V2 fournit aux développeurs des outils puissants et marque une avancée significative dans la technologie open source des grands modèles. Son utilisation commerciale gratuite et sa plate-forme d'expérience en ligne pratique favoriseront davantage la vulgarisation et l'application de la technologie de l'intelligence artificielle, et il vaut la peine d'attendre avec impatience son développement et ses applications futurs.