DeepSeek は最近、新しいオープン ソース モデル DeepSeek-Coder-V2 をリリースしました。これは、コードと数学的機能の点で GPT-4-Turbo を上回り、多言語サポートとコンテキスト処理の長さを大幅に改善します。 Mix of Experts (MoE) アーキテクチャを採用しており、特にコード生成と数学的推論機能に最適化されており、そのパフォーマンスは世界最高であり、さまざまなアプリケーションのニーズを満たすために 236B パラメーターと 16B パラメーターの 2 つのスケール オプションを提供します。すべてのコード、論文、モデルはオープンソースであり、申請なしで無料で商用利用できます。

ウェブマスター ホーム (ChinaZ.com) 6 月 18 日のニュース: DeepSeek は最近、コードと数学的機能の点で GPT-4-Turbo を超える DeepSeek-Coder-V2 と呼ばれるオープンソース モデルのリリースを発表しました。多言語サポートとコンテキスト処理の長さ。 DeepSeek-V2 のモデル構造に基づいて、DeepSeek-Coder-V2 は、コードと数学的推論の機能を強化するために特別に設計された Mix of Experts (MoE) アーキテクチャを採用しています。

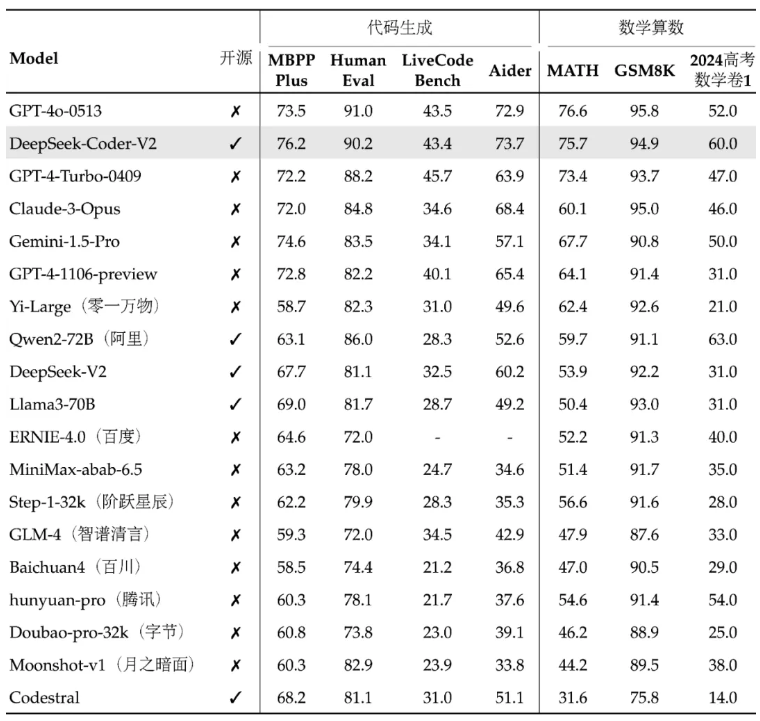

DeepSeek-Coder-V2 の性能は世界最高クラスであり、特にコード生成機能と算術演算機能が優れています。このモデルとそれに関連するコードと論文はすべてオープンソースであり、申請なしで無料で商用利用できます。このモデルには、さまざまなアプリケーションのニーズを満たすために、236B パラメータと 16B パラメータの 2 つのサイズが用意されています。

多言語対応では、DeepSeek-Coder-V2がサポートできるプログラミング言語を86言語から338言語に拡張し、より多様な開発ニーズに対応しました。同時に、サポートするコンテキストの長さが 16K から 128K に拡張され、より長い入力コンテンツを処理できるようになりました。 DeepSeek-Coder-V2 も API サービスを提供し、32K コンテキストをサポートし、価格は DeepSeek-V2 と同じです。

標準ベンチマーク テストでは、DeepSeek-Coder-V2 は、コード生成、コード補完、コード修復、数学的推論において、一部のクローズド ソース モデルよりも優れたパフォーマンスを示しました。ユーザーは、基本バージョン、命令バージョン、およびパラメーター スケールが異なるバージョンなど、さまざまなバージョンの DeepSeek-Coder-V2 モデルをダウンロードできます。

DeepSeek は、ユーザーが DeepSeek-Coder-V2 をさらに理解し、使用できるように、オンライン エクスペリエンス プラットフォームと GitHub リンク、技術レポートも提供します。このモデルのリリースは、強力なコードと数学的処理機能をオープンソース コミュニティにもたらすだけでなく、関連テクノロジーの開発と応用の促進にも役立ちます。

プロジェクトアドレス: https://top.aibase.com/tool/deepseek-coder-v2

オンライン体験: https://chat.deepseek.com/sign_in

DeepSeek-Coder-V2 のオープン ソース リリースは、開発者に強力なツールを提供し、オープン ソースの大規模モデル テクノロジの大幅な進歩を示します。無料の商用利用と便利なオンライン体験プラットフォームは、人工知能技術の普及と応用をさらに促進し、将来の開発と応用に期待する価値があります。