Авторы : Yixuan Su, Fangyu Liu, Zaiqiao Meng, Tian Lan, Lei Shu, Ehsan Shareghi и Nigel Collier

Код нашей статьи: TACL: улучшение предварительного обучения BERT с помощью контрастного обучения с токеном.

[使用中文 TACL-BERT 进行中文命名实体识别及中文分词教程]

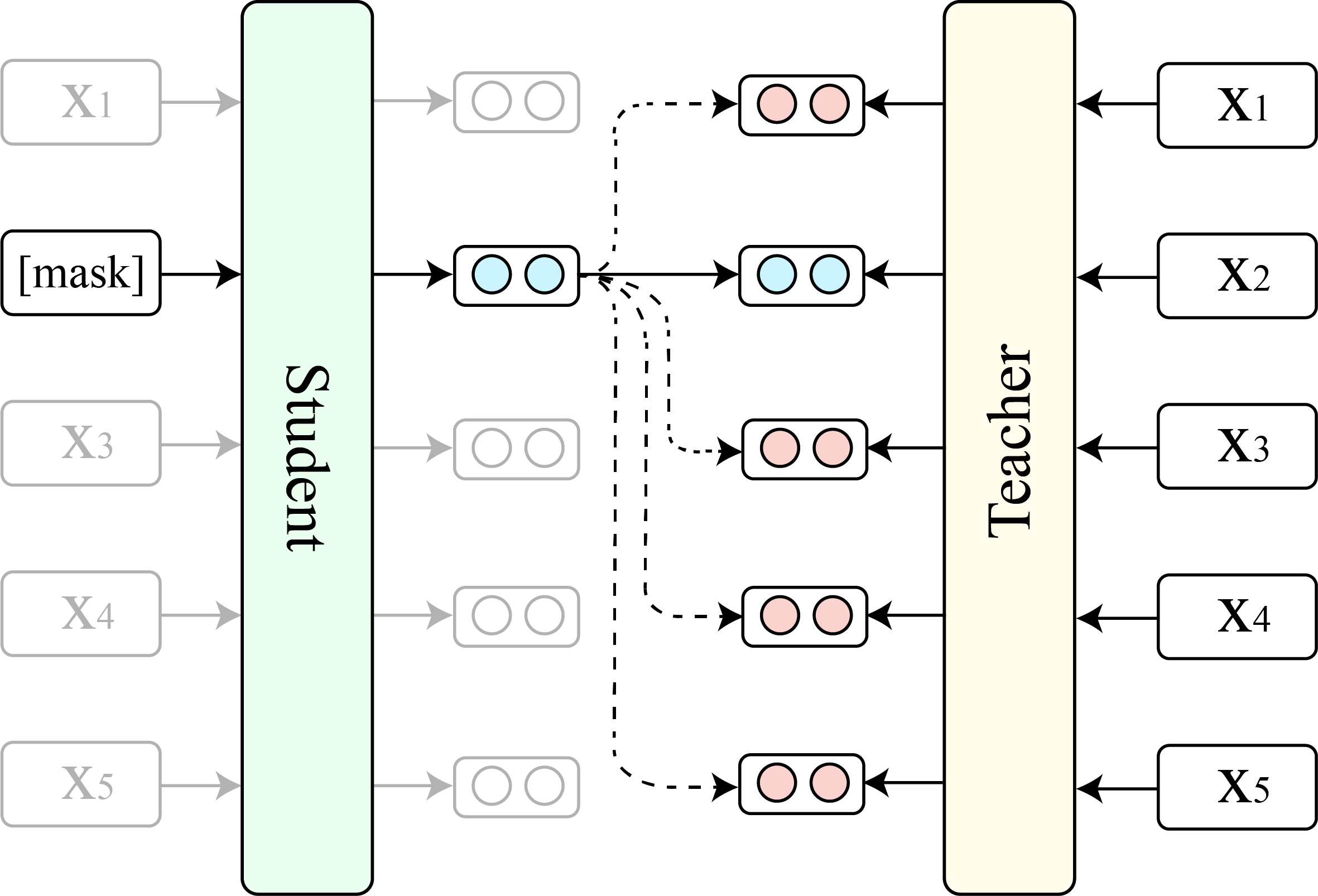

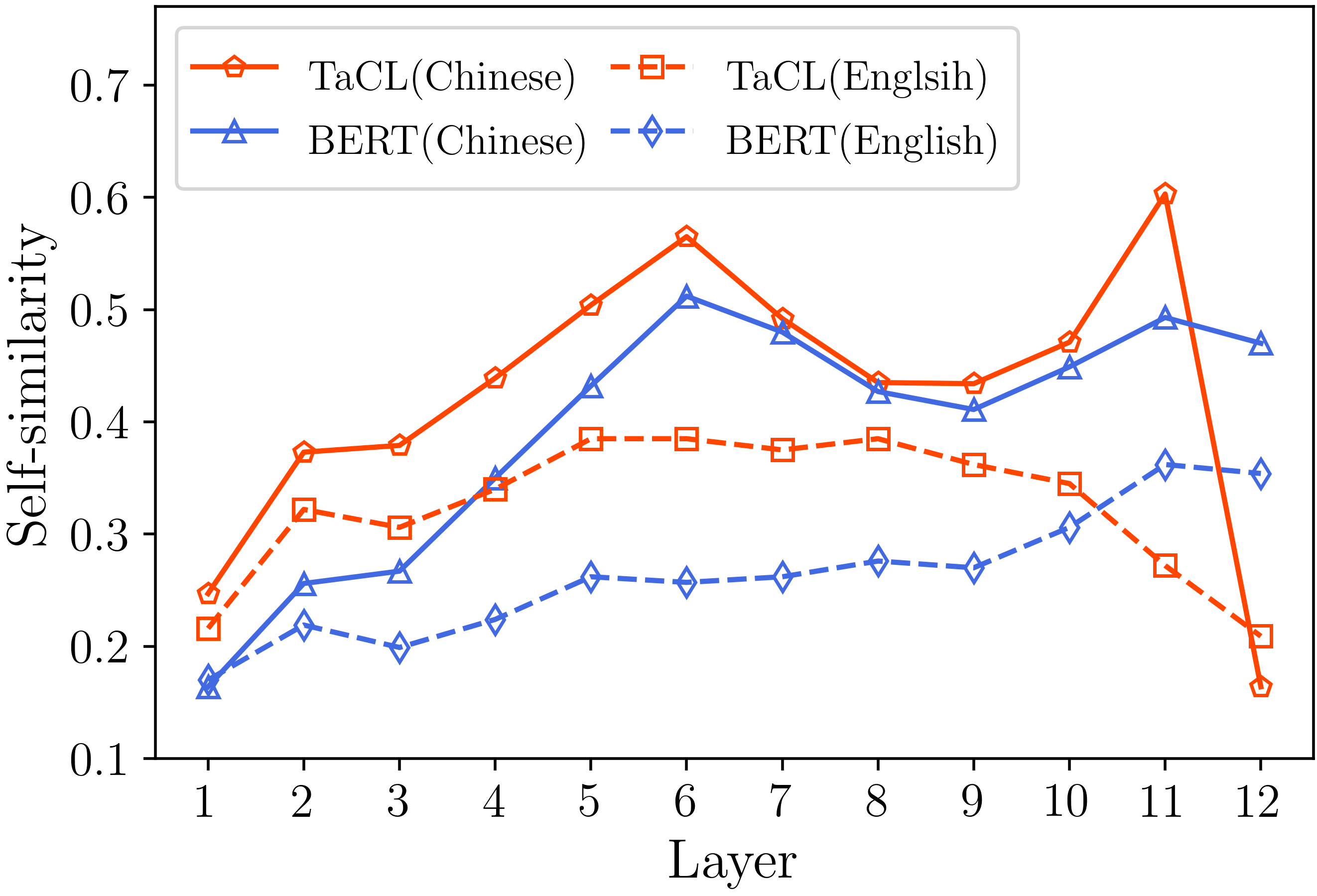

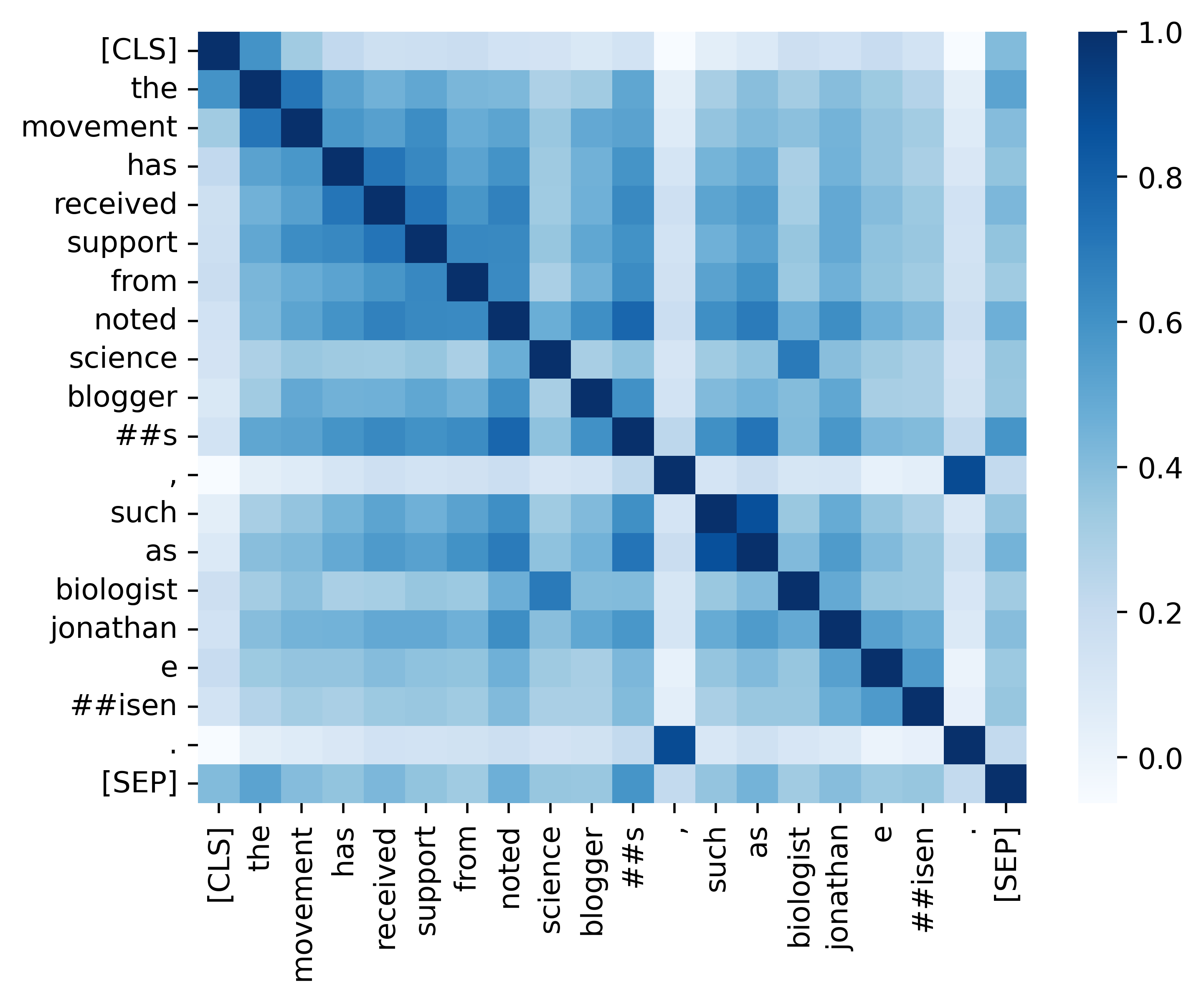

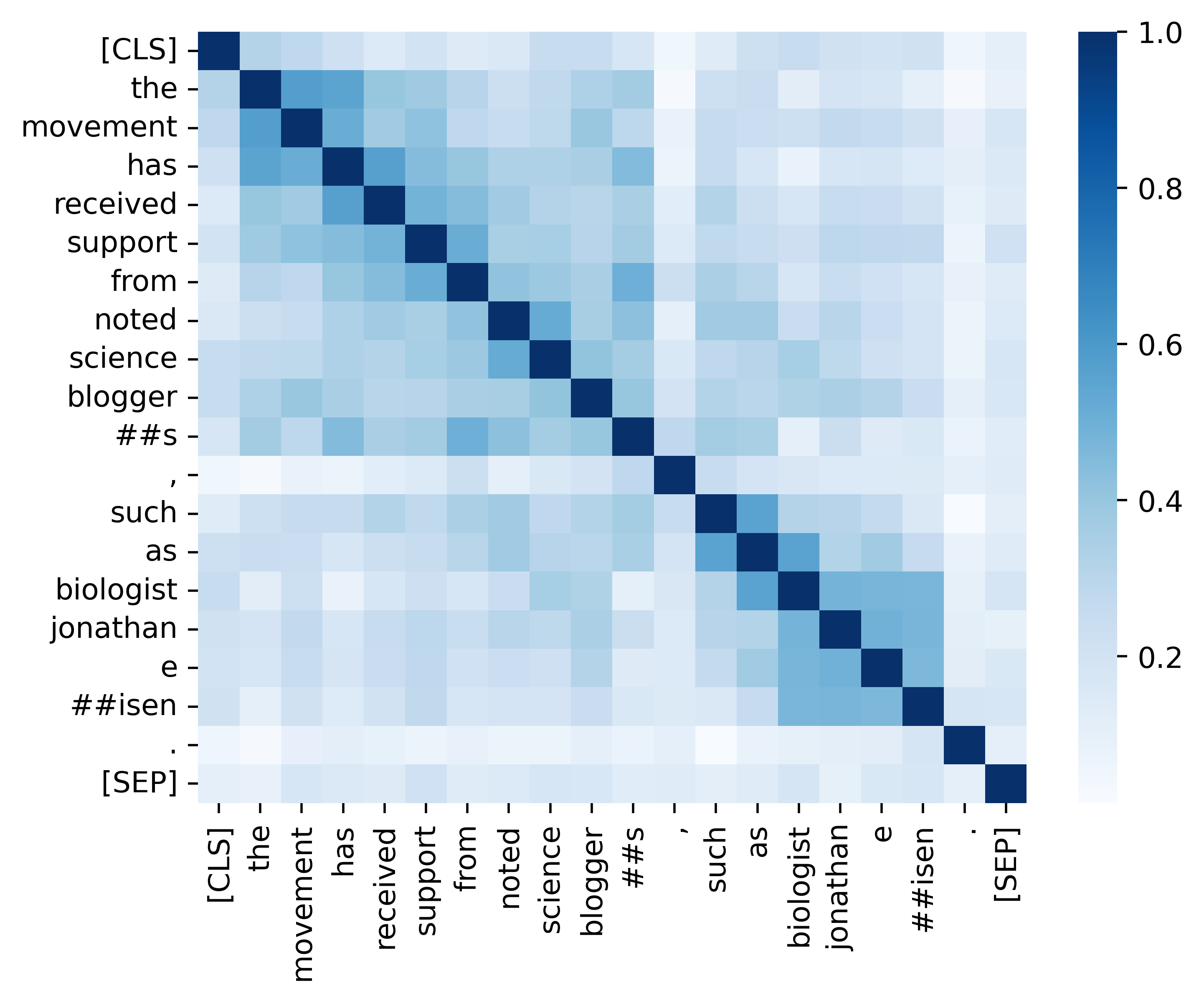

В последних нескольких лет модели в масках (MLMS), такие как Берт и Роберта, произвели революцию в области понимания естественного языка. Однако существующие предварительно обученные MLM часто выводят анизотропное распределение представлений токенов, которое занимает узкое подмножество всего пространства представления. Такие представления токена не являются идеальными, особенно для задач, которые требуют дискриминационных семантических значений отдельных токенов. В этой работе мы предлагаем TACL ( T Oken- A Sware Contrastive L ), новый постоянный подход предварительного обучения, который побуждает Берта изучать изотропное и дискриминационное распределение представлений токенов. TACL полностью не подходит и не требует дополнительных данных. Мы тщательно проверяем наш подход на широком спектре английских и китайских критериев. Результаты показывают, что TACL приносит последовательные и заметные улучшения по сравнению с исходной моделью BERT. Кроме того, мы проводим подробный анализ, чтобы раскрыть достоинства и внутренние работы нашего подхода.

Мы показываем сравнение между TACL (базовая версия) и оригинальную BERT (базовая версия).

(1) Результаты английского языка по отряду (Rajpurkar et al., 2018) (Dev Set) и Glue (Wang et al., 2019) Средний балл.

| Модель | Команда 1.1 (EM/F1) | Squad 2.0 (EM/F1) | Средний клей |

|---|---|---|---|

| БЕРТ | 80,8/88,5 | 73,4/76,8 | 79,6 |

| Такл | 81,6/89,0 | 74,4/77,5 | 81.2 |

(2) Результаты китайского эталонного эталона (тестовый набор F1) по четырем задачам NER (MSRA, Ontonotes, Resume и Weibo) и три задачи китайского сегментации слов (CWS) (PKU, Cityu и AS).

| Модель | MSRA | Онтонот | Резюме | Вейбо | Пку | Сити | КАК |

|---|---|---|---|---|---|---|---|

| БЕРТ | 94,95 | 80.14 | 95,53 | 68.20 | 96.50 | 97.60 | 96.50 |

| Такл | 95,44 | 82,42 | 96.45 | 69,54 | 96.75 | 98.16 | 96.75 |

| Название модели | Модельный адрес |

|---|---|

| Английский ( Cambridgeltl/Tacl-Bert-базовый | связь |

| Китайский ( Cambridgeltl/Tacl-Bert-Base-Chinese ) | связь |

import torch

# initialize model

from transformers import AutoModel , AutoTokenizer

model_name = 'cambridgeltl/tacl-bert-base-uncased'

model = AutoModel . from_pretrained ( model_name )

tokenizer = AutoTokenizer . from_pretrained ( model_name )

# create input ids

text = '[CLS] clbert is awesome. [SEP]'

tokenized_token_list = tokenizer . tokenize ( text )

input_ids = torch . LongTensor ( tokenizer . convert_tokens_to_ids ( tokenized_token_list )). view ( 1 , - 1 )

# compute hidden states

representation = model ( input_ids ). last_hidden_state # [1, seqlen, embed_dim] python version : 3.8

pip3 install -r requirements.txtПожалуйста, обратитесь к деталям, представленным в каталоге ./pretraining_data.

Пожалуйста, обратитесь к деталям, представленным в каталоге ./Pretrioing.

Пожалуйста, обратитесь к деталям, представленным в каталоге ./english_benchmark.

chmod +x ./download_benchmark_data.sh

./download_benchmark_data.sh Пожалуйста, обратитесь к деталям, представленным в каталоге ./chinese_benchmark.

Мы предоставляем весь необходимый код для воспроизведения результатов (изображения ниже), представленные в нашем разделе анализа. Связанные коды и инструкции расположены в каталоге ./Analysis. Веселиться!

Если вы найдете нашу статью и ресурсы полезными, пожалуйста, обратитесь к нашей статье:

@article { DBLP:journals/corr/abs-2111-04198 ,

author = { Yixuan Su and

Fangyu Liu and

Zaiqiao Meng and

Tian Lan and

Lei Shu and

Ehsan Shareghi and

Nigel Collier } ,

title = { TaCL: Improving {BERT} Pre-training with Token-aware Contrastive Learning } ,

journal = { CoRR } ,

volume = { abs/2111.04198 } ,

year = { 2021 } ,

url = { https://arxiv.org/abs/2111.04198 } ,

eprinttype = { arXiv } ,

eprint = { 2111.04198 } ,

timestamp = { Wed, 10 Nov 2021 16:07:30 +0100 } ,

biburl = { https://dblp.org/rec/journals/corr/abs-2111-04198.bib } ,

bibsource = { dblp computer science bibliography, https://dblp.org }

}Если у вас есть какие -либо вопросы, не стесняйтесь обращаться ко мне через ([email protected]).