Autores : Yixuan Su, Fangyu Liu, Zaiqiao Meng, Tian Lan, Lei Shu, Ehsan Shareghi e Nigel Collier

Código do nosso artigo: TACL: Melhorando o Bert pré-treinamento com aprendizado contrastivo com reconhecimento de tokens

[使用中文 Tacl-Bert 进行中文命名实体识别及中文分词教程]

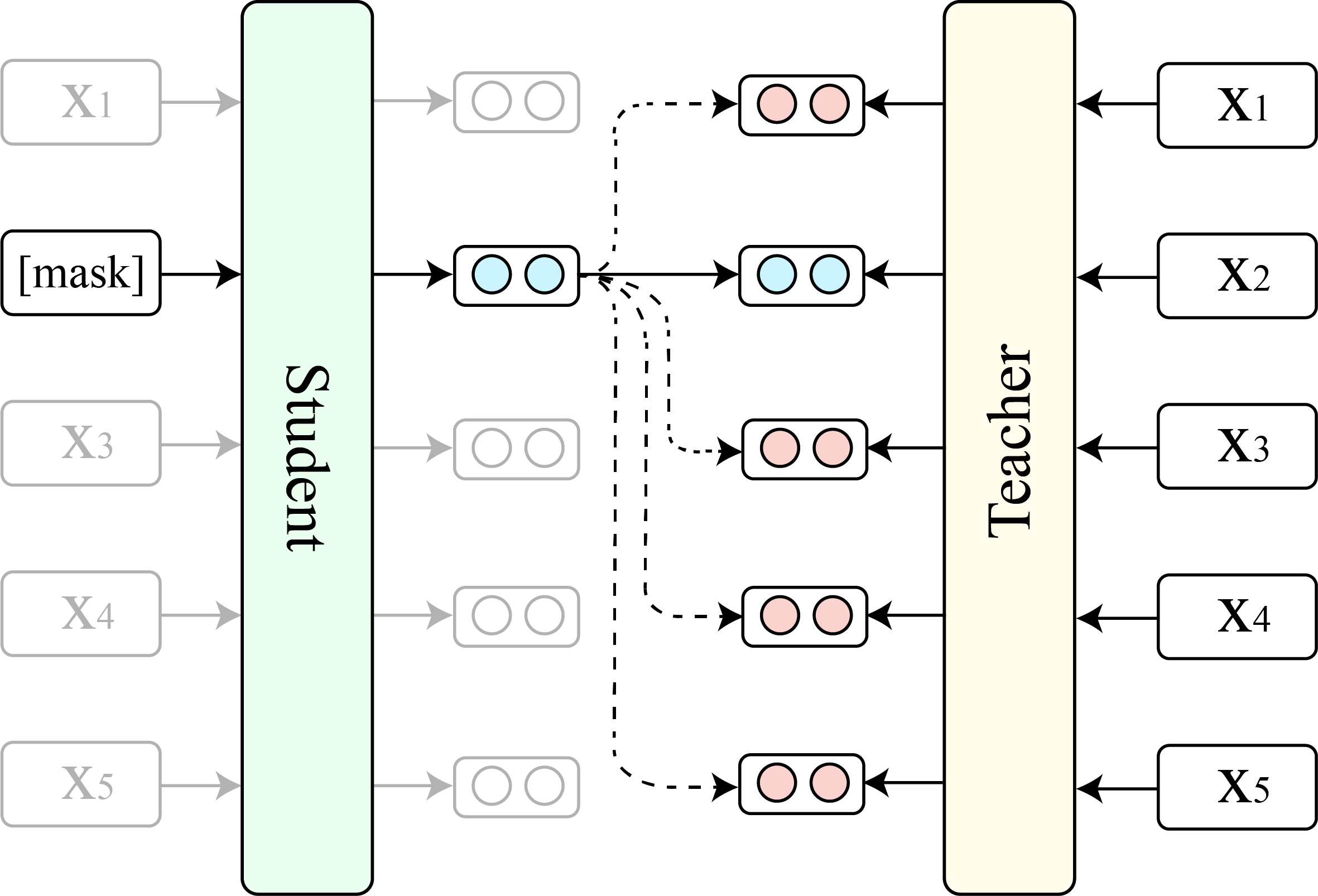

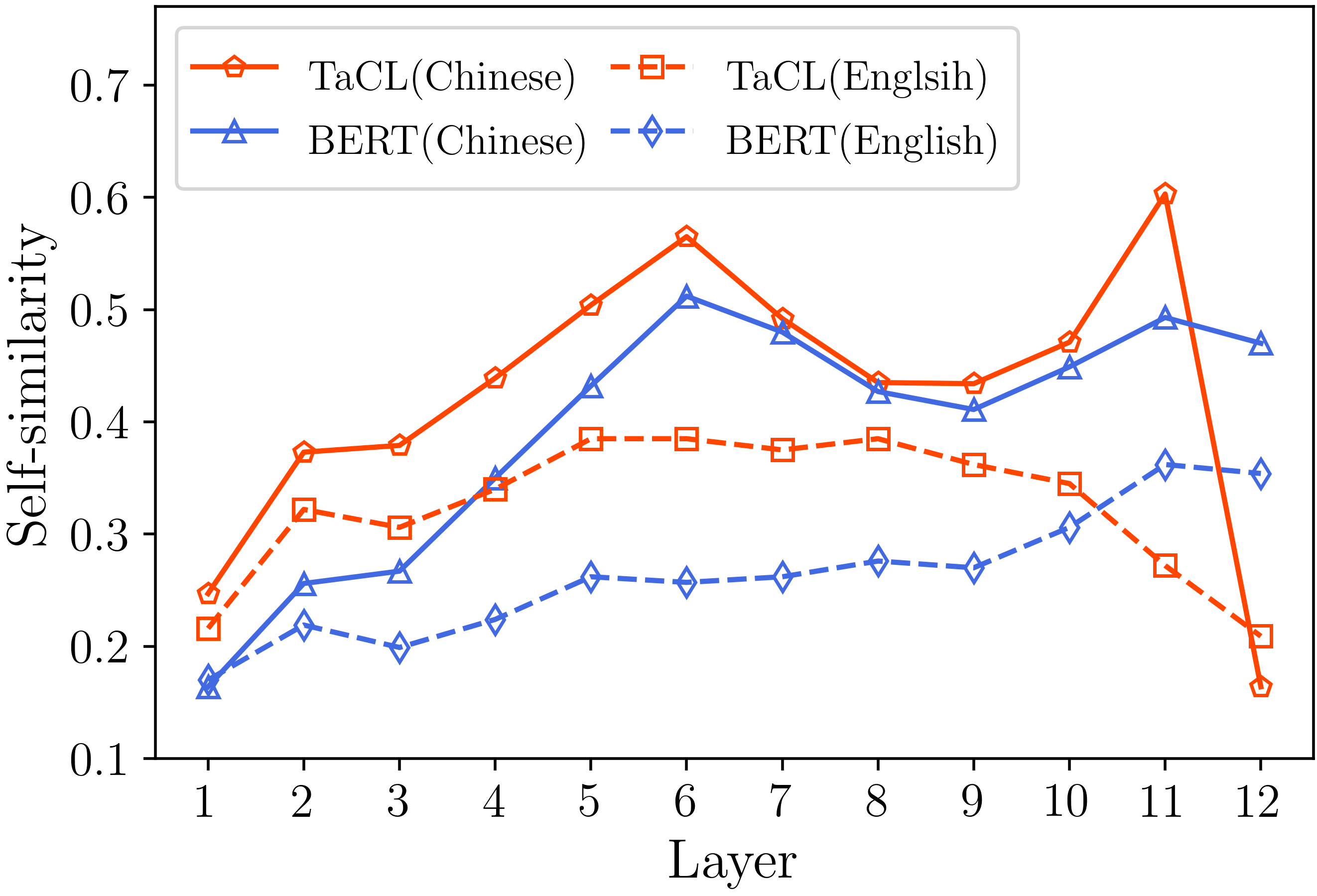

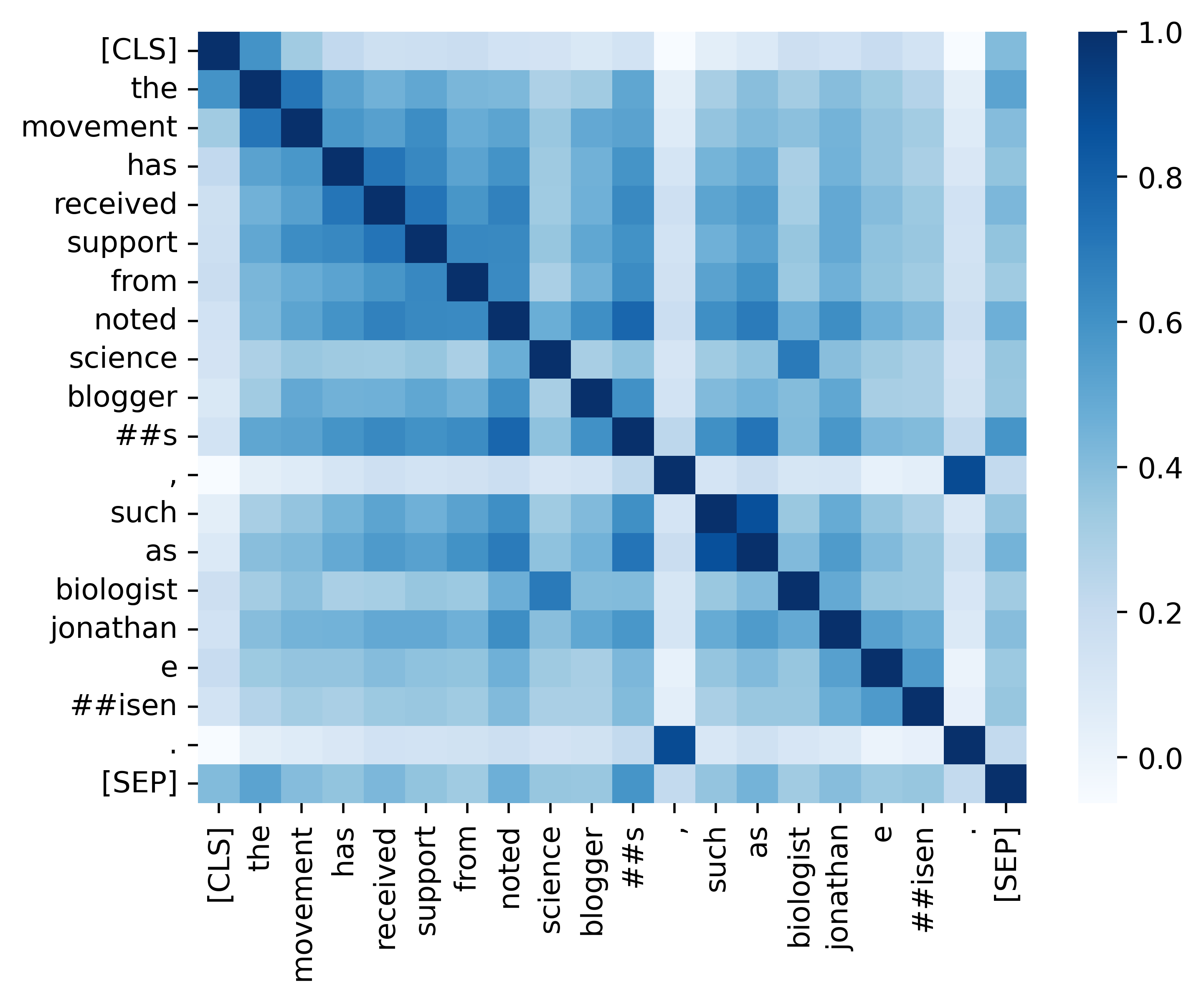

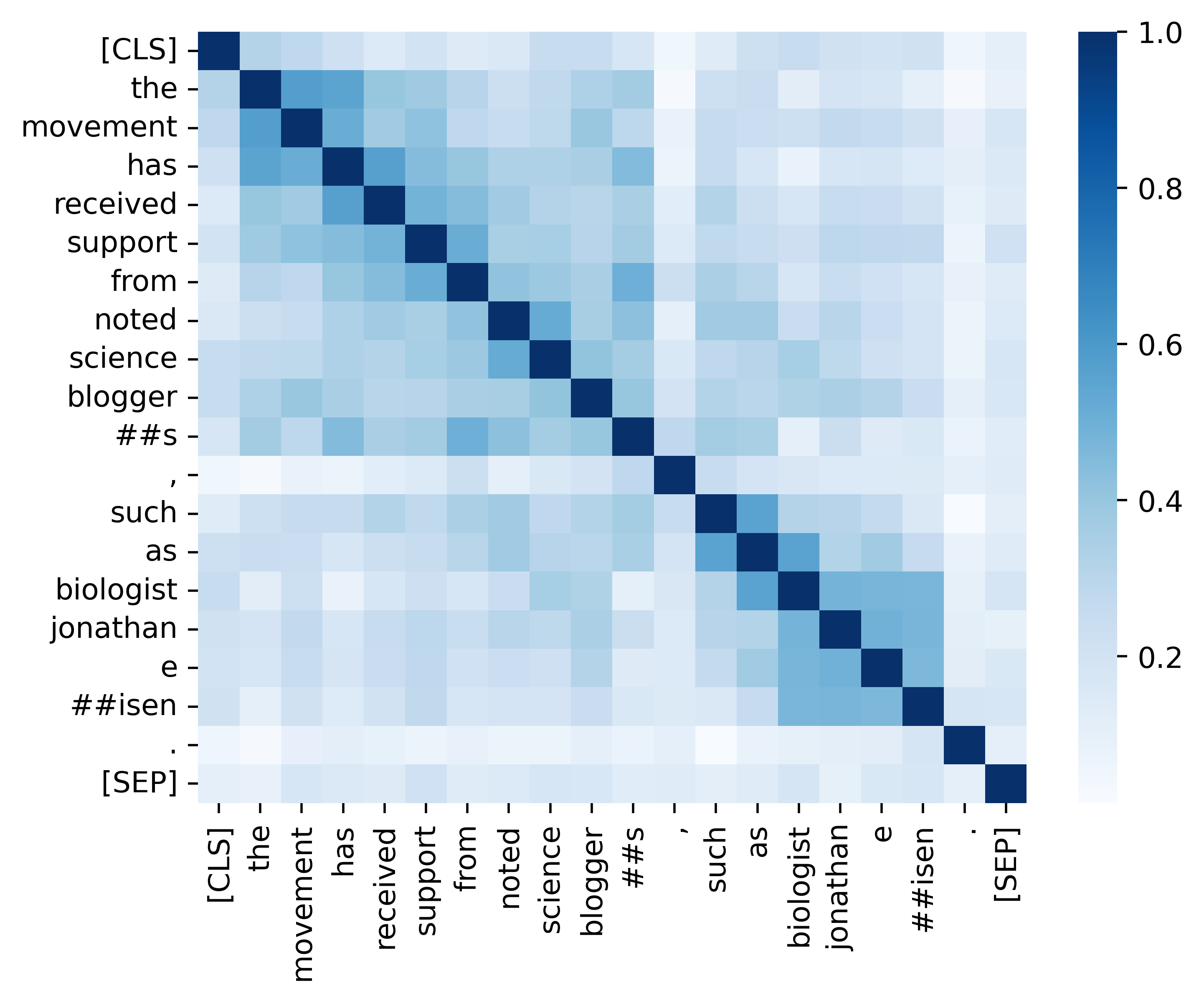

Modelos de idiomas mascarados (MLMs) como Bert e Roberta revolucionaram o campo do entendimento da linguagem natural nos últimos anos. No entanto, os MLMs pré-treinados existentes geralmente produzem uma distribuição anisotrópica de representações token que ocupa um subconjunto estreito de todo o espaço de representação. Tais representações simbólicas não são ideais, especialmente para tarefas que exigem significados semânticos discriminativos de tokens distintos. Neste trabalho, propomos TACL ( T OKEN- A WARE CTRASTIVIVE L GANHING), uma nova abordagem contínua de pré-treinamento que incentiva Bert a aprender uma distribuição isotrópica e discriminativa de representações simbólicas. O TACL não é totalmente supervisionado e não requer dados adicionais. Testamos extensivamente nossa abordagem em uma ampla gama de benchmarks em inglês e chinês. Os resultados mostram que o TACL traz melhorias consistentes e notáveis em relação ao modelo BERT original. Além disso, realizamos análises detalhadas para revelar os méritos e trabalhos internos de nossa abordagem.

Mostramos a comparação entre o TACL (versão base) e o BERT original (versão base).

(1) Resultados de referência em inglês no esquadrão (Rajpurkar et al., 2018) (Dev Set) e Glue (Wang et al., 2019) .

| Modelo | Esquadrão 1.1 (em/f1) | Esquadrão 2.0 (em/f1) | Cola média |

|---|---|---|---|

| Bert | 80.8/88.5 | 73.4/76.8 | 79.6 |

| Tacl | 81.6/89.0 | 74.4/77.5 | 81.2 |

(2) Resultados da referência chinesa (conjunto de testes F1) em quatro tarefas NER (MSRA, Ontontotes, Retomar e Weibo) e três tarefas de segmentação de palavras chinesas (CWS) (PKU, Cityu e AS).

| Modelo | MSRA | Ontonotes | Retomar | PKU | Cityu | COMO | |

|---|---|---|---|---|---|---|---|

| Bert | 94.95 | 80.14 | 95.53 | 68.20 | 96.50 | 97.60 | 96.50 |

| Tacl | 95.44 | 82.42 | 96.45 | 69.54 | 96.75 | 98.16 | 96.75 |

| Nome do modelo | Endereço do modelo |

|---|---|

| Inglês ( Cambridgeltl/Tacl-Bert-Base-Anc baseado ) | link |

| Chinês ( Cambridgeltl/Tacl-Bert-Base-Chinese ) | link |

import torch

# initialize model

from transformers import AutoModel , AutoTokenizer

model_name = 'cambridgeltl/tacl-bert-base-uncased'

model = AutoModel . from_pretrained ( model_name )

tokenizer = AutoTokenizer . from_pretrained ( model_name )

# create input ids

text = '[CLS] clbert is awesome. [SEP]'

tokenized_token_list = tokenizer . tokenize ( text )

input_ids = torch . LongTensor ( tokenizer . convert_tokens_to_ids ( tokenized_token_list )). view ( 1 , - 1 )

# compute hidden states

representation = model ( input_ids ). last_hidden_state # [1, seqlen, embed_dim] python version : 3.8

pip3 install -r requirements.txtConsulte os detalhes fornecidos no diretório ./pretrening_data.

Consulte os detalhes fornecidos no diretório ./preteração.

Consulte os detalhes fornecidos no diretório ./english_benchmark.

chmod +x ./download_benchmark_data.sh

./download_benchmark_data.sh Consulte os detalhes fornecidos no diretório ./chinese_benchmark.

Fornecemos todo o código essencial para replicar os resultados (as imagens abaixo) fornecidas em nossa seção de análise. Os códigos e instruções relacionados estão localizados no diretório de análise. Divirta-se!

Se você achar útil nosso artigo e recursos, cite nosso artigo:

@article { DBLP:journals/corr/abs-2111-04198 ,

author = { Yixuan Su and

Fangyu Liu and

Zaiqiao Meng and

Tian Lan and

Lei Shu and

Ehsan Shareghi and

Nigel Collier } ,

title = { TaCL: Improving {BERT} Pre-training with Token-aware Contrastive Learning } ,

journal = { CoRR } ,

volume = { abs/2111.04198 } ,

year = { 2021 } ,

url = { https://arxiv.org/abs/2111.04198 } ,

eprinttype = { arXiv } ,

eprint = { 2111.04198 } ,

timestamp = { Wed, 10 Nov 2021 16:07:30 +0100 } ,

biburl = { https://dblp.org/rec/journals/corr/abs-2111-04198.bib } ,

bibsource = { dblp computer science bibliography, https://dblp.org }

}Se você tiver alguma dúvida, não hesite em entrar em contato comigo ([email protected]).