Autores : Yixuan Su, Fangyu Liu, Zaiqiao Meng, Tian Lan, Lei Shu, Ehsan Shareghi y Nigel Collier

Código de nuestro artículo: TACL: Mejora de la capacitación de Bert con aprendizaje contrastante consciente de token

[使用中文 Tacl-Bert 进行中文命名实体识别及中文分词教程]

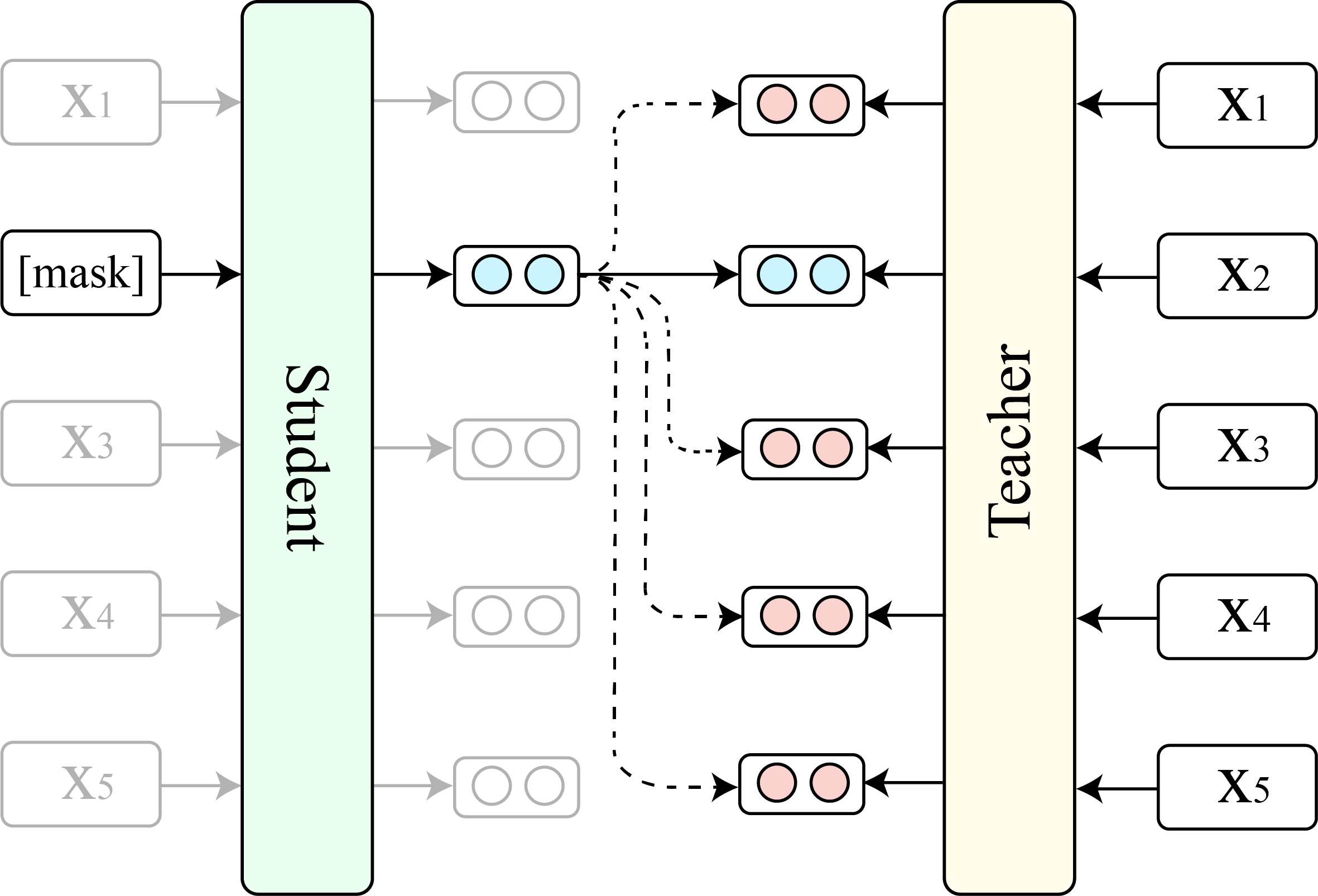

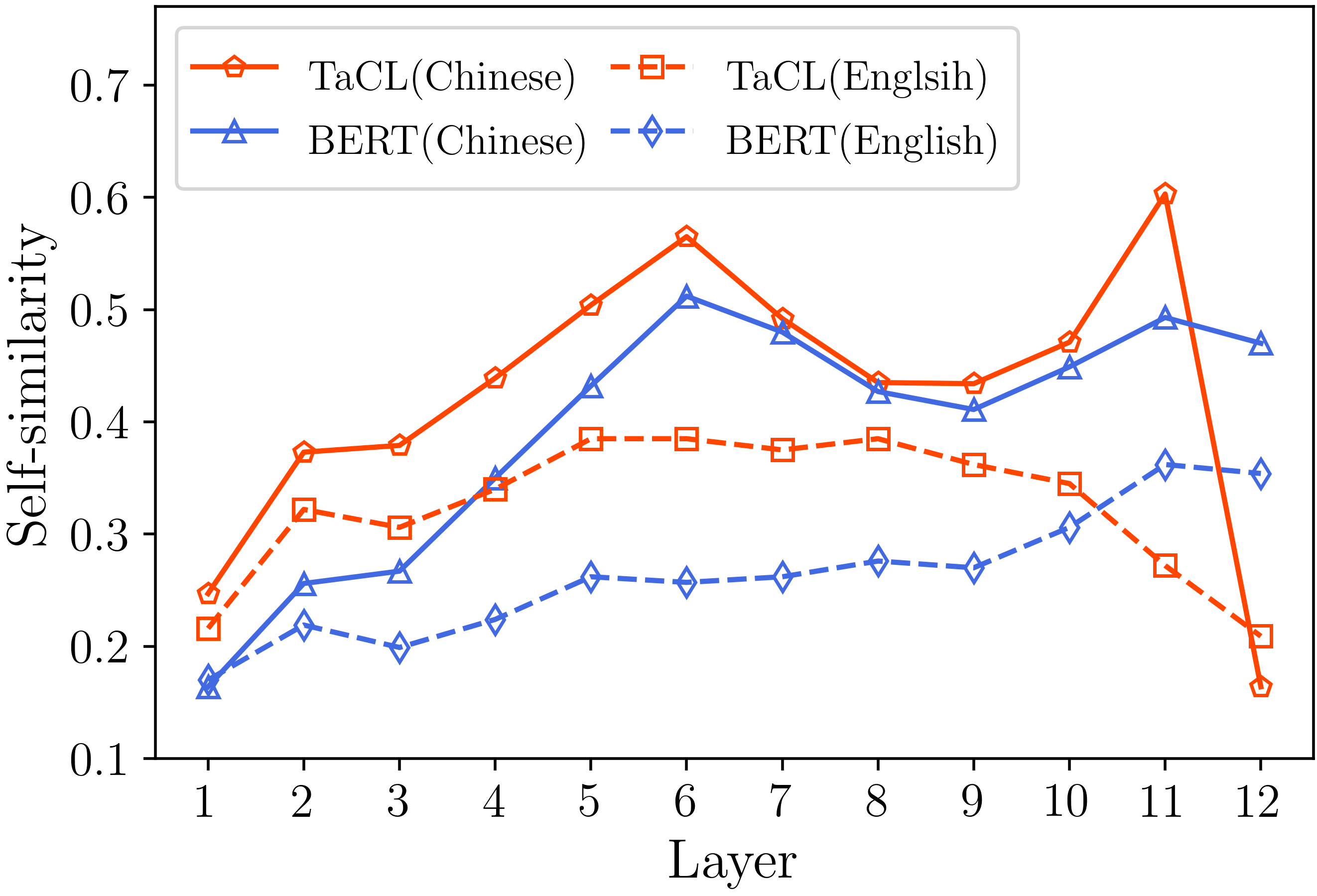

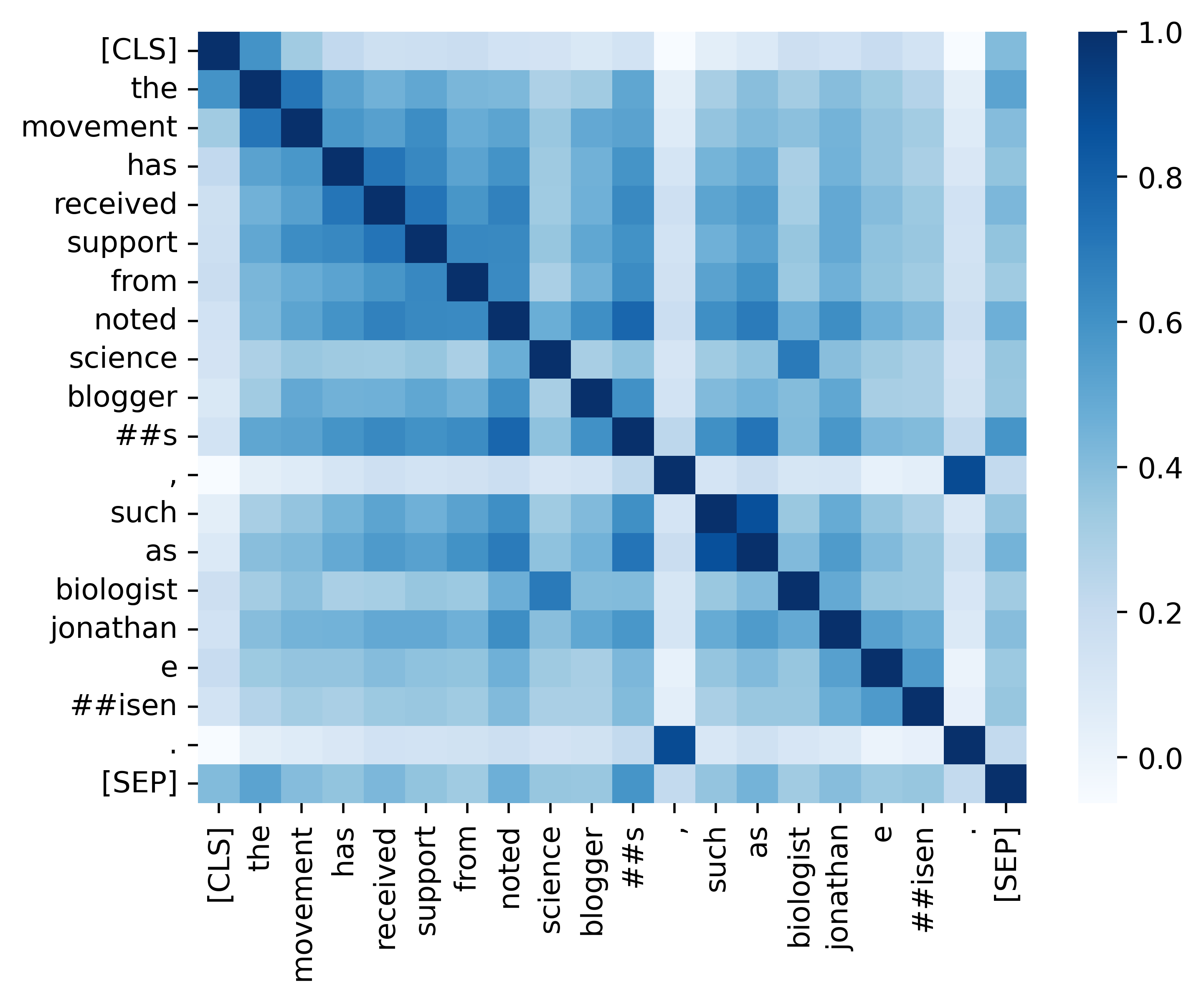

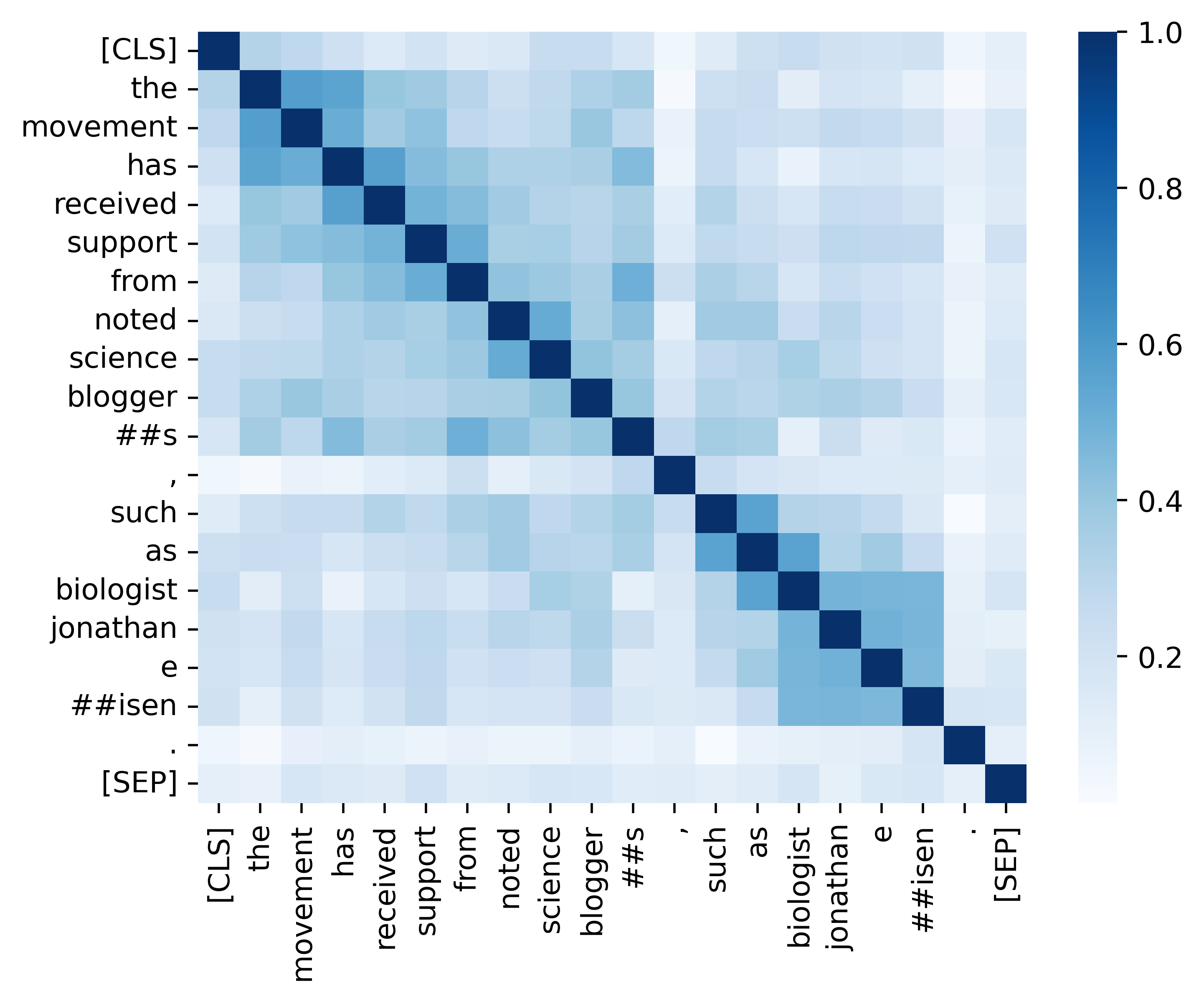

Los modelos de idiomas enmascarados (MLM) como Bert y Roberta han revolucionado el campo de la comprensión del lenguaje natural en los últimos años. Sin embargo, las MLM previas al entrenamiento existentes a menudo producen una distribución anisotrópica de representaciones de token que ocupa un subconjunto estrecho de todo el espacio de representación. Tales representaciones de tokens no son ideales, especialmente para tareas que exigen significados semánticos discriminatorios de tokens distintos. En este trabajo, proponemos TACL ( T Oken- A Ware C Ontrastive L Ganing), un nuevo enfoque continuo de pre-entrenamiento que alienta a Bert a aprender una distribución isotrópica y discriminativa de las representaciones de token. TACL está completamente sin supervisión y no requiere datos adicionales. Probamos ampliamente nuestro enfoque en una amplia gama de puntos de referencia inglés y chino. Los resultados muestran que TACL trae mejoras consistentes y notables sobre el modelo Bert original. Además, realizamos un análisis detallado para revelar los méritos y el trabajo interno de nuestro enfoque.

Mostramos la comparación entre TACL (versión base) y el Bert original (versión base).

(1) Resultados de referencia en inglés en la puntuación promedio de los escuadrones (Rajpurkar et al., 2018) (set de desarrollo) y pegamento (Wang et al., 2019) .

| Modelo | Escuadrón 1.1 (EM/F1) | Escuadrón 2.0 (EM/F1) | Promedio de pegamento |

|---|---|---|---|

| Bert | 80.8/88.5 | 73.4/76.8 | 79.6 |

| Tacl | 81.6/89.0 | 74.4/77.5 | 81.2 |

(2) Resultados de referencia chinos (conjunto de pruebas F1) en cuatro tareas NER (MSRA, Ontonotes, Reanudar y Weibo) y tres tareas de segmentación de palabras chinas (CWS) (PKU, Cityu y AS).

| Modelo | MSRA | Ontonotes | Reanudar | Pku | Ciudad | COMO | |

|---|---|---|---|---|---|---|---|

| Bert | 94.95 | 80.14 | 95.53 | 68.20 | 96.50 | 97.60 | 96.50 |

| Tacl | 95.44 | 82.42 | 96.45 | 69.54 | 96.75 | 98.16 | 96.75 |

| Nombre del modelo | Dirección modelo |

|---|---|

| Inglés ( Cambridgeltl/Tacl-Base-Base-Inscuye ) | enlace |

| Chino ( Cambridgeltl/Tacl-Base-Base-Chinese ) | enlace |

import torch

# initialize model

from transformers import AutoModel , AutoTokenizer

model_name = 'cambridgeltl/tacl-bert-base-uncased'

model = AutoModel . from_pretrained ( model_name )

tokenizer = AutoTokenizer . from_pretrained ( model_name )

# create input ids

text = '[CLS] clbert is awesome. [SEP]'

tokenized_token_list = tokenizer . tokenize ( text )

input_ids = torch . LongTensor ( tokenizer . convert_tokens_to_ids ( tokenized_token_list )). view ( 1 , - 1 )

# compute hidden states

representation = model ( input_ids ). last_hidden_state # [1, seqlen, embed_dim] python version : 3.8

pip3 install -r requirements.txtConsulte los detalles proporcionados en el directorio ./Prethering_Data.

Consulte los detalles proporcionados en el directorio ./preening.

Consulte los detalles proporcionados en el directorio ./english_benchmark.

chmod +x ./download_benchmark_data.sh

./download_benchmark_data.sh Consulte los detalles proporcionados en el directorio ./chinese_benchmark.

Proporcionamos todo el código esencial para replicar los resultados (las imágenes a continuación) proporcionadas en nuestra sección de análisis. Los códigos e instrucciones relacionados se encuentran en el directorio./Análisis. ¡Divertirse!

Si encuentra útiles nuestro documento y recursos, por favor cita nuestro documento:

@article { DBLP:journals/corr/abs-2111-04198 ,

author = { Yixuan Su and

Fangyu Liu and

Zaiqiao Meng and

Tian Lan and

Lei Shu and

Ehsan Shareghi and

Nigel Collier } ,

title = { TaCL: Improving {BERT} Pre-training with Token-aware Contrastive Learning } ,

journal = { CoRR } ,

volume = { abs/2111.04198 } ,

year = { 2021 } ,

url = { https://arxiv.org/abs/2111.04198 } ,

eprinttype = { arXiv } ,

eprint = { 2111.04198 } ,

timestamp = { Wed, 10 Nov 2021 16:07:30 +0100 } ,

biburl = { https://dblp.org/rec/journals/corr/abs-2111-04198.bib } ,

bibsource = { dblp computer science bibliography, https://dblp.org }

}Si tiene alguna pregunta, no dude en contactarme a través de ([email protected]).