Гибкий пакет для мультимодального обучения для объединения табличных данных с текстом и изображениями, используя широкие и глубокие модели в Pytorch

Документация: https://pytorch-wededeep.readthedocs.io

Сопутствующие посты и учебные пособия: Infinitoml

Эксперименты и сравнение с LightGBM : Tabulardl vs Lightgbm

Слэк : Если вы хотите внести свой вклад или просто хотите пообщаться с нами, присоединяйтесь к Slack

Содержание этого документа организовано следующим образом:

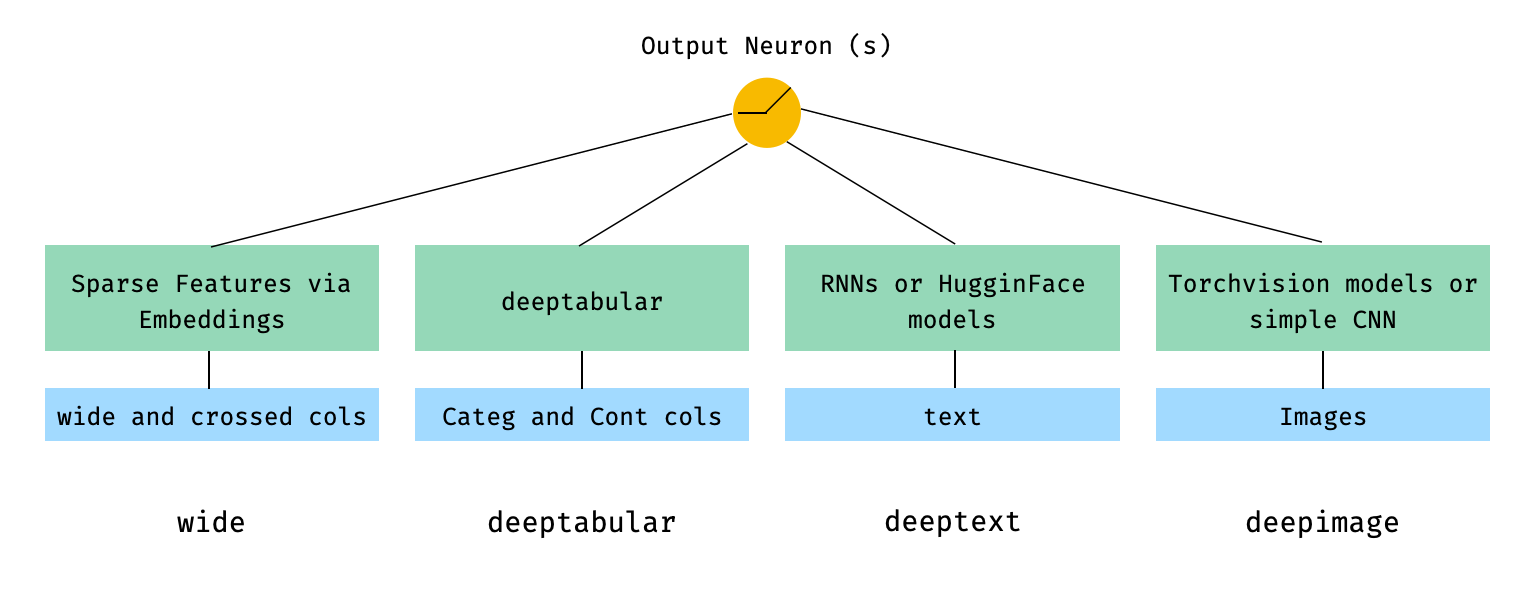

deeptabular компонентrec pytorch-widedeep основан на широком и глубоком алгоритме Google, скорректированном для многомодальных наборов данных.

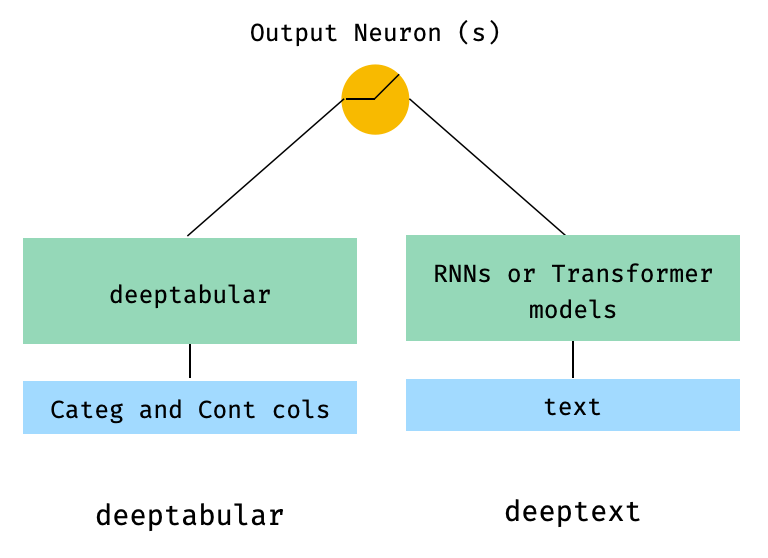

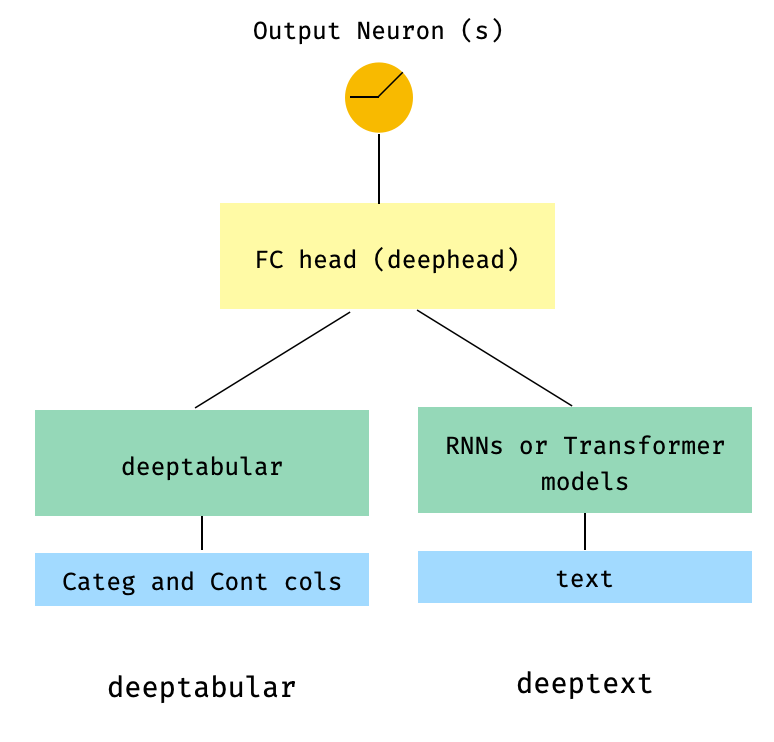

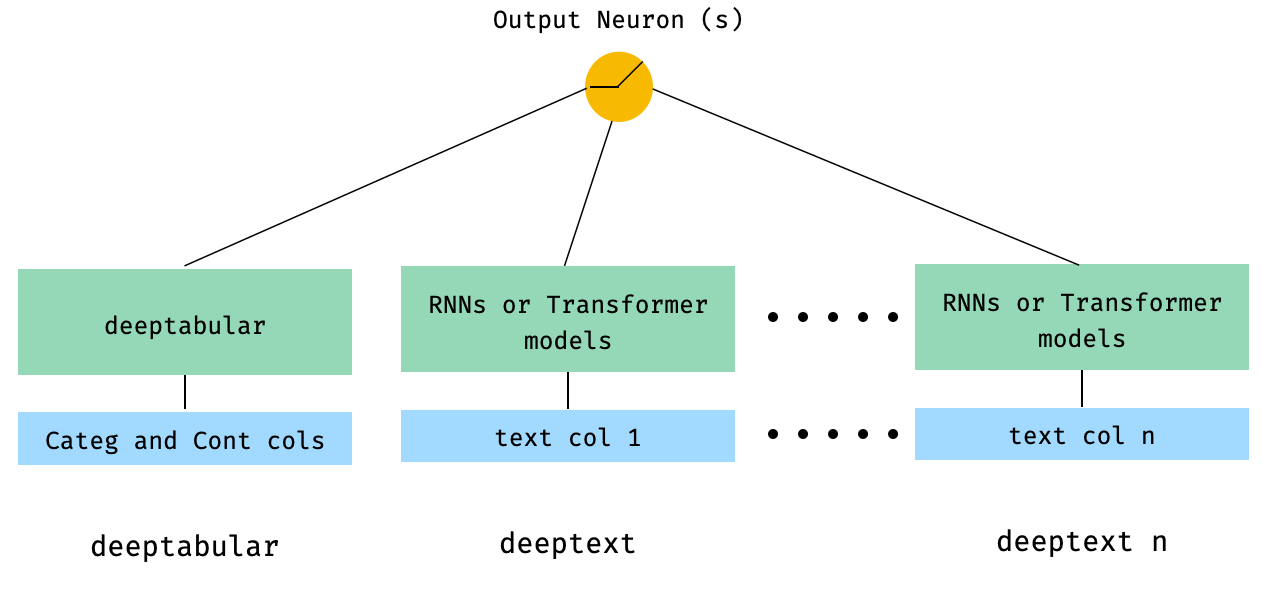

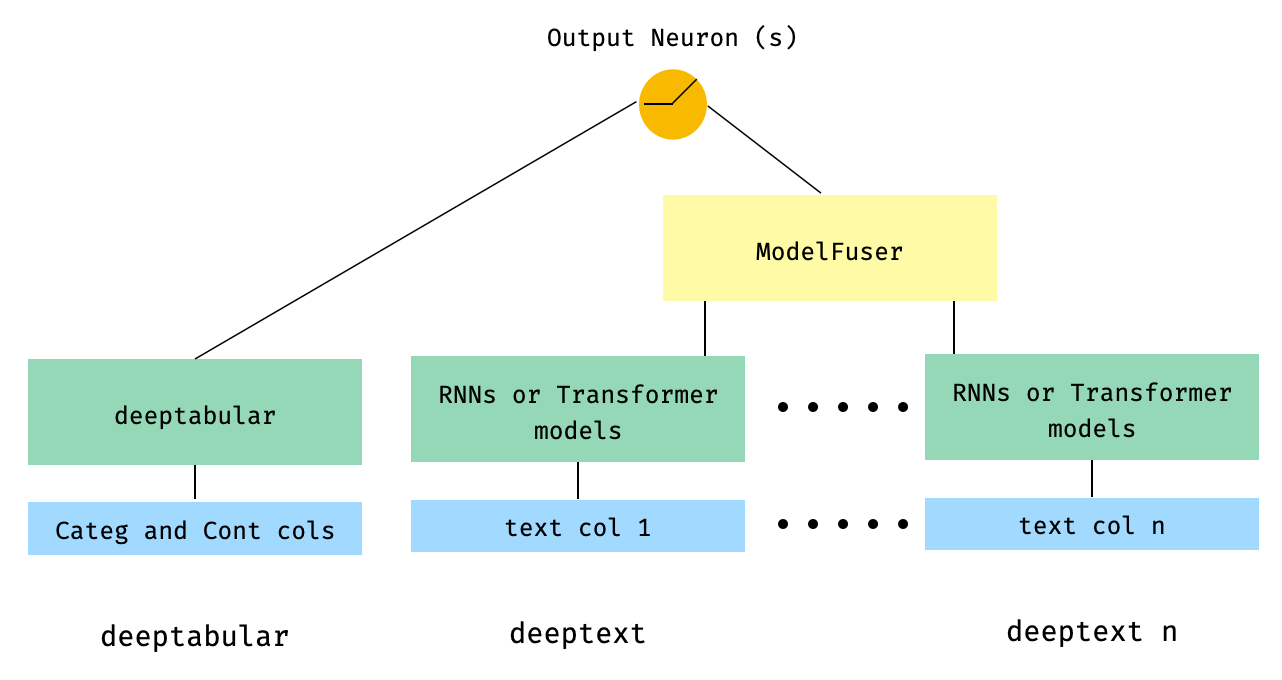

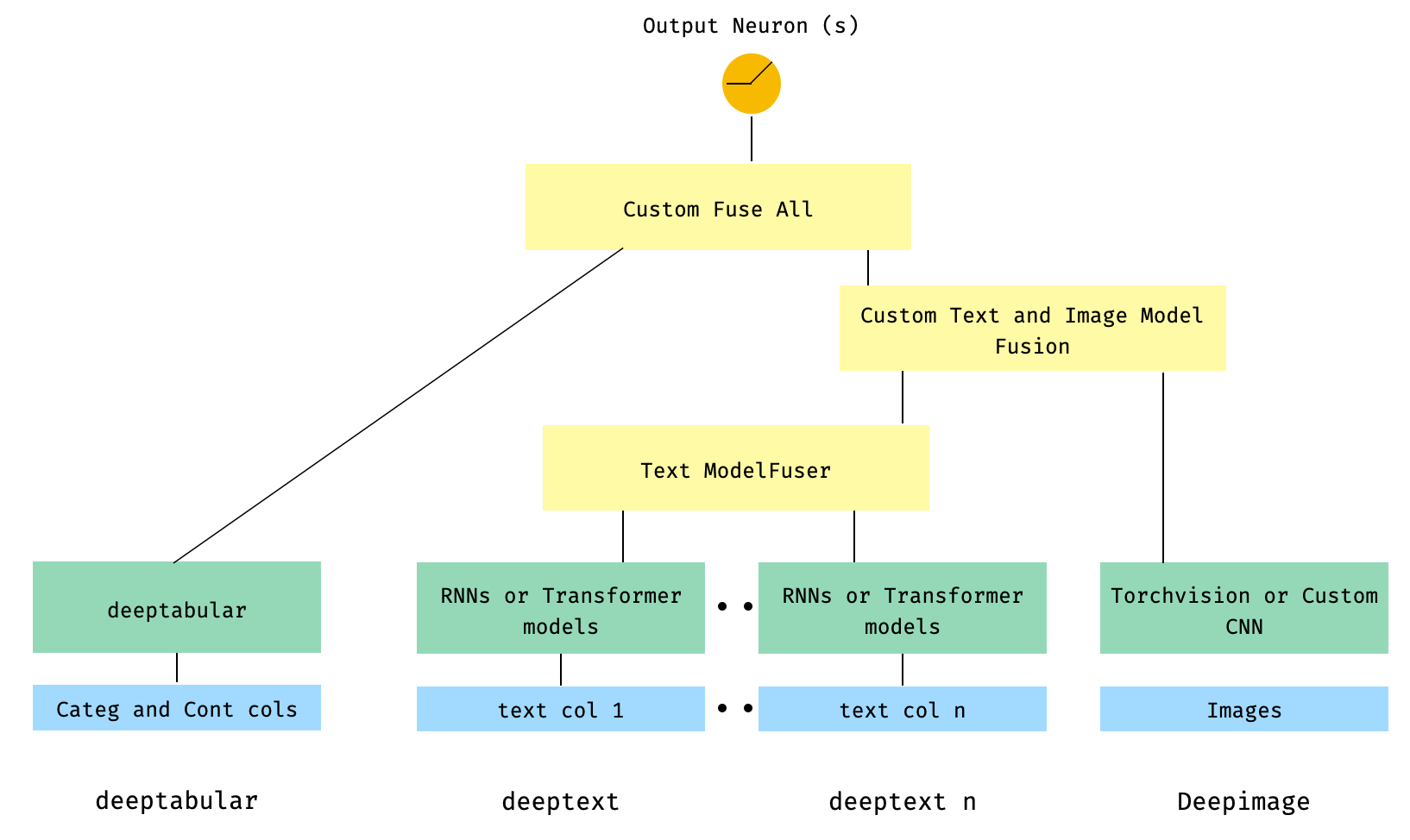

В общих чертах, pytorch-widedeep -это пакет для использования глубокого обучения с табличными данными. В частности, предназначено для облегчения комбинации текста и изображений с соответствующими табличными данными с использованием широких и глубоких моделей. Имея это в виду, есть ряд архитектур, которые могут быть реализованы с библиотекой. Основные компоненты этих архитектур показаны на рисунке ниже:

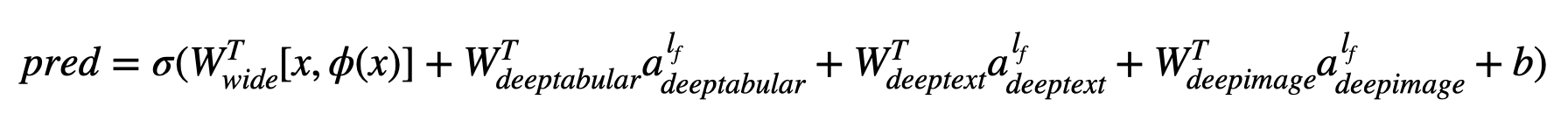

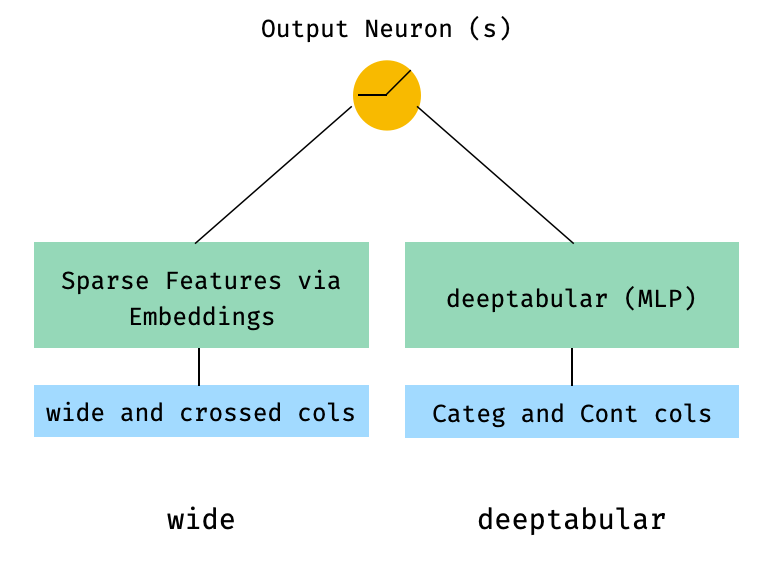

С точки зрения математики, и после обозначения в статье выражение для архитектуры без компонента deephead может быть сформулировано как:

Если σ - сигмоидальная функция, «W» - это матрицы веса, применяемые к широкой модели, и к конечным активациям глубоких моделей, «A» - это эти конечные активации, φ (x) являются преобразованием поперечного продукта исходных признаков «x» , а «B» - это термин смещения. В случае, если вам интересно, что такое «преобразования кросс-продукта» , вот цитата, взятая непосредственно из статьи: «Для бинарных особенностей преобразование перекрестного продукта (например,« и (гендер = женщина, язык = en) »)-это 1, если и только тогда, когда составляющие особенности (« пол = женщина »и« язык = en »)-все 1, и 0 в противном случае».

Вполне возможно использовать пользовательские модели (и не обязательно модели в библиотеке), если у пользовательских моделей есть свойство под названием output_dim с размером последнего уровня активаций, чтобы WideDeep может быть построен. Примеры того, как использовать пользовательские компоненты, можно найти в папке «Примеры» и в разделе ниже.

Библиотека pytorch-widedeep предлагает ряд различных архитектур. В этом разделе мы покажем некоторые из них в их простейшей форме (т.е. в большинстве случаев значений параметров по умолчанию) с соответствующими фрагментами кода. Обратите внимание, что все фрагменты ниже Shoud работают локально. Для более подробного объяснения различных компонентов и их параметров, пожалуйста, обратитесь к документации.

Для примеров ниже мы будем использовать набор данных игрушек, сгенерированный следующим образом:

import os

import random

import numpy as np

import pandas as pd

from PIL import Image

from faker import Faker

def create_and_save_random_image ( image_number , size = ( 32 , 32 )):

if not os . path . exists ( "images" ):

os . makedirs ( "images" )

array = np . random . randint ( 0 , 256 , ( size [ 0 ], size [ 1 ], 3 ), dtype = np . uint8 )

image = Image . fromarray ( array )

image_name = f"image_ { image_number } .png"

image . save ( os . path . join ( "images" , image_name ))

return image_name

fake = Faker ()

cities = [ "New York" , "Los Angeles" , "Chicago" , "Houston" ]

names = [ "Alice" , "Bob" , "Charlie" , "David" , "Eva" ]

data = {

"city" : [ random . choice ( cities ) for _ in range ( 100 )],

"name" : [ random . choice ( names ) for _ in range ( 100 )],

"age" : [ random . uniform ( 18 , 70 ) for _ in range ( 100 )],

"height" : [ random . uniform ( 150 , 200 ) for _ in range ( 100 )],

"sentence" : [ fake . sentence () for _ in range ( 100 )],

"other_sentence" : [ fake . sentence () for _ in range ( 100 )],

"image_name" : [ create_and_save_random_image ( i ) for i in range ( 100 )],

"target" : [ random . choice ([ 0 , 1 ]) for _ in range ( 100 )],

}

df = pd . DataFrame ( data ) Это создаст 100 строк DataFrame и DIR в вашей локальной папке, называемых images с 100 случайными изображениями (или изображениями с просто шумом).

Возможно, самой простой архитектурой будет только один компонент, wide , deeptabular , deeptext или deepimage , что также возможно, но давайте начнем примеры с стандартной широкой и глубокой архитектуры. Оттуда, как построить модель, состоящую только из одного компонента, будет простым.

Обратите внимание, что примеры, показанные ниже, будут почти идентичны, используя любую из моделей, доступных в библиотеке. Например, TabMlp может быть заменен на TabResnet , TabNet , TabTransformer и т. Д. Аналогичным образом, BasicRNN может быть заменен на AttentiveRNN , StackedAttentiveRNN или HFModel с соответствующими параметрами и препроцессором в случае моделей обнимающихся поверхностей.

1. Широкий и табличный компонент (он же Deeptabular)

from pytorch_widedeep . preprocessing import TabPreprocessor , WidePreprocessor

from pytorch_widedeep . models import Wide , TabMlp , WideDeep

from pytorch_widedeep . training import Trainer

# Wide

wide_cols = [ "city" ]

crossed_cols = [( "city" , "name" )]

wide_preprocessor = WidePreprocessor ( wide_cols = wide_cols , crossed_cols = crossed_cols )

X_wide = wide_preprocessor . fit_transform ( df )

wide = Wide ( input_dim = np . unique ( X_wide ). shape [ 0 ])

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 64 , 32 ],

)

# WideDeep

model = WideDeep ( wide = wide , deeptabular = tab_mlp )

# Train

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_wide = X_wide ,

X_tab = X_tab ,

target = df [ "target" ]. values ,

n_epochs = 1 ,

batch_size = 32 ,

)2. табличные и текстовые данные

from pytorch_widedeep . preprocessing import TabPreprocessor , TextPreprocessor

from pytorch_widedeep . models import TabMlp , BasicRNN , WideDeep

from pytorch_widedeep . training import Trainer

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 64 , 32 ],

)

# Text

text_preprocessor = TextPreprocessor (

text_col = "sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text = text_preprocessor . fit_transform ( df )

rnn = BasicRNN (

vocab_size = len ( text_preprocessor . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

# WideDeep

model = WideDeep ( deeptabular = tab_mlp , deeptext = rnn )

# Train

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_tab = X_tab ,

X_text = X_text ,

target = df [ "target" ]. values ,

n_epochs = 1 ,

batch_size = 32 ,

) 3. Таблица и текст с головой FC сверху через head_hidden_dims Param в WideDeep

from pytorch_widedeep . preprocessing import TabPreprocessor , TextPreprocessor

from pytorch_widedeep . models import TabMlp , BasicRNN , WideDeep

from pytorch_widedeep . training import Trainer

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 64 , 32 ],

)

# Text

text_preprocessor = TextPreprocessor (

text_col = "sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text = text_preprocessor . fit_transform ( df )

rnn = BasicRNN (

vocab_size = len ( text_preprocessor . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

# WideDeep

model = WideDeep ( deeptabular = tab_mlp , deeptext = rnn , head_hidden_dims = [ 32 , 16 ])

# Train

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_tab = X_tab ,

X_text = X_text ,

target = df [ "target" ]. values ,

n_epochs = 1 ,

batch_size = 32 ,

) 4. Табличные и несколько текстовых столбцов, которые передаются непосредственно в WideDeep

from pytorch_widedeep . preprocessing import TabPreprocessor , TextPreprocessor

from pytorch_widedeep . models import TabMlp , BasicRNN , WideDeep

from pytorch_widedeep . training import Trainer

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 64 , 32 ],

)

# Text

text_preprocessor_1 = TextPreprocessor (

text_col = "sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text_1 = text_preprocessor_1 . fit_transform ( df )

text_preprocessor_2 = TextPreprocessor (

text_col = "other_sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text_2 = text_preprocessor_2 . fit_transform ( df )

rnn_1 = BasicRNN (

vocab_size = len ( text_preprocessor_1 . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

rnn_2 = BasicRNN (

vocab_size = len ( text_preprocessor_2 . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

# WideDeep

model = WideDeep ( deeptabular = tab_mlp , deeptext = [ rnn_1 , rnn_2 ])

# Train

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_tab = X_tab ,

X_text = [ X_text_1 , X_text_2 ],

target = df [ "target" ]. values ,

n_epochs = 1 ,

batch_size = 32 ,

) 5. Табличные данные и несколько текстовых столбцов, которые слиты через класс ModelFuser Библиотеки

from pytorch_widedeep . preprocessing import TabPreprocessor , TextPreprocessor

from pytorch_widedeep . models import TabMlp , BasicRNN , WideDeep , ModelFuser

from pytorch_widedeep import Trainer

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 64 , 32 ],

)

# Text

text_preprocessor_1 = TextPreprocessor (

text_col = "sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text_1 = text_preprocessor_1 . fit_transform ( df )

text_preprocessor_2 = TextPreprocessor (

text_col = "other_sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text_2 = text_preprocessor_2 . fit_transform ( df )

rnn_1 = BasicRNN (

vocab_size = len ( text_preprocessor_1 . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

rnn_2 = BasicRNN (

vocab_size = len ( text_preprocessor_2 . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

models_fuser = ModelFuser ( models = [ rnn_1 , rnn_2 ], fusion_method = "mult" )

# WideDeep

model = WideDeep ( deeptabular = tab_mlp , deeptext = models_fuser )

# Train

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_tab = X_tab ,

X_text = [ X_text_1 , X_text_2 ],

target = df [ "target" ]. values ,

n_epochs = 1 ,

batch_size = 32 ,

) 6. Табличные и несколько текстовых столбцов, с столбцом изображения. Текстовые столбцы объединены через ModelFuser библиотеки, а затем все спланированы через Deephead Paramenter в WideDeep , который является пользовательским ModelFuser кодированием пользователем

Это, пожалуй, менее элегантное решение, поскольку оно включает в себя пользовательский компонент пользователем и нарезание «входящего» тензора. В будущем мы включим TextAndImageModelFuser , чтобы сделать этот процесс более простым. Тем не менее, не очень сложный, и это хороший пример того, как использовать пользовательские компоненты в pytorch-widedeep .

Обратите внимание, что единственным требованием для пользовательского компонента является то, что он имеет свойство, называемое output_dim , которое возвращает размер последнего уровня активаций. Другими словами, он не должен наследовать от BaseWDModelComponent . Этот базовый класс просто проверяет существование такого свойства и избегает некоторых ошибок печати внутри.

import torch

from pytorch_widedeep . preprocessing import TabPreprocessor , TextPreprocessor , ImagePreprocessor

from pytorch_widedeep . models import TabMlp , BasicRNN , WideDeep , ModelFuser , Vision

from pytorch_widedeep . models . _base_wd_model_component import BaseWDModelComponent

from pytorch_widedeep import Trainer

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 16 , 8 ],

)

# Text

text_preprocessor_1 = TextPreprocessor (

text_col = "sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text_1 = text_preprocessor_1 . fit_transform ( df )

text_preprocessor_2 = TextPreprocessor (

text_col = "other_sentence" , maxlen = 20 , max_vocab = 100 , n_cpus = 1

)

X_text_2 = text_preprocessor_2 . fit_transform ( df )

rnn_1 = BasicRNN (

vocab_size = len ( text_preprocessor_1 . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

rnn_2 = BasicRNN (

vocab_size = len ( text_preprocessor_2 . vocab . itos ),

embed_dim = 16 ,

hidden_dim = 8 ,

n_layers = 1 ,

)

models_fuser = ModelFuser (

models = [ rnn_1 , rnn_2 ],

fusion_method = "mult" ,

)

# Image

image_preprocessor = ImagePreprocessor ( img_col = "image_name" , img_path = "images" )

X_img = image_preprocessor . fit_transform ( df )

vision = Vision ( pretrained_model_setup = "resnet18" , head_hidden_dims = [ 16 , 8 ])

# deephead (custom model fuser)

class MyModelFuser ( BaseWDModelComponent ):

"""

Simply a Linear + Relu sequence on top of the text + images followed by a

Linear -> Relu -> Linear for the concatenation of tabular slice of the

tensor and the output of the text and image sequential model

"""

def __init__ (

self ,

tab_incoming_dim : int ,

text_incoming_dim : int ,

image_incoming_dim : int ,

output_units : int ,

):

super ( MyModelFuser , self ). __init__ ()

self . tab_incoming_dim = tab_incoming_dim

self . text_incoming_dim = text_incoming_dim

self . image_incoming_dim = image_incoming_dim

self . output_units = output_units

self . text_and_image_fuser = torch . nn . Sequential (

torch . nn . Linear ( text_incoming_dim + image_incoming_dim , output_units ),

torch . nn . ReLU (),

)

self . out = torch . nn . Sequential (

torch . nn . Linear ( output_units + tab_incoming_dim , output_units * 4 ),

torch . nn . ReLU (),

torch . nn . Linear ( output_units * 4 , output_units ),

)

def forward ( self , X : torch . Tensor ) -> torch . Tensor :

tab_slice = slice ( 0 , self . tab_incoming_dim )

text_slice = slice (

self . tab_incoming_dim , self . tab_incoming_dim + self . text_incoming_dim

)

image_slice = slice (

self . tab_incoming_dim + self . text_incoming_dim ,

self . tab_incoming_dim + self . text_incoming_dim + self . image_incoming_dim ,

)

X_tab = X [:, tab_slice ]

X_text = X [:, text_slice ]

X_img = X [:, image_slice ]

X_text_and_image = self . text_and_image_fuser ( torch . cat ([ X_text , X_img ], dim = 1 ))

return self . out ( torch . cat ([ X_tab , X_text_and_image ], dim = 1 ))

@ property

def output_dim ( self ):

return self . output_units

deephead = MyModelFuser (

tab_incoming_dim = tab_mlp . output_dim ,

text_incoming_dim = models_fuser . output_dim ,

image_incoming_dim = vision . output_dim ,

output_units = 8 ,

)

# WideDeep

model = WideDeep (

deeptabular = tab_mlp ,

deeptext = models_fuser ,

deepimage = vision ,

deephead = deephead ,

)

# Train

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_tab = X_tab ,

X_text = [ X_text_1 , X_text_2 ],

X_img = X_img ,

target = df [ "target" ]. values ,

n_epochs = 1 ,

batch_size = 32 ,

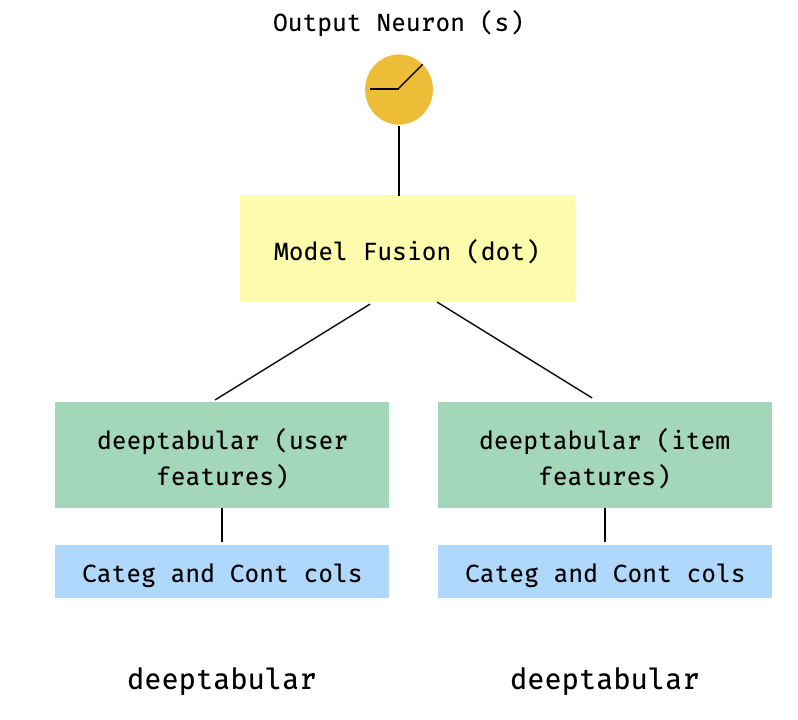

)7. Модель с двумя башнями

Это популярная модель в контексте систем рекомендаций. Допустим, у нас есть табличный набор данных, сформированный мои тройки (пользовательские функции, функции элемента, цель). Мы можем создать модель с двумя башнями, где пользователь и функции элемента передаются через две отдельные модели, а затем «слитые» через точечный продукт.

import numpy as np

import pandas as pd

from pytorch_widedeep import Trainer

from pytorch_widedeep . preprocessing import TabPreprocessor

from pytorch_widedeep . models import TabMlp , WideDeep , ModelFuser

# Let's create the interaction dataset

# user_features dataframe

np . random . seed ( 42 )

user_ids = np . arange ( 1 , 101 )

ages = np . random . randint ( 18 , 60 , size = 100 )

genders = np . random . choice ([ "male" , "female" ], size = 100 )

locations = np . random . choice ([ "city_a" , "city_b" , "city_c" , "city_d" ], size = 100 )

user_features = pd . DataFrame (

{ "id" : user_ids , "age" : ages , "gender" : genders , "location" : locations }

)

# item_features dataframe

item_ids = np . arange ( 1 , 101 )

prices = np . random . uniform ( 10 , 500 , size = 100 ). round ( 2 )

colors = np . random . choice ([ "red" , "blue" , "green" , "black" ], size = 100 )

categories = np . random . choice ([ "electronics" , "clothing" , "home" , "toys" ], size = 100 )

item_features = pd . DataFrame (

{ "id" : item_ids , "price" : prices , "color" : colors , "category" : categories }

)

# Interactions dataframe

interaction_user_ids = np . random . choice ( user_ids , size = 1000 )

interaction_item_ids = np . random . choice ( item_ids , size = 1000 )

purchased = np . random . choice ([ 0 , 1 ], size = 1000 , p = [ 0.7 , 0.3 ])

interactions = pd . DataFrame (

{

"user_id" : interaction_user_ids ,

"item_id" : interaction_item_ids ,

"purchased" : purchased ,

}

)

user_item_purchased = interactions . merge (

user_features , left_on = "user_id" , right_on = "id"

). merge ( item_features , left_on = "item_id" , right_on = "id" )

# Users

tab_preprocessor_user = TabPreprocessor (

cat_embed_cols = [ "gender" , "location" ],

continuous_cols = [ "age" ],

)

X_user = tab_preprocessor_user . fit_transform ( user_item_purchased )

tab_mlp_user = TabMlp (

column_idx = tab_preprocessor_user . column_idx ,

cat_embed_input = tab_preprocessor_user . cat_embed_input ,

continuous_cols = [ "age" ],

mlp_hidden_dims = [ 16 , 8 ],

mlp_dropout = [ 0.2 , 0.2 ],

)

# Items

tab_preprocessor_item = TabPreprocessor (

cat_embed_cols = [ "color" , "category" ],

continuous_cols = [ "price" ],

)

X_item = tab_preprocessor_item . fit_transform ( user_item_purchased )

tab_mlp_item = TabMlp (

column_idx = tab_preprocessor_item . column_idx ,

cat_embed_input = tab_preprocessor_item . cat_embed_input ,

continuous_cols = [ "price" ],

mlp_hidden_dims = [ 16 , 8 ],

mlp_dropout = [ 0.2 , 0.2 ],

)

two_tower_model = ModelFuser ([ tab_mlp_user , tab_mlp_item ], fusion_method = "dot" )

model = WideDeep ( deeptabular = two_tower_model )

trainer = Trainer ( model , objective = "binary" )

trainer . fit (

X_tab = [ X_user , X_item ],

target = interactions . purchased . values ,

n_epochs = 1 ,

batch_size = 32 ,

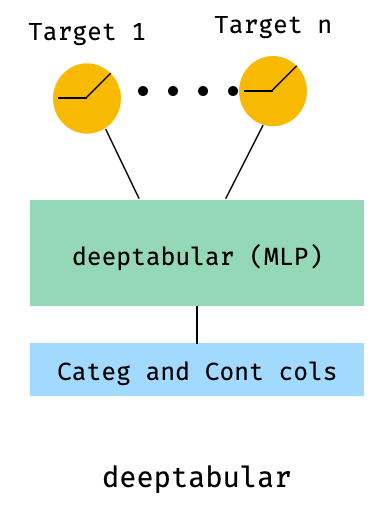

)8. таблица с многоцелевой потерей

Это «бонус», чтобы проиллюстрировать использование многоцелевых потерь, больше, чем на самом деле другая архитектура.

from pytorch_widedeep . preprocessing import TabPreprocessor , TextPreprocessor , ImagePreprocessor

from pytorch_widedeep . models import TabMlp , BasicRNN , WideDeep , ModelFuser , Vision

from pytorch_widedeep . losses_multitarget import MultiTargetClassificationLoss

from pytorch_widedeep . models . _base_wd_model_component import BaseWDModelComponent

from pytorch_widedeep import Trainer

# let's add a second target to the dataframe

df [ "target2" ] = [ random . choice ([ 0 , 1 ]) for _ in range ( 100 )]

# Tabular

tab_preprocessor = TabPreprocessor (

embed_cols = [ "city" , "name" ], continuous_cols = [ "age" , "height" ]

)

X_tab = tab_preprocessor . fit_transform ( df )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = tab_preprocessor . continuous_cols ,

mlp_hidden_dims = [ 64 , 32 ],

)

# 'pred_dim=2' because we have two binary targets. For other types of targets,

# please, see the documentation

model = WideDeep ( deeptabular = tab_mlp , pred_dim = 2 ).

loss = MultiTargetClassificationLoss ( binary_config = [ 0 , 1 ], reduction = "mean" )

# When a multi-target loss is used, 'custom_loss_function' must not be None.

# See the docs

trainer = Trainer ( model , objective = "multitarget" , custom_loss_function = loss )

trainer . fit (

X_tab = X_tab ,

target = df [[ "target" , "target2" ]]. values ,

n_epochs = 1 ,

batch_size = 32 ,

)deeptabular компонент Важно еще раз подчеркнуть, что каждый отдельный компонент, wide , deeptabular , deeptext и deepimage , может использоваться независимо и в изоляции. Например, можно использовать только wide , что находится в линейной модели. Фактически, одной из наиболее интересных функций в pytorch-widedeep было бы использование deeptabular компонента самостоятельно, то есть то, что обычно можно назвать глубоким обучением для табличных данных. В настоящее время pytorch-widedeep предлагает следующие различные модели для этого компонента:

Две более простые модели, основанные на внимании, мы называем:

Семейство Tabformer , т.е. Трансформаторы для табличных данных:

И вероятностные модели DL для табличных данных на основе неопределенности веса в нейронных сетях:

Wide модели.TabMlpОбратите внимание, что, хотя существуют научные публикации для TabTransformer, Saint и FT-Transformer, Tabfasfformer и Tabperceiver-это наша собственная адаптация этих алгоритмов для табличных данных.

Кроме того, самоотверженное предварительное обучение может быть использовано для всех моделей deeptabular , за исключением TabPerceiver . Самоподобный предварительный тренировку может использоваться двумя методами или процедурами, которые мы называем: метод энкодера-декодера и метод инфрастионного разжигания. Пожалуйста, смотрите документацию и примеры для получения подробной информации об этой функции и всех других вариантов в библиотеке.

recЭтот модуль был введен в качестве расширения для существующих компонентов в библиотеке, решая вопросы и вопросы, связанные с системами рекомендаций. Несмотря на то, что он все еще находится под активной разработкой, в настоящее время он включает в себя количество мощных рекомендательных моделей.

Стоит отметить, что эта библиотека уже поддержала реализацию различных алгоритмов рекомендаций с использованием существующих компонентов. Например, такие модели, как широкая и глубокая, двусторонняя или нейронная совместная фильтрация, могут быть построены с использованием основных функций библиотеки.

Алгоритмы рекомендаций в модуле rec :

Смотрите примеры для получения подробной информации о том, как использовать эти модели.

Для текстового компонента, deeptext , библиотека предлагает следующие модели:

Для компонента изображения, deepimage , библиотека поддерживает модели из следующих семей: «Resnet», «Shufflenet», «resnext», «Wide_resnet», «Regnet», «Densenet», «Mobilenetv3», «Mobilenetv2», «mnasnet», «Effuernet» и «Squeezenet». Они предлагаются через torchvision и завернуты в класс Vision .

Установите с помощью PIP:

pip install pytorch-widedeepИли установить непосредственно из GitHub

pip install git+https://github.com/jrzaurin/pytorch-widedeep.git # Clone the repository

git clone https://github.com/jrzaurin/pytorch-widedeep

cd pytorch-widedeep

# Install in dev mode

pip install -e . Вот сквозное пример бинарной классификации с набором данных для взрослых, используя Wide и DeepDense настройки и по умолчанию.

Создание широкой (линейной) и глубокой модели с pytorch-widedeep :

import numpy as np

import torch

from sklearn . model_selection import train_test_split

from pytorch_widedeep import Trainer

from pytorch_widedeep . preprocessing import WidePreprocessor , TabPreprocessor

from pytorch_widedeep . models import Wide , TabMlp , WideDeep

from pytorch_widedeep . metrics import Accuracy

from pytorch_widedeep . datasets import load_adult

df = load_adult ( as_frame = True )

df [ "income_label" ] = ( df [ "income" ]. apply ( lambda x : ">50K" in x )). astype ( int )

df . drop ( "income" , axis = 1 , inplace = True )

df_train , df_test = train_test_split ( df , test_size = 0.2 , stratify = df . income_label )

# Define the 'column set up'

wide_cols = [

"education" ,

"relationship" ,

"workclass" ,

"occupation" ,

"native-country" ,

"gender" ,

]

crossed_cols = [( "education" , "occupation" ), ( "native-country" , "occupation" )]

cat_embed_cols = [

"workclass" ,

"education" ,

"marital-status" ,

"occupation" ,

"relationship" ,

"race" ,

"gender" ,

"capital-gain" ,

"capital-loss" ,

"native-country" ,

]

continuous_cols = [ "age" , "hours-per-week" ]

target = "income_label"

target = df_train [ target ]. values

# prepare the data

wide_preprocessor = WidePreprocessor ( wide_cols = wide_cols , crossed_cols = crossed_cols )

X_wide = wide_preprocessor . fit_transform ( df_train )

tab_preprocessor = TabPreprocessor (

cat_embed_cols = cat_embed_cols , continuous_cols = continuous_cols # type: ignore[arg-type]

)

X_tab = tab_preprocessor . fit_transform ( df_train )

# build the model

wide = Wide ( input_dim = np . unique ( X_wide ). shape [ 0 ], pred_dim = 1 )

tab_mlp = TabMlp (

column_idx = tab_preprocessor . column_idx ,

cat_embed_input = tab_preprocessor . cat_embed_input ,

continuous_cols = continuous_cols ,

)

model = WideDeep ( wide = wide , deeptabular = tab_mlp )

# train and validate

trainer = Trainer ( model , objective = "binary" , metrics = [ Accuracy ])

trainer . fit (

X_wide = X_wide ,

X_tab = X_tab ,

target = target ,

n_epochs = 5 ,

batch_size = 256 ,

)

# predict on test

X_wide_te = wide_preprocessor . transform ( df_test )

X_tab_te = tab_preprocessor . transform ( df_test )

preds = trainer . predict ( X_wide = X_wide_te , X_tab = X_tab_te )

# Save and load

# Option 1: this will also save training history and lr history if the

# LRHistory callback is used

trainer . save ( path = "model_weights" , save_state_dict = True )

# Option 2: save as any other torch model

torch . save ( model . state_dict (), "model_weights/wd_model.pt" )

# From here in advance, Option 1 or 2 are the same. I assume the user has

# prepared the data and defined the new model components:

# 1. Build the model

model_new = WideDeep ( wide = wide , deeptabular = tab_mlp )

model_new . load_state_dict ( torch . load ( "model_weights/wd_model.pt" ))

# 2. Instantiate the trainer

trainer_new = Trainer ( model_new , objective = "binary" )

# 3. Either start the fit or directly predict

preds = trainer_new . predict ( X_wide = X_wide , X_tab = X_tab , batch_size = 32 )Конечно, можно сделать гораздо больше . Смотрите папку «Примеры», «Документация» или «Сопутствующие посты» для лучшего понимания содержания пакета и его функциональных возможностей.

pytest tests

Проверьте страницу.

Эта библиотека берет на себя серию других библиотек, поэтому я думаю, что это справедливо упомянуть их здесь, в ReadMe (конкретные упоминания также включены в код).

Структура и Callbacks и код Initializers вдохновлены библиотекой torchsample , которая сама по себе частично вдохновлена Keras .

В классе TextProcessor в этой библиотеке используется Tokenizer и Vocab fastai . Код на utils.fastai_transforms является незначительной адаптацией их кода, поэтому он функционирует в этой библиотеке. К моему опыту, их Tokenizer - лучший в классе.

Класс ImageProcessor в этой библиотеке использует код из книги «Фантастическое глубокое обучение для компьютерного зрения» (DL4CV) от Adrian Rosebrock.

Эта работа двойной лицензии в рамках Apache 2.0 и MIT (или любой более поздней версии). Вы можете выбрать между одним из них, если вы используете эту работу.

SPDX-License-Identifier: Apache-2.0 AND MIT

@article{Zaurin_pytorch-widedeep_A_flexible_2023,

author = {Zaurin, Javier Rodriguez and Mulinka, Pavol},

doi = {10.21105/joss.05027},

journal = {Journal of Open Source Software},

month = jun,

number = {86},

pages = {5027},

title = {{pytorch-widedeep: A flexible package for multimodal deep learning}},

url = {https://joss.theoj.org/papers/10.21105/joss.05027},

volume = {8},

year = {2023}

}

Zaurin, J. R., & Mulinka, P. (2023). pytorch-widedeep: A flexible package for

multimodal deep learning. Journal of Open Source Software, 8(86), 5027.

https://doi.org/10.21105/joss.05027