Rat (retrieval дополненное поколение) чат-бот в сопровождении Mistral-7B, специально предназначенного для обслуживания клиентов Verizon.

Данные были собраны через итерационную извлечение с использованием файла data_extraction.py. Код интенсивно начинается с 2 ссылок-['https://www.verizon.com/home/internet/','https://community.verizon.com/'], а затем во время выполнения он портит все ссылки на этих двух веб-страницах, и этот процесс продолжается, создавая о данных 1000 Page. Другим источником данных являются пользовательские пейзажи, доступные по адресу https://www.verizon.com/about/terms-conditions/user-guides.

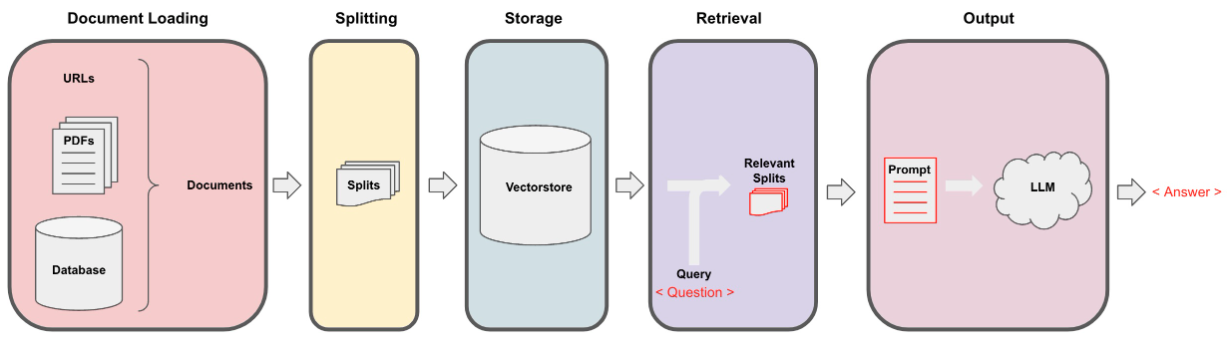

LLMS не может обрабатывать все данные, и поэтому нам нужно разделить данные на небольшие части текстов. Набор данных был разделен на небольшие куски, используя рекурсивные символы, разделяющие от Langchain. Как только у нас появятся маленькие куски, мы сможем создать его вставки, используя модель All-Minilm-L12-V2 с помощью Entgeddings.

После того, как у нас появятся вставки, соответствующие текстовым кускам, мы можем сохранить их в векторной базе данных. Для нашей цели мы использовали VectorStore Faceiss (Facebook AI Searnity Search), поскольку он очень эффективен при расчете сходства по огромному объему данных.

Для поисковой части мы принимаем вопрос пользователя в качестве ввода и находим наиболее подходящие куски, хранящиеся в Vectorstore, используя поиск FAISS, который потенциально может ответить на запрос пользователя.

Как только у нас появятся наши самые подходящие куски, мы сможем назвать их контекстом и передать их на пользовательскую подсказку для нашей модели. Для цели мы использовали следующую подсказку -

[ INST ] You are a Verizon company 's chatbot, Only use the following pieces of context to answer the user' s question . If the answer is not present in context , just say that you don 't know and display the following link "https://www.verizon.com/support/residential/contact-us/contactuslanding.htm", don' t try to make up an answer .[ / INST ]

Context : { context }

Question : { question }

answer : Теперь эта подсказка передается в LLM, чтобы получить вывод. LLM, который мы использовали,-это Mistral-7B (современное состояние с открытым исходным кодом).