RAG (Generación aumentada de recuperación) Chatbot acompañado de Mistral-7B, específicamente adaptado para los servicios al cliente de Verizon.

Los datos se recopilaron a través de la extracción iterativa utilizando el archivo data_extraction.py. El código comienza con solo 2 enlaces-['https://www.verizon.com/home/internet/' ,'https://community.verizon.com/'] y luego en tiempo de ejecución raspa todos los enlaces en estas dos páginas web y este proceso continúa, creando aproximadamente una base de 1000 páginas. Otra fuente de datos son las guías del usuario disponibles en https://www.verizon.com/about/terms-conditions/user-guides.

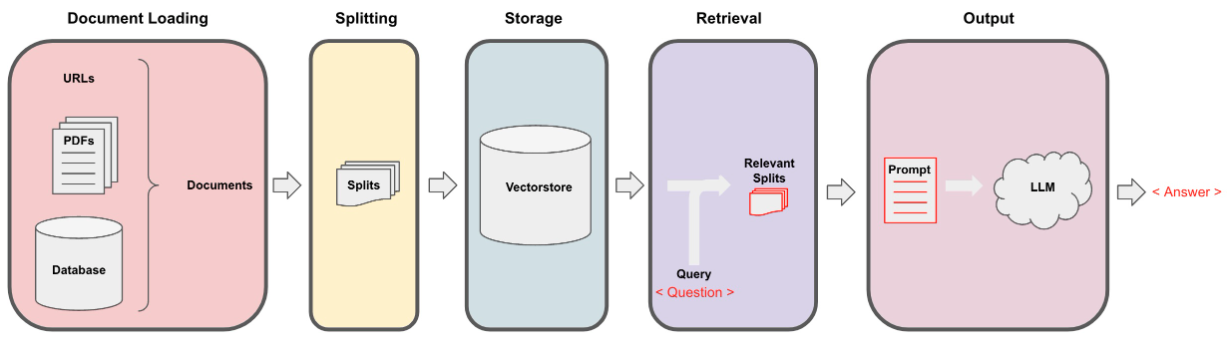

Los LLM no pueden procesar todos los datos y, por lo tanto, necesitamos dividir los datos en pequeñas porciones de textos. El conjunto de datos se dividió en pequeños trozos utilizando la división de carácter recursivo desde Langchain. Una vez que tenemos los trozos pequeños, podemos crear sus incrustaciones utilizando el modelo All-Minilm-L12-V2 a través de embedidas de Huggingface.

Una vez que tenemos los incrustaciones correspondientes a los fragmentos textuales, podemos almacenarlo en una base de datos vectorial. Para nuestro propósito, utilizamos la tienda de vectores FAISS (Facebook AI Simility Search), ya que es altamente eficiente al calcular la similitud sobre una gran cantidad de datos.

Para la parte de recuperación, tomamos la pregunta del usuario como una entrada y encontramos los fragmentos más coincidentes almacenados en la tienda vectorial utilizando la búsqueda FAISS que podría responder a la consulta del usuario.

Una vez que tenemos nuestros trozos más coincidentes, podemos etiquetarlos como contexto y pasarlos a la solicitud personalizada para nuestro modelo. Para fines, utilizamos el siguiente aviso -

[ INST ] You are a Verizon company 's chatbot, Only use the following pieces of context to answer the user' s question . If the answer is not present in context , just say that you don 't know and display the following link "https://www.verizon.com/support/residential/contact-us/contactuslanding.htm", don' t try to make up an answer .[ / INST ]

Context : { context }

Question : { question }

answer : Ahora este aviso se pasa a la LLM para obtener la salida. El LLM que usamos es Mistral-7B (estado actual de código abierto).