Rag (Abruf Augmented Generation) Chatbot begleitet von Mistral-7b, speziell auf Verizon-Kundendienst zugeschnitten.

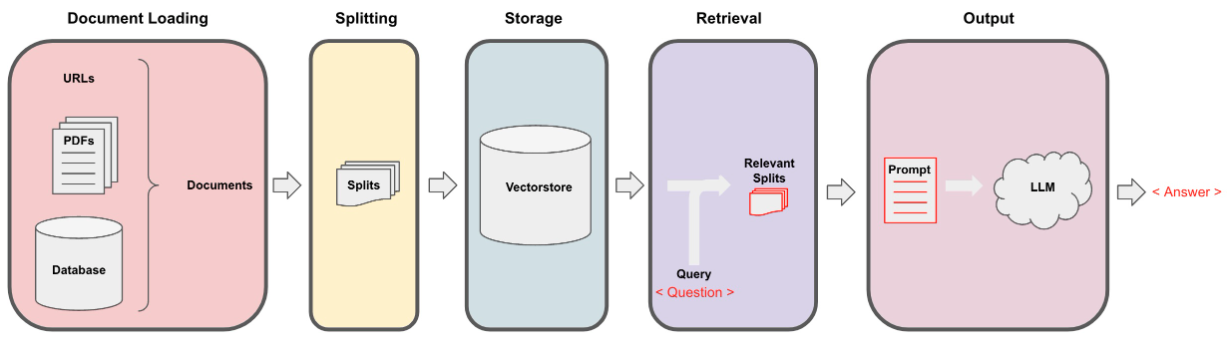

Die Daten wurden über die iterative Extraktion unter Verwendung der Datei data_extraction.py gesammelt. Der Code beginnt intell mit nur 2 Links-['https://www.verizon.com/home/internet/''Https://community.verizon.com/'] und kratzt dann zum Laufzeit alle Links in diesen beiden Webpages, und dieser Vorgang erstellt und erstellt zu einem Datensatz von 1000 Pages. Eine weitere Datenquelle sind die Benutzer-Guides unter https://www.verizon.com/about/terms-conditions/user-guides.

LLMs können nicht die gesamten Daten verarbeiten, und daher müssen wir die Daten in kleine Teile von Texten aufteilen. Der Datensatz wurde unter Verwendung einer rekursiven Zeichenspaltung von Langchain in kleine Stücke aufgeteilt. Sobald wir die kleinen Stücke haben, können wir seine Einbettungen mit dem All-Minilm-L12-V2-Modell über Huggingface-Einbettungen erstellen.

Sobald wir die Einbettungen haben, die den Textbrocken entsprechen, können wir sie in einer Vektor -Datenbank speichern. Für unseren Zweck haben wir die Faiss (Facebook AI -Ähnlichkeitssuche) VectorStore verwendet, da er bei der Berechnung der Ähnlichkeit über eine große Datenmenge sehr wirksam ist.

Für den Abrufteil nehmen wir die Benutzerfrage als Eingabe an und finden die im VectorStore gespeicherten Stücke mit der FAISS -Suche, die möglicherweise die Benutzerabfrage beantworten kann.

Sobald wir unsere passendsten Brocken haben, können wir sie als Kontext bezeichnen und an die benutzerdefinierte Eingabeaufforderung für unser Modell weitergeben. Für den Zweck haben wir die folgende Eingabeaufforderung verwendet -

[ INST ] You are a Verizon company 's chatbot, Only use the following pieces of context to answer the user' s question . If the answer is not present in context , just say that you don 't know and display the following link "https://www.verizon.com/support/residential/contact-us/contactuslanding.htm", don' t try to make up an answer .[ / INST ]

Context : { context }

Question : { question }

answer : Jetzt wird diese Eingabeaufforderung an die LLM übergeben, um die Ausgabe zu erhalten. Das von uns verwendete LLM ist Mistral-7b (aktuelle Open-Source-Stand der Technik).